テキスト生成NVIDIA NIMをLLMブループリントに追加する¶

プレミアム機能

DataRobotでNVIDIA Inference Microservices (NIM)を利用するには、GenAIのエクスペリメントとGPUを使用した推論のためのプレミアム機能にアクセスする必要があります。 これらの機能を有効にするには、DataRobotの担当者または管理者にお問い合わせください。

ユースケースでは、NVIDIA Inference Microservices(NIM)をプレイグラウンドに追加して、プロンプティング、比較、評価を行うことができます。 プレイグラウンドは、LLMブループリントを作成して操作するためのユースケースアセットです。 LLMブループリントは、LLMブループリント設定でキャプチャされた、LLMからの回答を生成するために必要なすべてのコンテキストを表します。 プレイグラウンド内でLLMブループリントの回答を比較して、ビジネス問題の解決のために本番環境で使用するブループリントを決定します。

プレイグラウンドでのテキスト生成NVIDIA NIMのサポート

以下のテキスト生成モデルは、プレイグラウンドではサポートされていません。

llama-2-70b-chatllama-3-swallow-70b-instruct-v0.1llama-3-taiwan-70b-instructllama3-70b-instructllama-3.1-nemotron-ultra-253b-v1llama-3.2-90b-vision-instructmixtral-8x22b-instruct-v01

デプロイされたテキスト生成NVIDIA NIMをプレイグラウンドに追加するには:

-

ワークベンチで、ユースケースディレクトリからユースケースを選択し、プレイグラウンドタブでプレイグラウンドを開くか作成します。

-

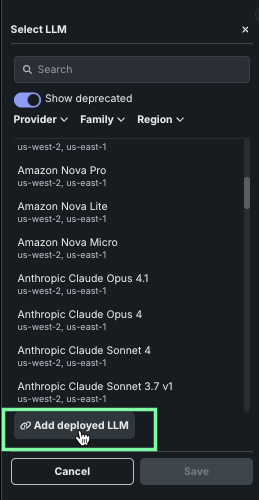

プレイグラウンド内のLLMブループリントタブで、LLMブループリントの作成をクリックして新しいブループリントを追加します。 次に、プレイグラウンドのブループリントの設定パネルから、LLMドロップダウンで デプロイ済みLLMを追加をクリックします。

-

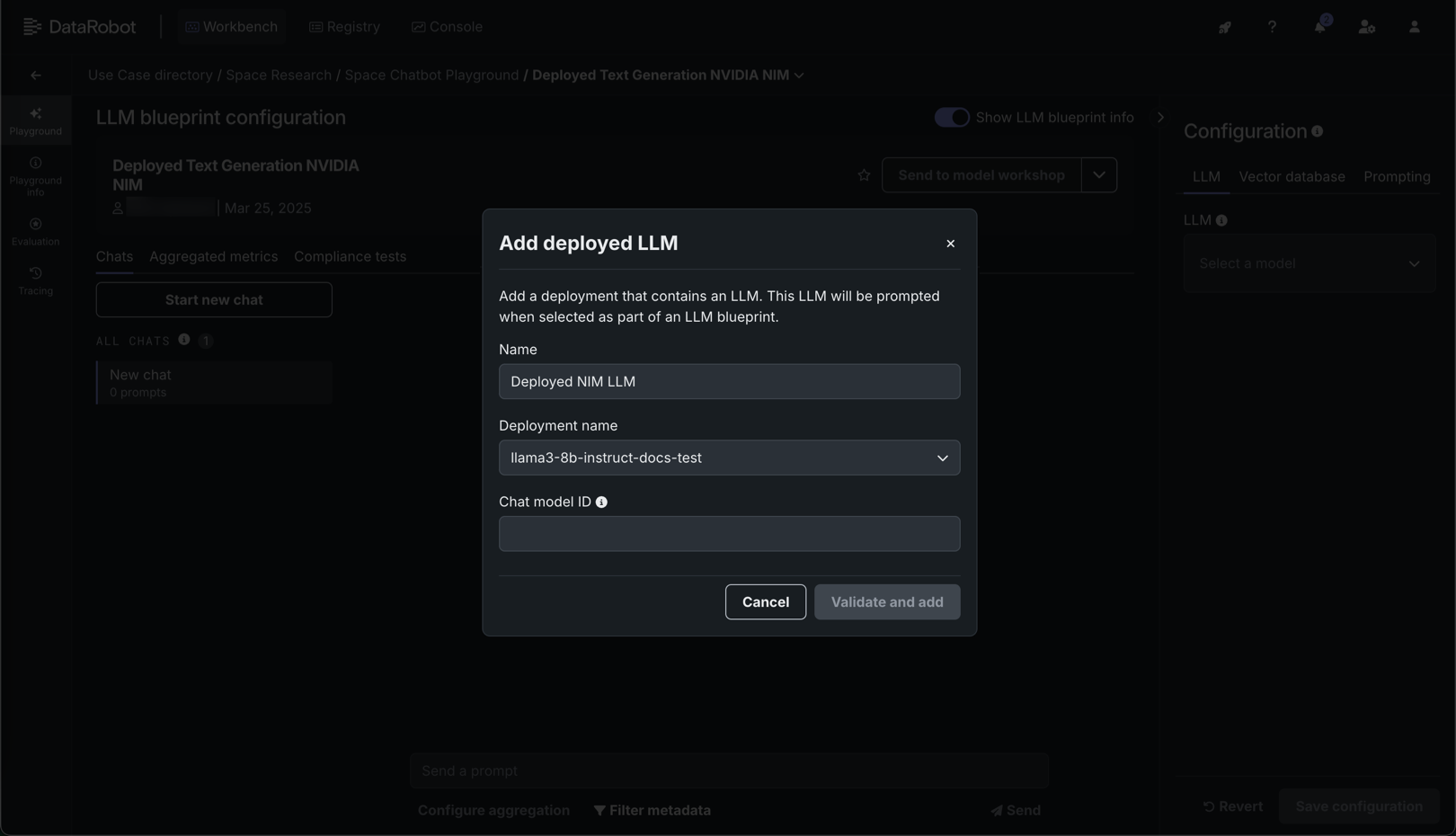

デプロイ済みLLMを追加ダイアログボックスで、デプロイ済みLLMの名前を入力し、デプロイ名ドロップダウンでDataRobotのデプロイを選択します。 チャットモデルIDを入力して、プレイグラウンドからデプロイされたLLMへのリクエストに

modelパラメーターを設定し、検証して追加をクリックします。チャットモデルIDの値

チャットモデルIDを

datarobot-deployed-llmに設定することで、その値を動的に入力することができます。 値をハードコードするには、以下のチャットモデルIDの表を確認し、プレイグラウンドに追加するNVIDIA NIMを探して、チャットモデルID列から値をコピーします。 -

カスタムLLMを追加して検証が成功したら、ブループリントの設定パネルに戻って、LLMドロップダウンでデプロイ済みのLLMをクリックし、追加したカスタムモデルの検証IDを選択します。

-

ベクターデータベースとプロンプティングの設定を行い、設定を保存をクリックして、プレイグラウンドにブループリントを追加します。

チャットモデルIDのリスト

NIMモデルのデプロイでは、チャットモデルIDをdatarobot-deployed-llmに設定することで、その値を動的に入力することができます。 チャットモデルIDの値をハードコードするには、以下の表を確認し、チャットモデルID列から値をコピーします。

| モデル名 | チャットモデルID |

|---|---|

| codellama-13b-instruct | codellama/codellama-13b-instruct |

| codellama-34b-instruct | codellama/codellama-34b-instruct |

| codellama-70b-instruct | codellama/codellama-70b-instruct |

| deepseek-r1-distill-llama-8b | deepseek-ai/deepseek-r1-distill-llama-8b |

| deepseek-r1-distill-qwen-7b | deepseek-ai/deepseek-r1-distill-qwen-7b |

| deepseek-r1-distill-qwen-14b | deepseek-ai/deepseek-r1-distill-qwen-14b |

| deepseek-r1-distill-qwen-32b | deepseek-ai/deepseek-r1-distill-qwen-32b |

| gemma-2-2b-instruct | google/gemma-2-2b-instruct |

| gemma-2-9b-it | google/gemma-2-9b-it |

| gpt-oss-120b | openai/gpt-oss-120b |

| gpt-oss-20b | openai/gpt-oss-20b |

| llama-2-13b-chat | meta/llama-2-13b-chat |

| llama-2-7b-chat | meta/llama-2-7b-chat |

| llama-3-sqlcoder-8b | defog/llama-3-sqlcoder-8b |

| llama-3.1-70b-instruct | meta/llama-3.1-70b-instruct |

| llama-3.1-8b-instruct | meta/llama-3.1-8b-instruct |

| llama-3.1-8b-instruct | meta/llama-3.1-8b-instruct |

| llama-3.1-70b-instruct | meta/llama-3.1-70b-instruct |

| llama-3.1-nemotron-nano-8b-v1 | nvidia/llama-3.1-nemotron-nano-8b-v1 |

| llama-3.1-nemotron-70b-instruct | nvidia/llama-3.1-nemotron-70b-instruct |

| llama-3.1-swallow-70b-instruct-v0.1 | tokyotech-llm/llama-3.1-swallow-70b-instruct-v0.1 |

| llama-3.2-1b-instruct | meta/llama-3.2-1b-instruct |

| llama-3.2-3b-instruct | meta/llama-3.2-3b-instruct |

| llama-3.2-11b-vision-instruct | meta/llama-3.2-11b-vision-instruct |

| llama-3.3-70b-instruct | meta/llama-3.3-70b-instruct |

| llama-3.3-nemotron-super-49b-v1 | nvidia/llama-3.3-nemotron-super-49b-v1 |

| llama-3.3-nemotron-super-49b-v1.5 | nvidia/llama-3-3-nemotron-super-49b-v1-5 |

| llama3-8b-instruct | meta/llama3-8b-instruct |

| mistral-7b-instruct-v0.3 | mistralai/mistral-7b-instruct-v0.3 |

| mistral-nemo-12b-instruct | mistral-nemo-12b-instruct |

| mistral-nemo-minitron-8b-8k-instruct | nv-mistralai/mistral-nemo-minitron-8b-8k-instruct |

| mixtral-8x7b-instruct-v01 | mistralai/mixtral-8x7b-instruct-v0.1 |

| nemotron-3-nano | nvidia/nemotron-3-nano |

| phi-3-mini-4k-instruct | microsoft/phi-3-mini-4k-instruct |

| qwen-2.5-7b-instruct | qwen/qwen-2.5-7b-instruct |

| starcoder2-7b | bigcode/starcoder2-7b |