プレイグラウンドからLLMをデプロイする¶

ユースケースのLLM プレイグラウンドを使用して、 LLMブループリントを作成します。 ベースLLM、およびオプションでシステムプロンプトとベクターデータベースを指定して、ブループリント設定を行います。 回答をテストしてチューニングしたら、ブループリントは登録とデプロイの準備が整います。

LLMブループリントをレジストリのワークショップに送信することで、テキスト生成のカスタムモデルを作成できます。 生成されたカスタムモデルは、ボルトオンのガバナンスAPIを自動的に実装しており、会話型アプリケーションの構築に特に役立ちます。

LLMブループリントをワークショップに追加するには、以下の手順に従います。

-

ユースケースのプレイグラウンドタブで、ブループリントとして登録するLLMを含むプレイグラウンドをクリックします。

-

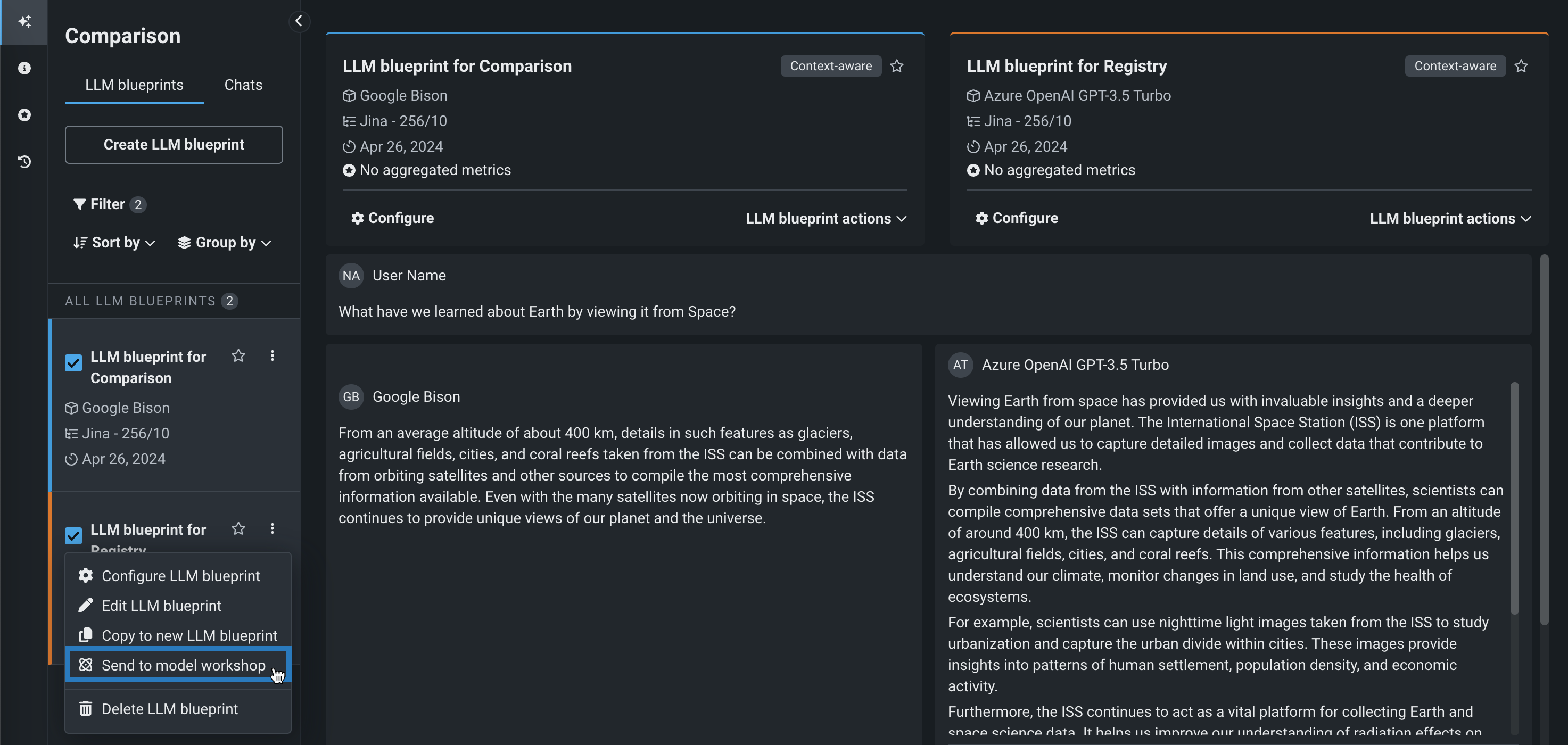

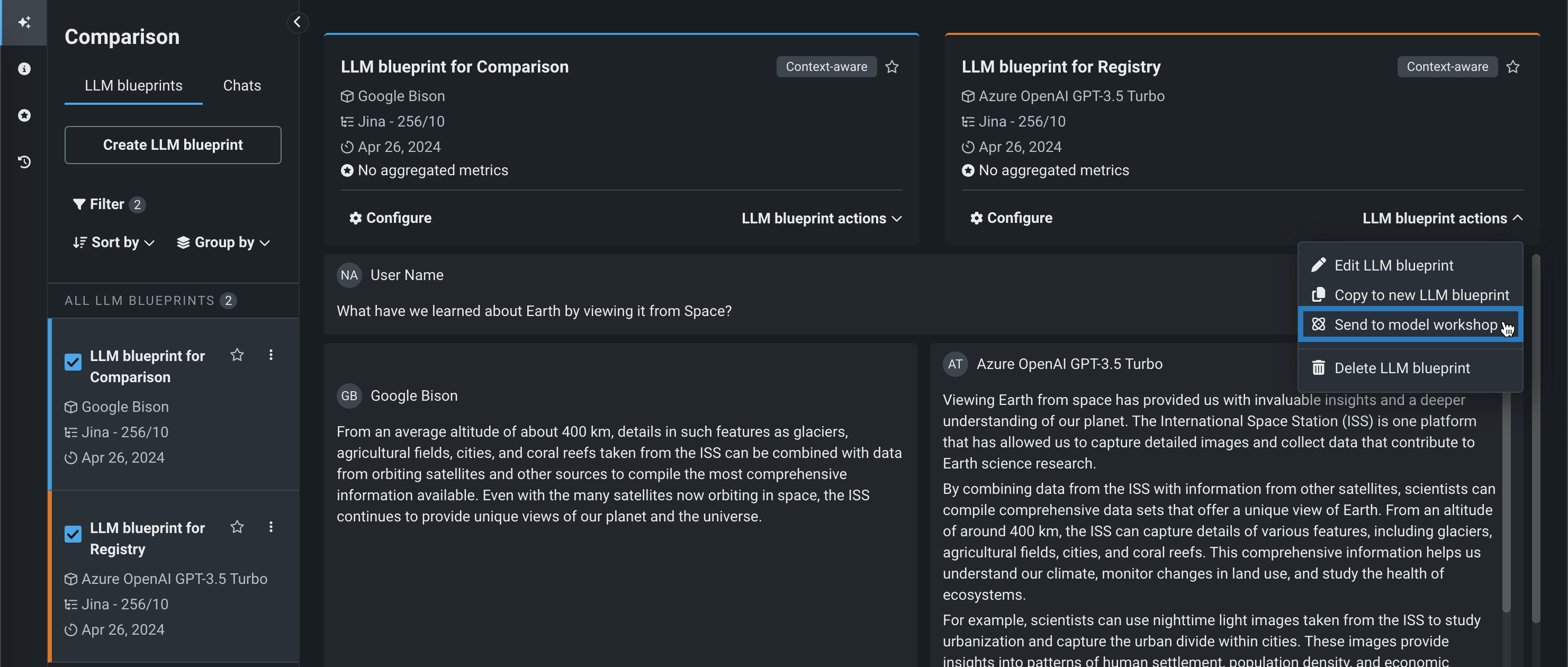

プレイグラウンドでLLMを比較して、ワークショップに送信するLLMブループリントを決定し、次のいずれかを実行します。

-

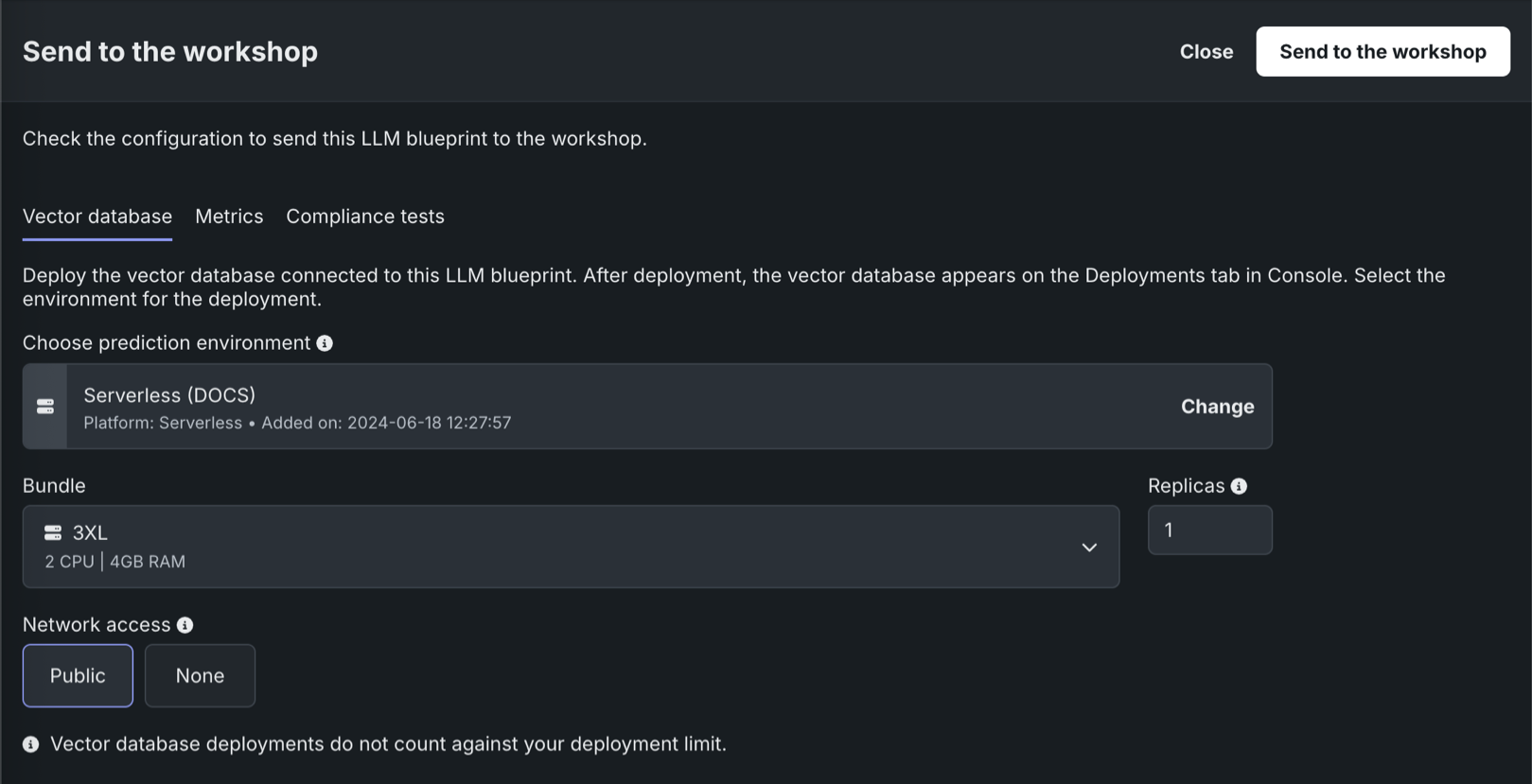

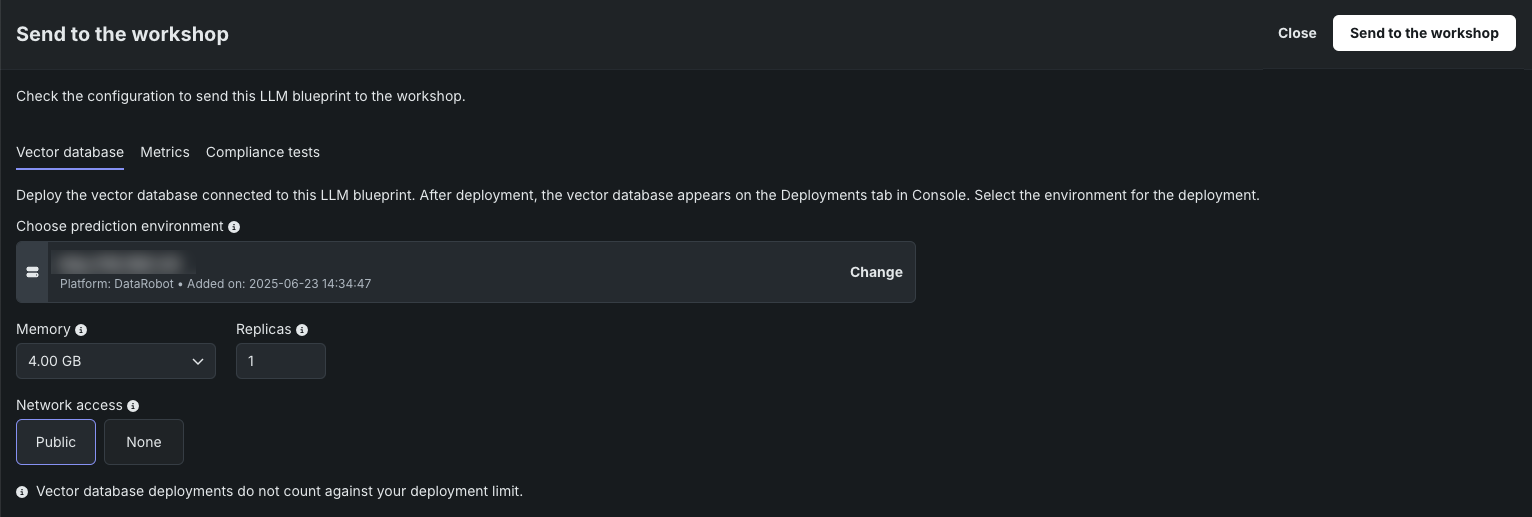

ワークショップに送信 モーダルで以下の操作を行い、ワークショップに送信をクリックします。

-

(オプション)LLMがベクターデータベースを使用する場合、ベクターデータベースタブで以下の設定を行います。

フィールド 説明 予測環境を選択 デプロイされたベクターデータベースの予測環境を決定します。 正しい予測環境(プラットフォーム:DataRobotサーバーレス)が選択されていることを確認します。 メモリー カスタム推論モデルに割り当てることのできるメモリーの最大量を決定します。 設定された最大値以上のメモリーが割り当てられたモデルはシステムによって排除されます。 この問題がテスト中に発生した場合、テストは失敗としてマークされます。 モデルのデプロイ時に発生した場合は、Kubernetesによってモデルが自動的に再起動されます。 バンドル プレビュー機能 組織で有効になっている場合、(メモリーの代わりに)リソースバンドルを選択します。 リソースバンドルを使用すると、さまざまなCPUおよびGPUハードウェアプラットフォームから選択して、ワークショップでカスタムモデルを構築およびテストできます。 レプリカ カスタムモデルの実行時にワークロードのバランスを取るために、並行して実行するレプリカの最大数を設定します。 レプリカの数を増やしても、カスタムモデルの速度に依存するため、パフォーマンスが向上しない場合があります。 ネットワークアクセス プレミアム機能。 カスタムモデルのエグレストラフィックを設定します。 - パブリック:デフォルト設定。 カスタムモデルは、パブリックネットワーク内の任意の完全修飾ドメイン名(FQDN)にアクセスして、サードパーティのサービスを利用できます。

- なし:カスタムモデルはパブリックネットワークから分離されているため、サードパーティのサービスにはアクセスできません。

DATAROBOT_ENDPOINTおよびDATAROBOT_API_TOKEN環境変数を使用できます。 これらの環境変数は、 ドロップイン環境または DRUM上に構築された カスタム環境を使用するすべてのカスタムモデルで使用できます。プレミアム機能:ネットワークアクセス

_新しく_作成したカスタムモデルはすべて、デフォルトでパブリックネットワークにアクセスできます。ただし、2023年10月より前に作成されたカスタムモデルの新しいバージョンを作成した場合、その新しいバージョンは、パブリックアクセスを有効にする(アクセスをパブリックに設定する)まで、パブリックネットワークから隔離された(アクセスがなしに設定された)ままです。 パブリックアクセスを有効にすると、後続の各バージョンは、前のバージョンのパブリックアクセス定義を継承します。

プレビュー機能:リソースバンドル

カスタムモデルのリソースバンドルとGPUリソースのバンドルは、デフォルトではオフになっています。 この機能を有効にする方法については、DataRobotの担当者または管理者にお問い合わせください。

機能フラグ:リソースのバンドルを有効にする、カスタムモデルでGPUを使用した推論を有効にする(プレミアム機能)

ベクターデータベースの自動デプロイ

LLMをベクターデータベースと一緒にプレイグラウンドからワークショップに送信する際に、ベクターデータベースがまだデプロイされていない場合、自動的にデプロイされます。 ワークショップでLLMのコードやファイルを編集する前に、ベクターデータベースをデプロイする必要があります。 ベクターデータベースのデプロイ中は、ワークショップ内のLLMのカスタムモデルは空です。

ベクターデータベースのデプロイでは、どのような監視が可能ですか?

デプロイタイプがベクターデータベースのデプロイでは、ベクターデータベースに関連するカスタム指標が自動的に生成されます。たとえば、Total Documents、Average Documents、Total Citation Tokens、Average Citation Tokens、VDB Score Latencyなどです。 ベクターデータベースのデプロイでは、サービス正常性の監視も可能です。 ベクターデータベースのデプロイでは、データ探索のために予測行レベルのデータが保存されることはありません。

-

LLMに評価指標とモデレーションが設定されている場合は、指標タブで最大12個の評価指標(および設定されているモデレーション)を選択します。

-

コンプライアンステストタブで、LLMと一緒にワークショップに送るテストを選択します。 コンプライアンステストを選択すると、ワークショップに送信され、カスタムモデル登録の一部として含まれます。 これらはまた、 生成されたコンプライアンスドキュメントにも含まれます。

ワークショップでのコンプライアンステスト

選択されたコンプライアンステストは、

LLM_TEST_SUITE_IDランタイムパラメーターによってワークショップのカスタムモデルにリンクされます。 ワークショップでカスタムモデルのコードを大幅に変更した場合は、LLM_TEST_SUITE_IDランタイムパラメーターをNoneに設定して、元のモデル用のコンプライアンスドキュメントが変更後のモデルで実行されないようにします。

-

-

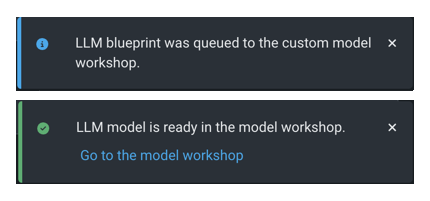

ワークショップに送信をクリックします。 LLMプレイグラウンドの右下隅には、LLMがキューに入れられて登録されると通知が表示されます。 登録完了の通知が表示されたら、ワークショップに移動をクリックします。

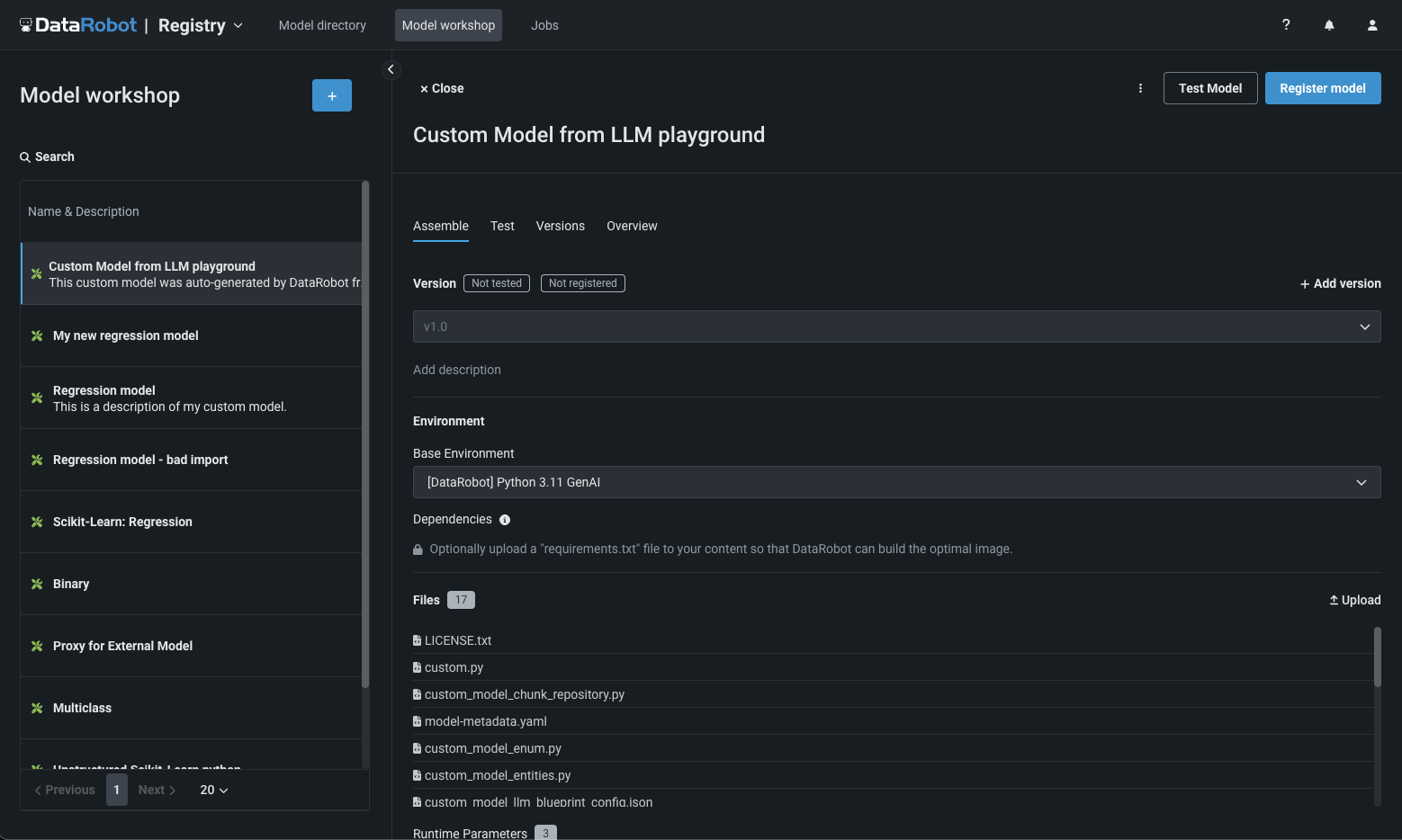

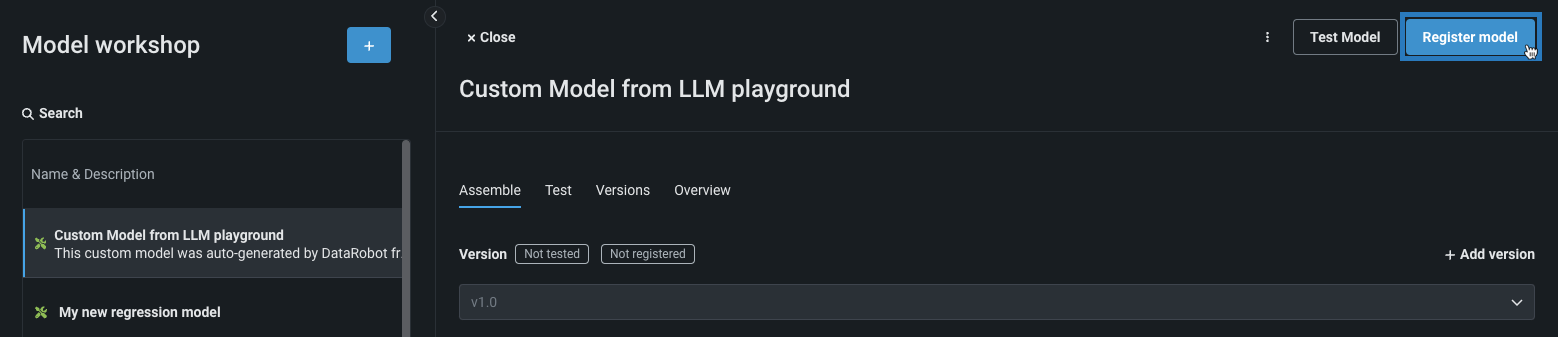

LLMブループリントは、レジストリのワークショップで、ターゲットタイプがテキスト生成のカスタムモデルとして開きます。

-

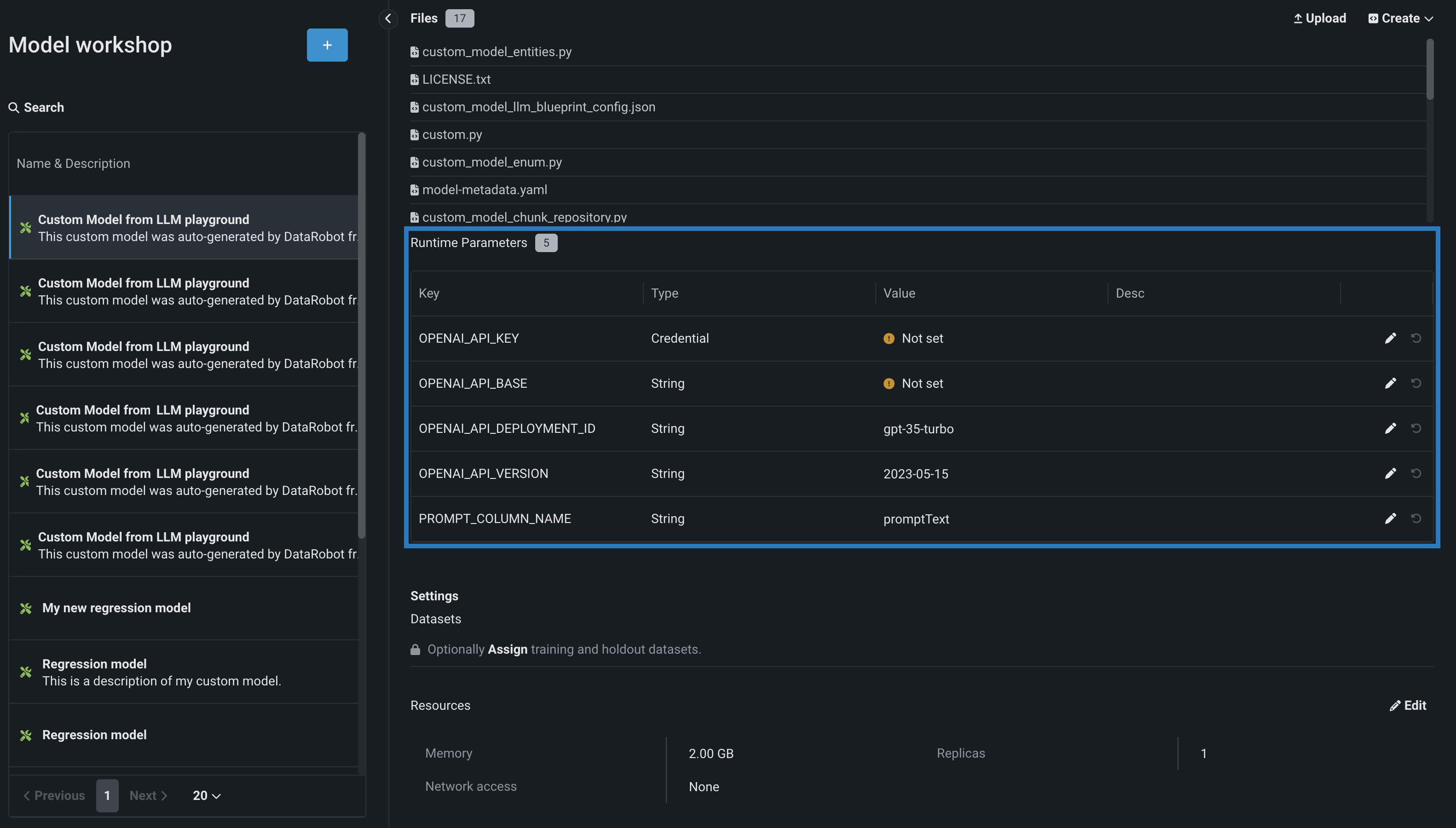

ランタイムパラメーターセクションのアセンブルタブで、LLMサービスの資格情報およびその他の詳細を含め、LLMに必要なキーと値のペアを設定します。 これらの値を追加するには、使用可能なランタイムパラメーターの隣にある編集アイコン をクリックします。

プレミアム:DataRobot LLM Gateway

所属する組織がDataRobot LLM Gatewayにアクセスできる場合、資格情報を設定する必要はありません。

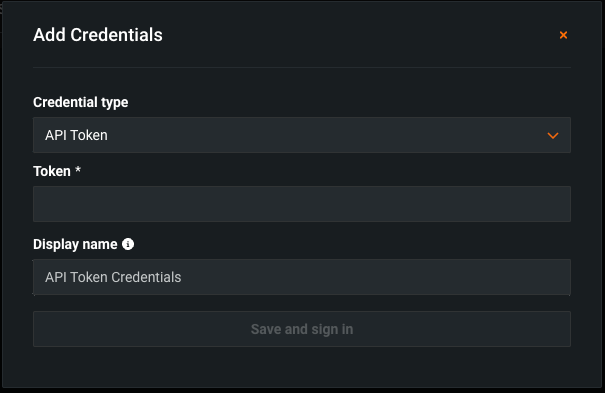

ENABLE_LLM_GATEWAY_INFERENCEランタイムパラメーターが存在し、Trueに設定されていることを確認します。 必要に応じて、PROMPT_COLUMN_NAME(デフォルトの列名はpromptText)を設定し、次の手順に進みます。 DataRobot LLM Gatewayへのリクエストも可能です。資格情報タイプランタイムパラメーターを設定するには、最初に、デプロイするLLMに必要となる資格情報をDataRobotプラットフォームの 資格情報管理ページに追加します。

MicrosoftがホストするLLMの場合は、以下を使用してください。

資格情報のタイプ: APIトークン(Azureではない)

ランタイムパラメーター:

キー 説明 OPENAI_API_KEY 資格情報管理ページで作成した、Azure OpenAI LLM APIエンドポイント用のAPIトークン資格情報を選択します。 OPENAI_API_BASE Azure OpenAI LLM APIエンドポイントのURLを入力します。 OPENAI_API_DEPLOYMENT_ID LLMをAzure環境にデプロイするときに選択した、LLMのAzure OpenAIデプロイ名を入力します。 詳細については、Azure OpenAIのドキュメントでモデルのデプロイ方法を参照してください。 DataRobotでは、デフォルトのデプロイ名として、Azure OpenAIでのLLM IDを推奨します(例:gpt-35-turbo)。 Azure OpenAIでのデプロイ名が異なる場合は、このパラメーターを変更してください。 OPENAI_API_VERSION この操作に使用するAzure OpenAI APIのバージョンを、YYYY-MM-DDまたはYYYY-MM-DD-preview形式で入力します(例:2023-05-15)。 サポートされているバージョンの詳細については、Azure OpenAI APIリファレンスドキュメントを参照してください。 PROMPT_COLUMN_NAME 入力.csvファイルからプロンプト列名を入力します。 デフォルトの列名はpromptTextです。 AmazonがホストするLLMの場合は、以下を使用してください。

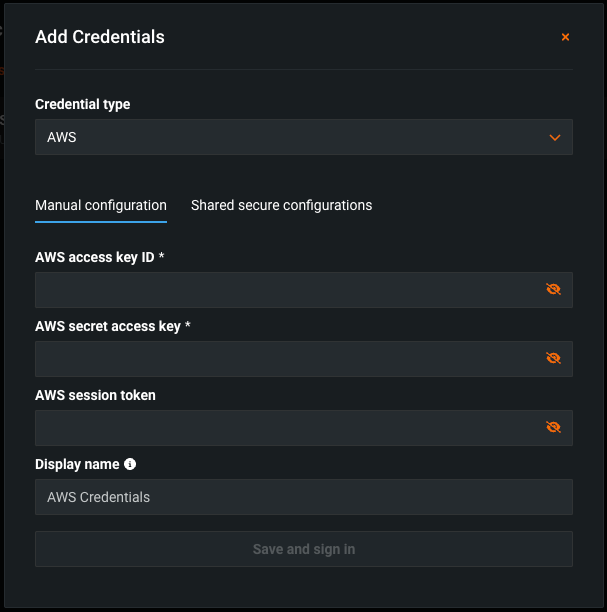

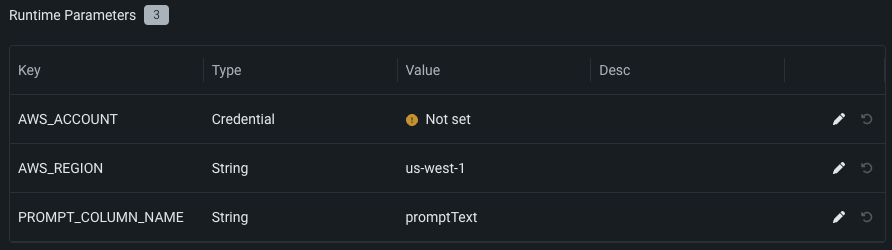

資格情報のタイプ:AWS

ランタイムパラメーター:

キー 説明 AWS_ACCOUNT AWSアカウントの 資格情報管理ページで作成されたAWS資格情報を選択します。 AWS_REGION AWSアカウントのAWSリージョンを入力します。 デフォルトはus-west-1です。 PROMPT_COLUMN_NAME 入力.csvファイルからプロンプト列名を入力します。 デフォルトの列名はpromptTextです。 GoogleがホストするLLMの場合は、以下を使用してください。

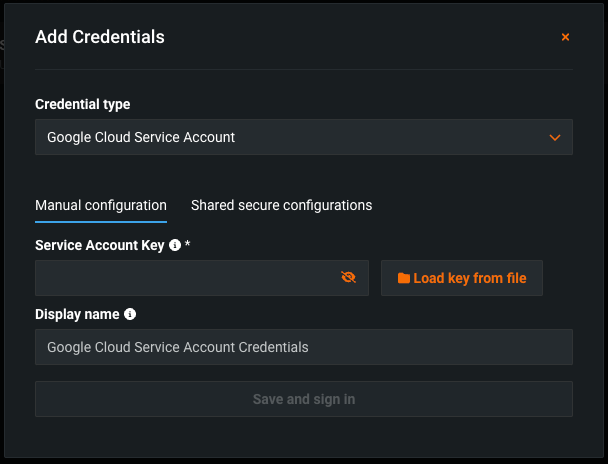

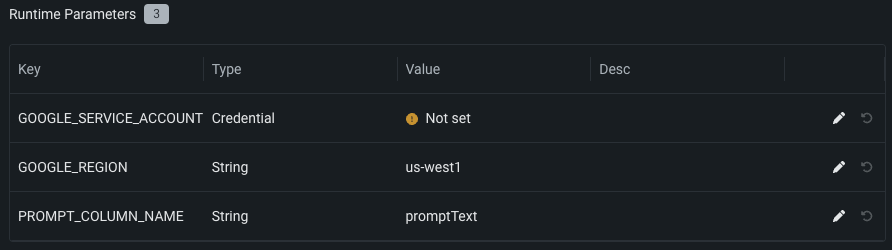

資格情報タイプ Google Cloudサービスのアカウント

ランタイムパラメーターは次のとおりです。

キー 説明 GOOGLE_SERVICE_ACCOUNT 資格情報管理ページで作成されたGoogle Cloudサービスアカウントの資格情報を選択します。 GOOGLE_REGION GoogleサービスアカウントのGCPリージョンを入力します。 デフォルトはus-west-1です。 PROMPT_COLUMN_NAME 入力.csvファイルからプロンプト列名を入力します。 デフォルトの列名はpromptTextです。 -

設定セクションで、ネットワークアクセスがパブリックに設定されていることを確認します。

-

カスタムモデルの構築が完了したら、モデルをテストしたり、新しいバージョンを作成したりすることができます。 DataRobotでは、デプロイの前にカスタムLLMをテストすることをお勧めします。

-

次に、モデルの登録をクリックして、 登録済みのモデルまたはバージョンの詳細を入力し、モデルの登録を再度クリックして、カスタムLLMをレジストリに追加します。

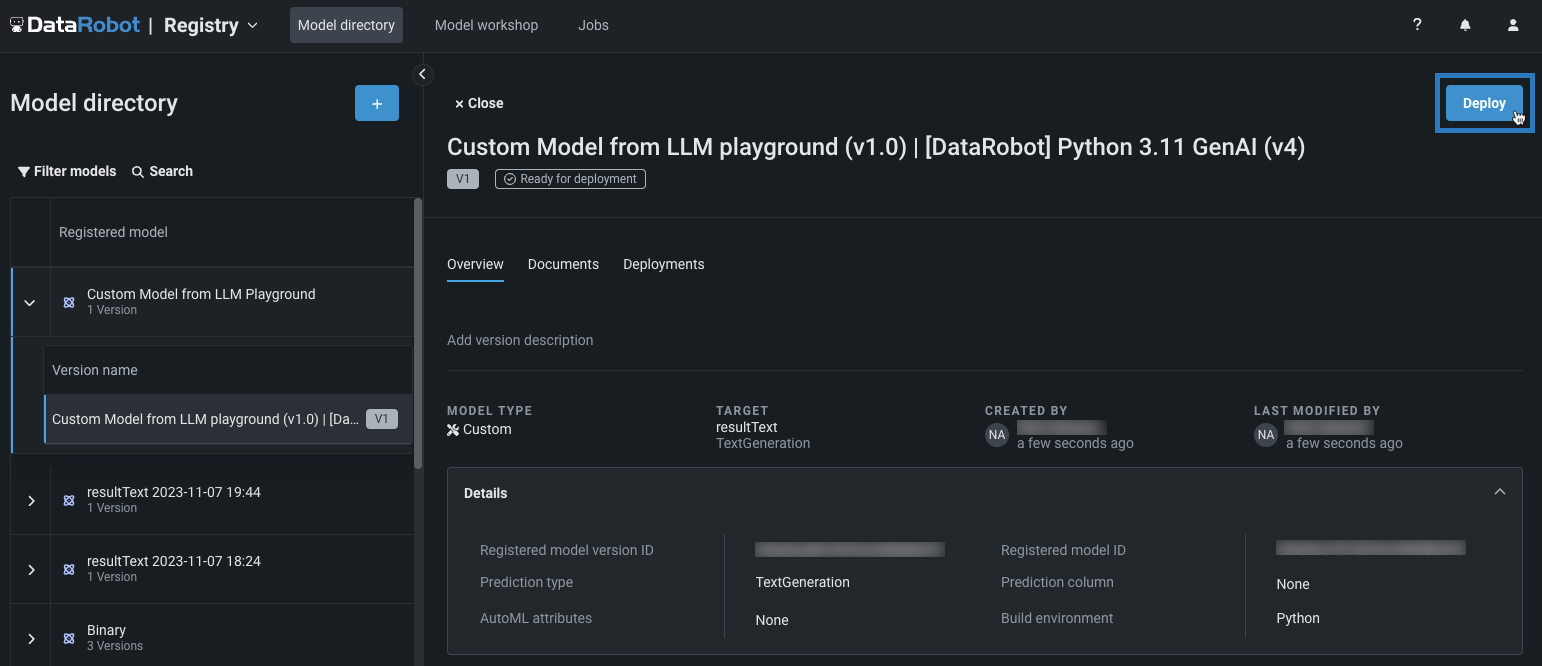

登録モデルのバージョンが、レジストリ > モデルタブで開きます。

-

モデルタブで、登録モデルバージョンパネルの右上にあるデプロイをクリックし、デプロイ設定を行います。

生成モデルで使用できるデプロイ機能の詳細については、 生成モデルの監視サポートを参照してください。

このプロセスの詳細については、プレイグラウンドデプロイの注意事項を参照してください。