ベクターデータベースの作成¶

セルフマネージドAIプラットフォームでのGPUの使用

1GBを超えるデータセットを処理する場合、GPUの使用をクラスターに設定していないセルフマネージド環境では、深刻な遅延が発生する可能性があります。 DataRobotサポートにメールで問い合わせるか、 サポートサイトにアクセスして、インストール方法をご確認ください。

プレイグラウンドで使用するベクターデータベースを作成するための基本的な手順は、プロバイダーを選択して、基本設定を行い、テキストチャンキングを設定することです。

ベクターデータベース作成プロセスの出力プロバイダー(DataRobotに常駐、または接続されたソース)を選択します。

テキストチャンキングを設定します。

ユースケースディレクトリのベクターデータベースタイルを使用して、構築されたベクターデータベースとデプロイされた埋め込みモデルを管理します。 最終的には、新しく作成されたベクターデータベース(ベクターデータベース作成プロセスの出力)をユースケース内に保存することになります。 これらは、内部ベクターデータベース(FAISS)として、または接続されたプロバイダーインスタンスに保存されます。

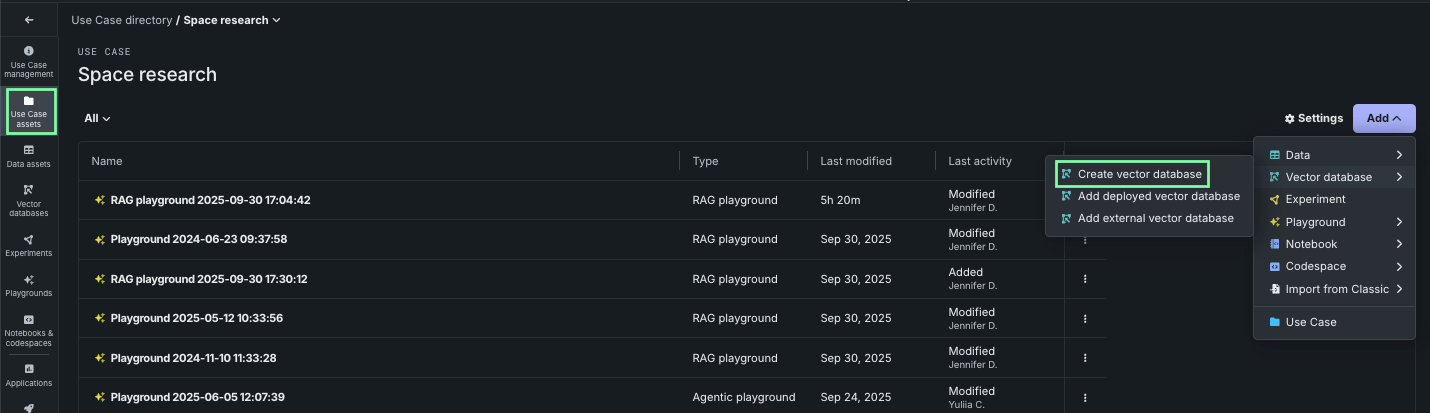

ベクターデータベースを追加¶

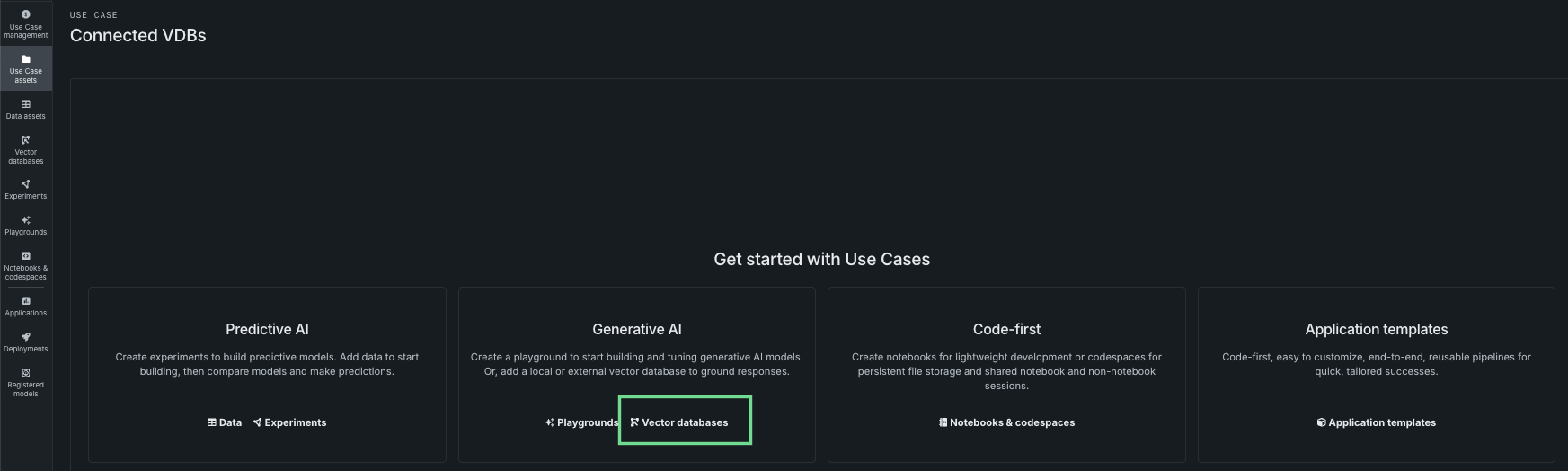

まず、アプリケーション内の複数のポイントの1つからベクターデータベースを追加します。 いずれの方法でも、ベクターデータベースを作成モーダルが開き、その時点から同じワークフローが使用されます。

ユースケース内から、追加ドロップダウンをクリックし、ベクターデータベースを展開します。

- ベクターデータベースの作成モーダルを開くには、ベクターデータベースを作成を選択します。

- 以前に登録およびデプロイしたベクターデータベースを含むデプロイを追加するには、デプロイ済みベクターデータベースを追加を選択します。

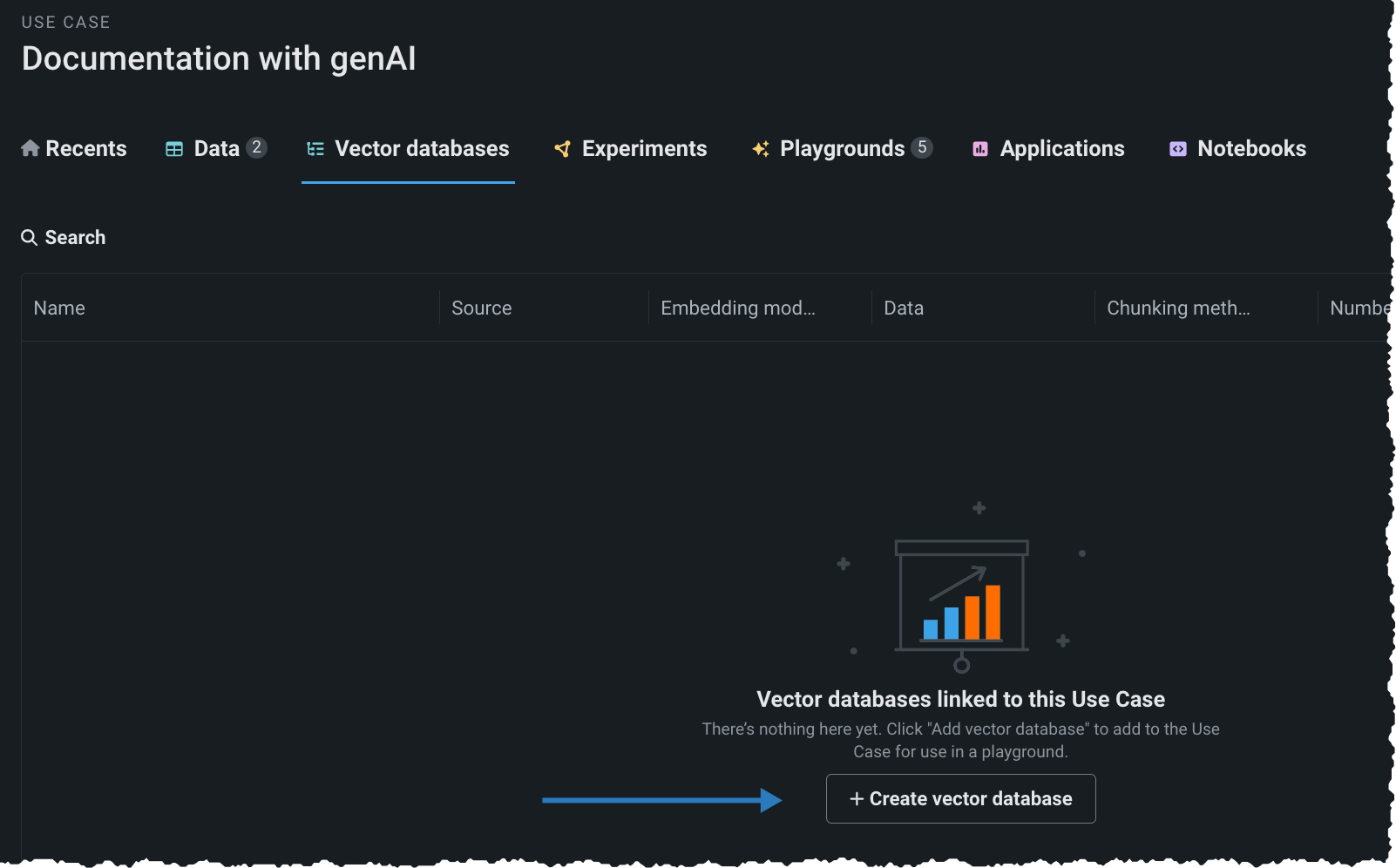

ユースケースに関連付けられたアセットがまだない場合は、タイルのランディングページからベクターデータベースを追加できます。

データアセットタイルから、ユースケースに関連付けられたアクションメニュー を開き、ベクターデータベースを作成を選択します。

アクションメニューは、データが対象として検出された場合にのみ利用可能となります。つまり、

- データセットの処理が終了した。

- データソースに必須の

document列とdocument_file_path列がある。 - メタデータ列の数が50以下である。

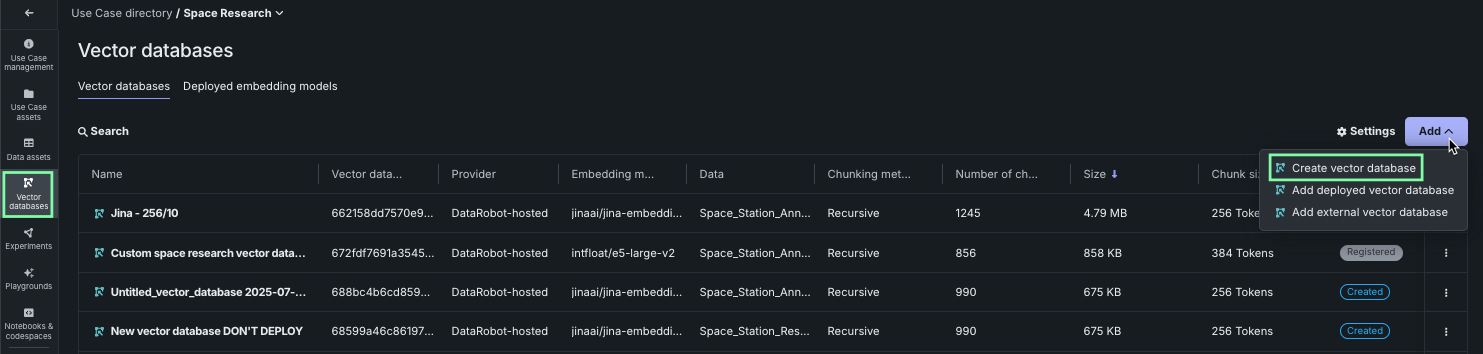

ベクターデータベースタイルから、追加ドロップダウンをクリックします。

- ベクターデータベースの作成モーダルを開くには、ベクターデータベースを作成を選択します。

- 以前に登録およびデプロイしたベクターデータベースを含むデプロイを追加するには、デプロイ済みベクターデータベースを追加を選択します。

- レジストリワークショップでカスタムベクターデータベースの構築を開始するには、外部ベクターデータベースを追加を選択します。これにより、ユースケースにリンクすることができます。

ユースケースに関連付けられたベクターデータベースがまだない場合は、タイルのランディングページから作成できます。

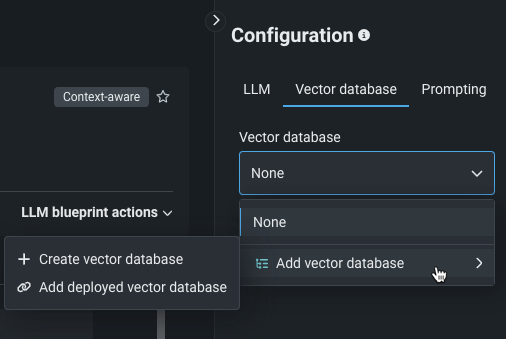

プレイグラウンドでは、LLMブループリントの設定セクションの ベクターデータベースタブを使用します。

ベクターデータベースの追加を選択したら、作成プロセスを開始します。

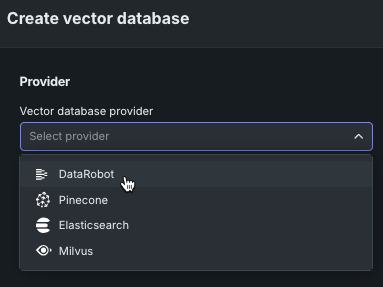

プロバイダーの選択¶

ベクターデータベースのプロバイダー(内部、または資格情報で接続された(外部)ベクターデータベースプロバイダー)を選択します。 この設定により、ベクターデータベース作成プロセスの出力先が決まります。 作成プロセスへの入力は、常にデータレジストリまたはファイルレジストリのいずれかです。

| プロバイダー/タイプ | 説明 | 最大サイズ |

|---|---|---|

| DataRobot/常駐 | データレジストリでローカルにホストされた、FAISSベースの内部ベクターデータベース。 これらのベクターデータベースはバージョン管理でき、資格情報は必要ありません。 | 10GB |

| BYO | 以前に登録およびデプロイしたベクターデータベースを含むデプロイ。 ノートブックを使用し、カスタムモデルのデプロイを介して、独自のベクターデータベースを持ち込みます。 | 制約はありませんが、ベクターデータベースのデプロイのリソースバンドルメモリー内に収まる必要があります。 |

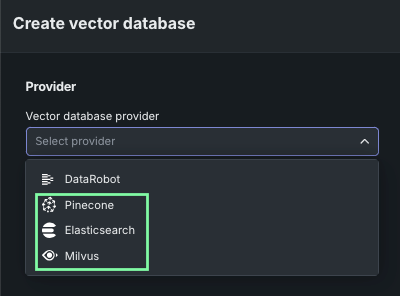

| 接続しました | 資格情報を用いて独自のPinecone、Elasticsearch、またはMilvusインスタンスを使用できる外部ベクターデータベース。 このオプションを使用すると、コンテンツの保存場所を選択できますが、DataRobotに組み込まれているRAGパイプラインを試したり、DataRobotのすぐに使える組み込みおよびチャンキング機能を利用したりすることができます。 | 100GB |

常駐ベクターデータベースの使用¶

常駐ベクターデータベースを使用するということは、データレジストリまたはカスタムモデルを介して、アプリケーション内でアクセス可能なデータを使用するということです。 DataRobotの内部ベクターデータベースは、取得速度を維持しながら、許容可能な取得精度を確保するために最適化されています。 データセットの要件と具体的な検索方法については、以下を参照してください。

-

データレジストリに保存されている内部ベクターデータベースの場合は、DataRobotを選択します。

外部ベクターデータベースの使用¶

外部(BYO)ベクターデータベースを使用するには、ベクターデータベースタイルから利用可能な追加 > デプロイ済みベクターデータベースを追加オプションを使用します。 この方法でベクターデータベースを追加する前に、DataRobot Pythonクライアントでベクターデータベースを外部で開発し、そのためのカスタムモデルを構築して、そのカスタムモデルをデプロイします。 ChromaDBを使用した例を参照してください。 なお、このベクターデータベースのタイプは、ユースケースのディレクトリリストでは読み取り専用で接続として識別されます。

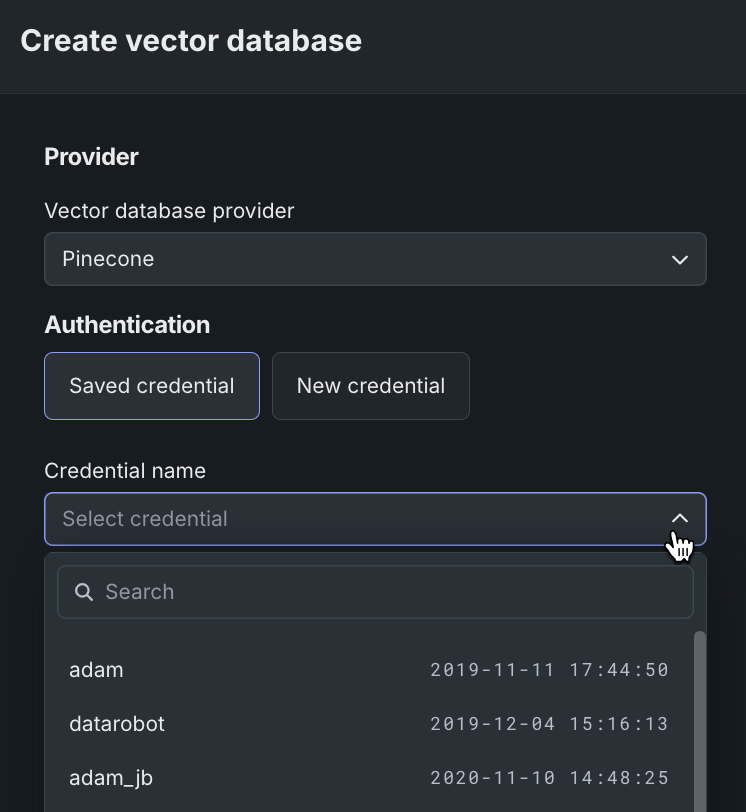

接続されたベクターデータベースの使用¶

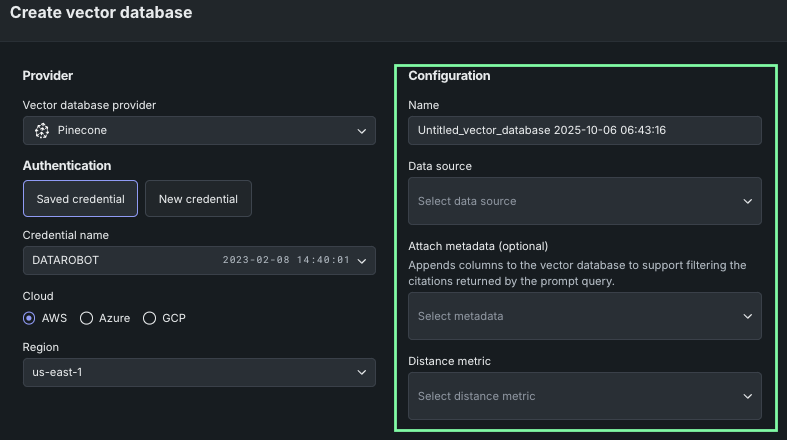

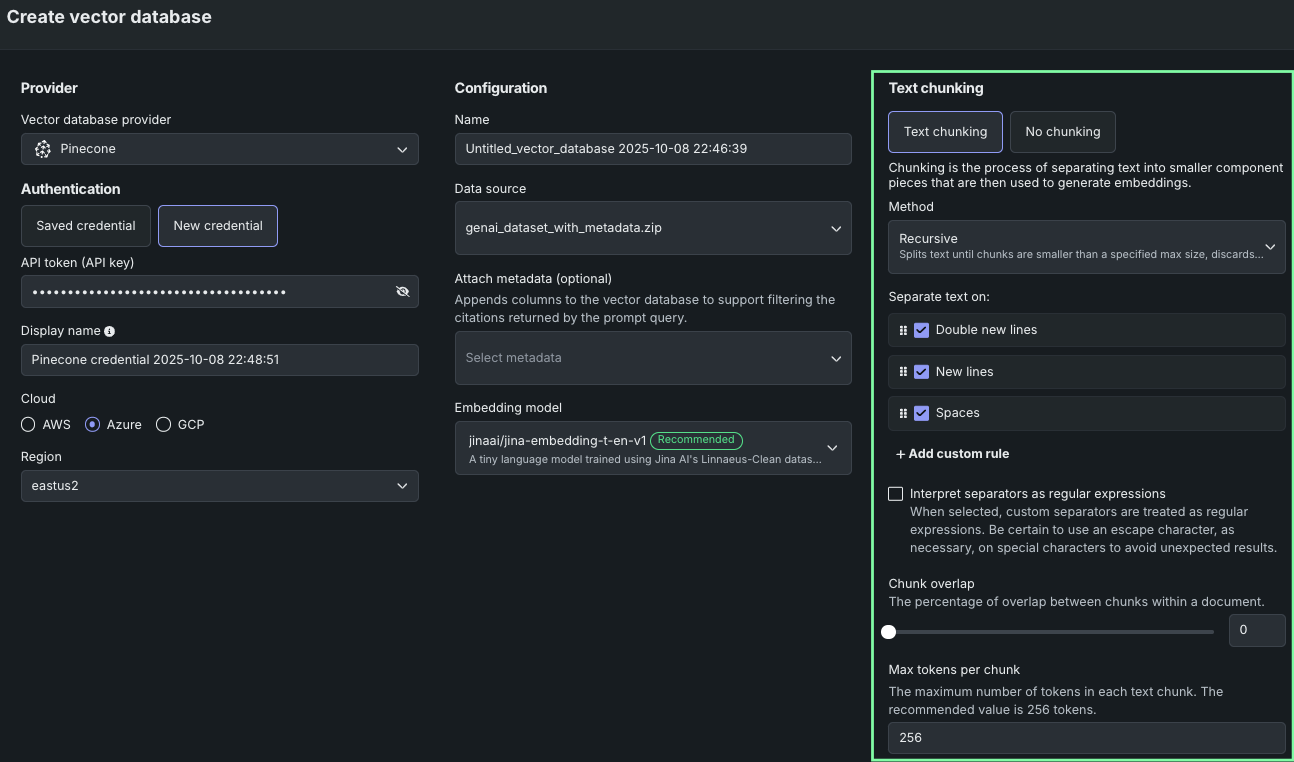

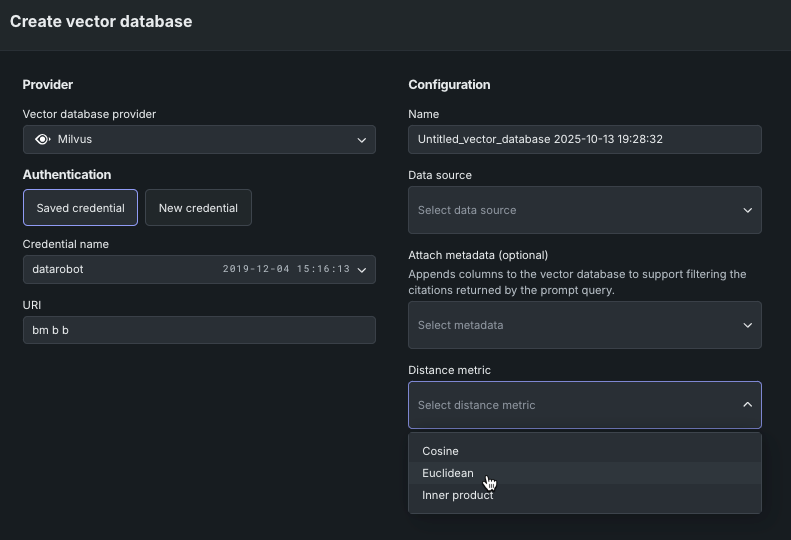

DataRobotでは、Pinecone、Elasticsearch、またはMilvusの外部データソースに直接接続して、ベクターデータベースを作成できます。 この場合、データソースがデータレジストリにローカルに保存されて、構成設定が適用され、作成されたベクターデータベースがプロバイダーに書き戻されます。 ベクターデータベースを作成モーダルでプロバイダーを選択します。

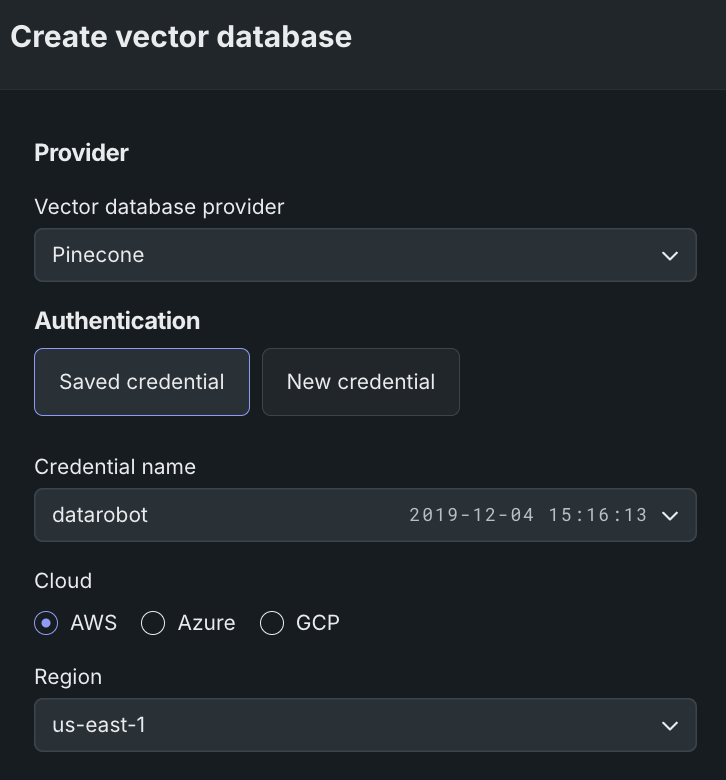

プロバイダー接続を使用するには、プロバイダーを選択し、認証情報を入力します。 保存された資格情報を使用する場合は、接続されているプロバイダーのいずれかについて、ドロップダウンから適切な名前の資格情報を選択するだけです。 使用可能な資格情報は、資格情報管理システムで作成および保存されているものです。

新しい資格情報を使用する場合は、最初にプロバイダーインスタンスで作成する必要があります。 入力されると、再利用のためにDataRobotの資格情報管理システムに保存されます。

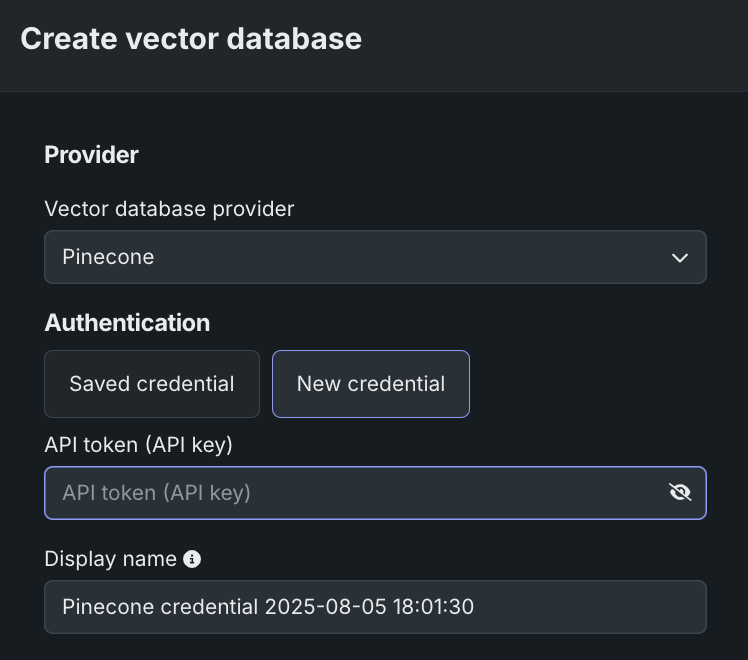

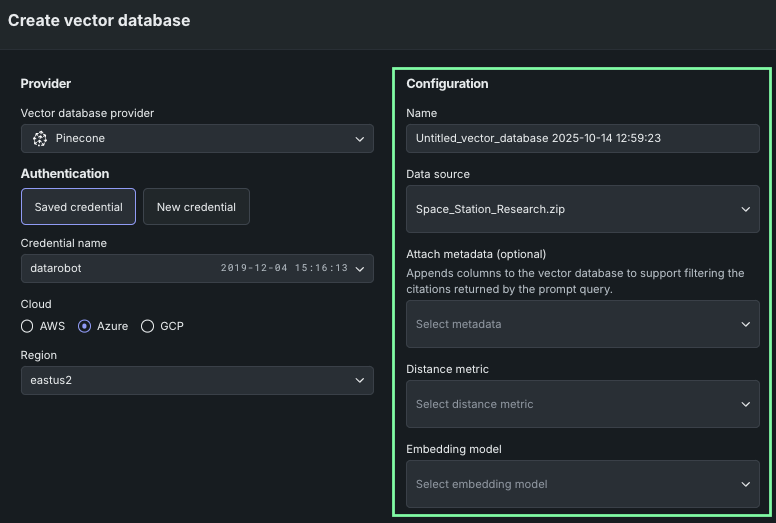

Pineconeに接続¶

Pineconeへのすべての接続リクエストには、接続認証のためのAPIキーを含める必要があります。 資格情報管理システムに保存されたPinecone APIキーがない場合は、新しい資格情報をクリックします。 APIキーのフィールドに入力し、必要に応じて表示名を変更します。 APIトークン(APIキー)フィールドに、Pineconeコンソールで作成したキーを貼り付けます。 追加されると、Pinecone APIキーが資格情報管理システムに保存され、Pineconeベクターデータベースを使用する際に再利用されます。

トークンが入力されたら、Pineconeインスタンスのクラウドプロバイダー(AWS、Azure、GCPのいずれか)と、割り当てられたクラウドリージョンを選択します。

選択後、ベクターデータベースの設定オプションが使用可能になります。

Elasticsearchに接続¶

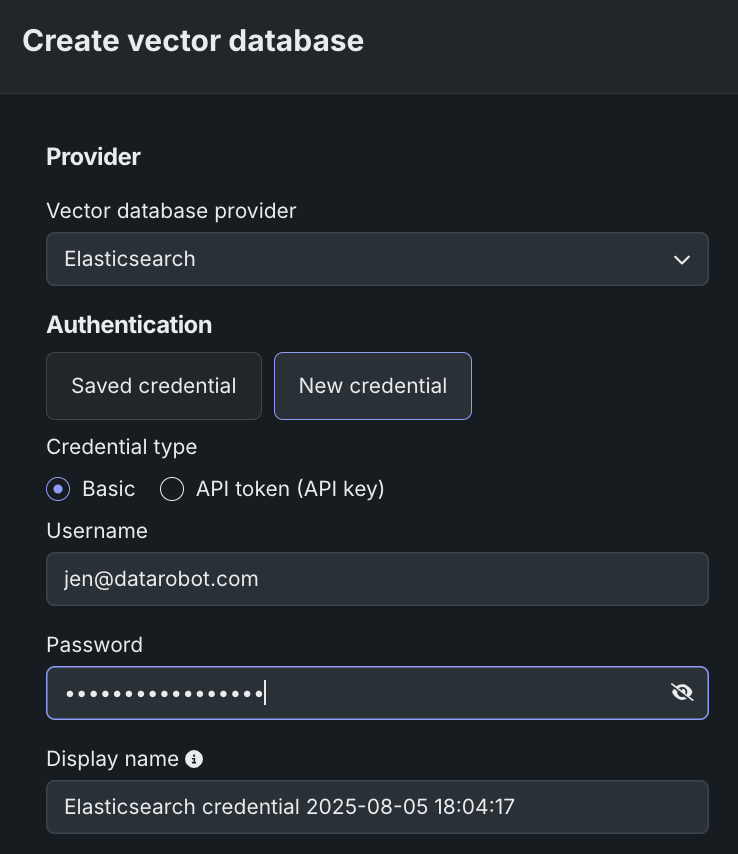

Elasticsearchクラスターへのすべての接続リクエストには、接続認証のためのユーザー名とパスワード(基本資格情報)またはAPIキーを含める必要があります。

Elasticsearch APIキーが資格情報管理システムに保存されていない場合、または追加したい場合は、新しい資格情報をクリックします。 表示されるモーダルでは、2種類の資格情報を選択できます。

-

基本:基本資格情報は、Elasticsearchインスタンスにアクセスする際に使用するユーザー名とパスワードで構成されます。 ここに入力するとDataRobotに保存されます。

-

APIキー:APIトークン(APIキー)フィールドに、Elasticsearchドキュメントの説明に従って、作成したキーを貼り付けます。

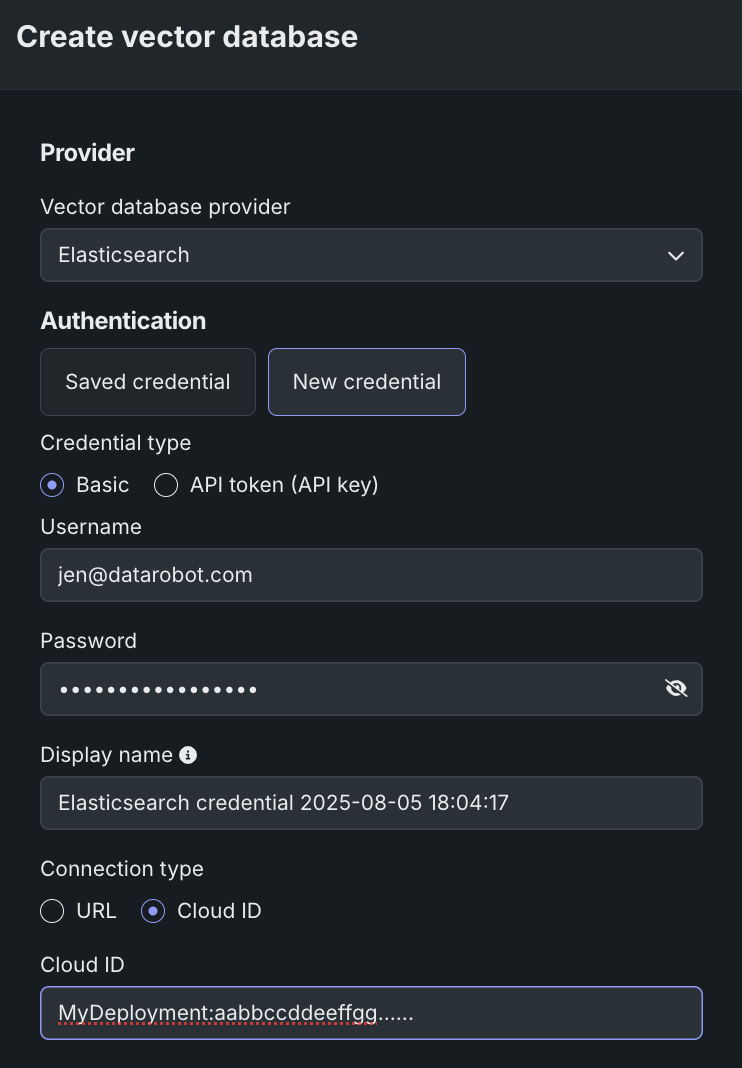

資格情報のタイプを選択したら、必要に応じて表示名を変更して、クラウドID(Elasticが推奨)またはURLのいずれかの接続方法を選択します。 クラウドIDを確認する方法については、Elasticsearchのドキュメントを参照してください。

選択後、ベクターデータベースの設定オプションが使用可能になります。

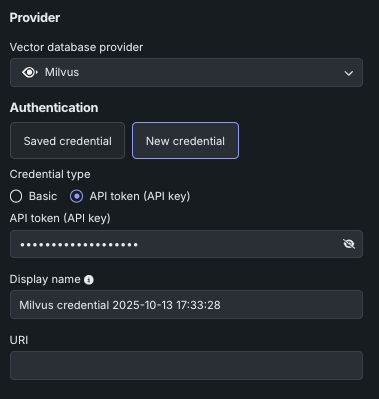

Milvusに接続¶

オープンソースのベクターデータベースの代表的なプロジェクトであるMilvusは、Apache 2.0ライセンスの下で配布されています。 Milvusへのすべての接続リクエストには、接続認証のためのユーザー名とパスワード(基本資格情報)またはAPIトークンを含める必要があります。

Milvus APIキーが資格情報管理システムに保存されていない場合、または追加したい場合は、新しい資格情報をクリックします。 表示されるモーダルでは、2種類の資格情報を選択できます。

-

基本:基本資格情報は、Milvusインスタンスにアクセスする際に使用するユーザー名とパスワードで構成されます。 ここに入力するとDataRobotに保存されます。

-

APIトークン:APIトークン(APIキー)フィールドに、Milvusドキュメントの説明に従って、作成したキーを貼り付けます。

資格情報のタイプが選択されたら、必要に応じて表示名を変更し、MilvusサーバーアドレスのURIを入力します。

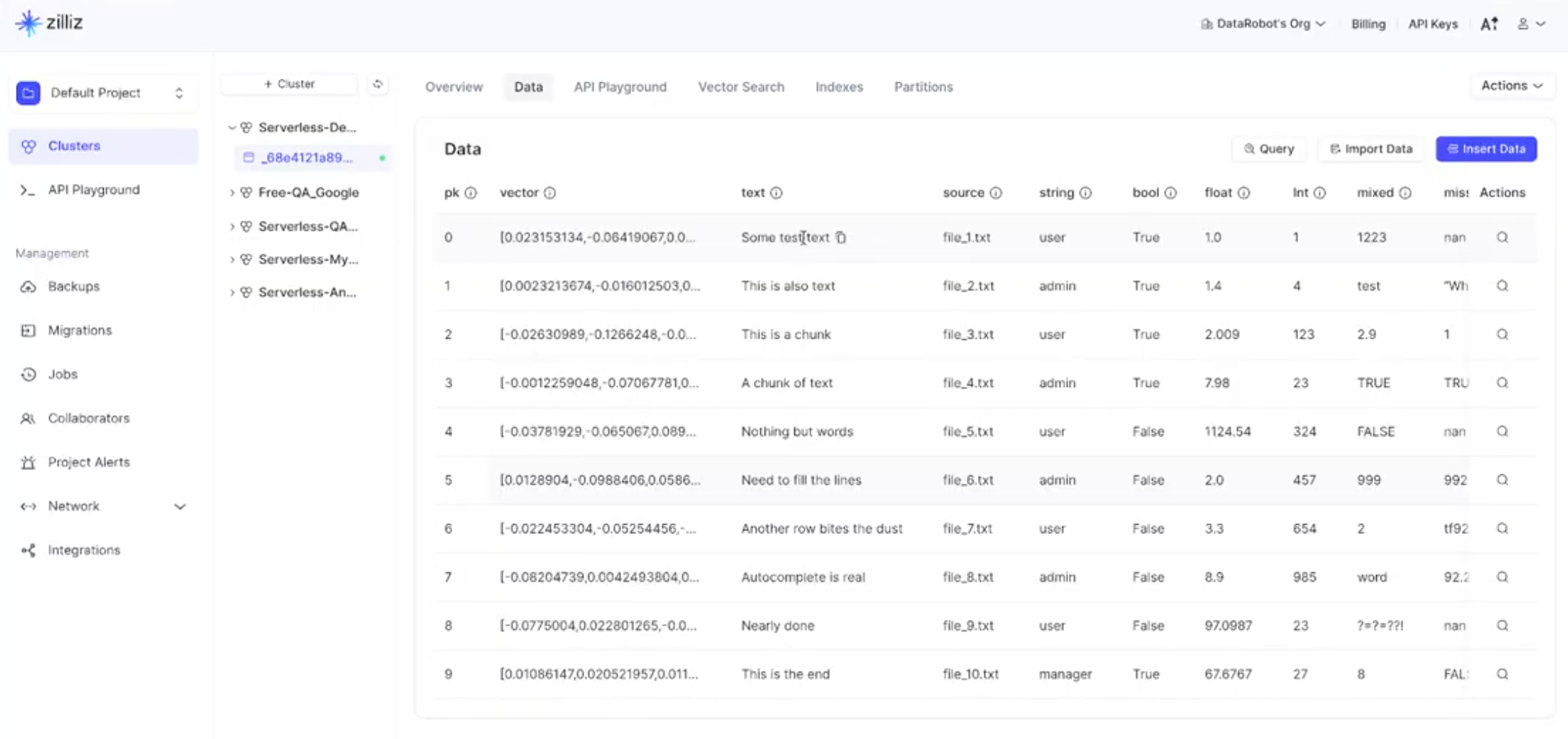

備考

設定を完了し、ベクターデータベースを作成すると、クラスターのMilvusサイトのCollectionsタブで使用できるようになります。 コレクションを開き、Dataタブを選択すると、ベクター、テキスト、およびさまざまなメタデータが表示されます。

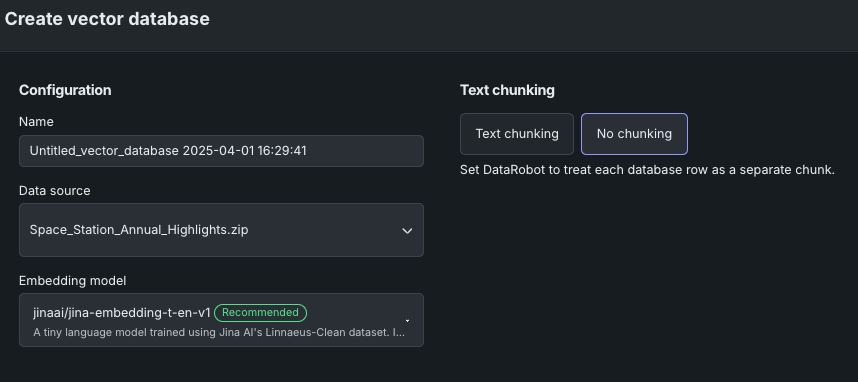

基本設定を行う¶

次の表では、ベクターデータベースの作成に使用される構成設定について説明します。

| フィールド | 説明 |

|---|---|

| 名前 | ベクターデータベースが保存される名前。 この名前は、ユースケースのベクターデータベースタイルに表示され、プレイグラウンドを設定する際に選択可能です。 |

| データソース | ベクターデータベースのナレッジソースとして使用されるデータセット。 リストは、ユースケースのベクターデータベースタイルにエントリーがあれば、それに基づいて設定されます。 データアセットタイルのアクションメニューからベクターデータベースの作成を開始した場合、フィールドにはそのデータセットがあらかじめ設定されます。 関連付けられているベクターデータベースがない場合、または適用可能なものが存在しない場合は、データを追加オプションを使用します。 |

| メタデータの添付 | ファイルレジストリ内のファイルの名前。このファイルは、ベクターデータベースに列を追加して、プロンプトクエリーによって返される引用のフィルターをサポートするために使用されます。 |

| 距離指標(接続プロバイダーのみ) | 最近傍検索で使用するベクトル類似性指標で、クエリーに対するベクトルの類似性をランク付けします。 |

| 埋め込みモデル | データのエンコーディングに使用される埋め込みのタイプを定義するモデル |

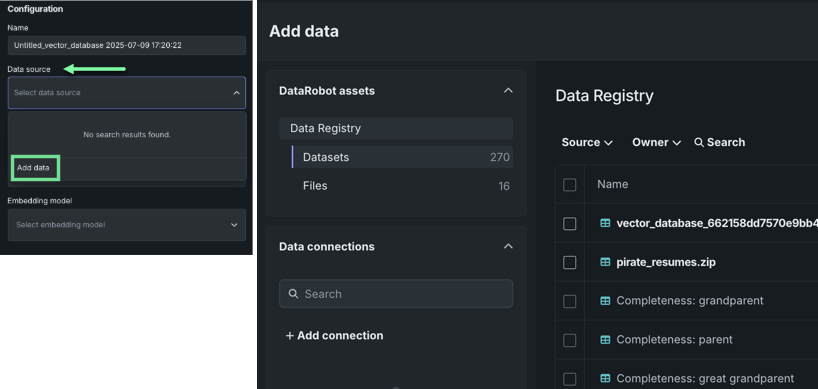

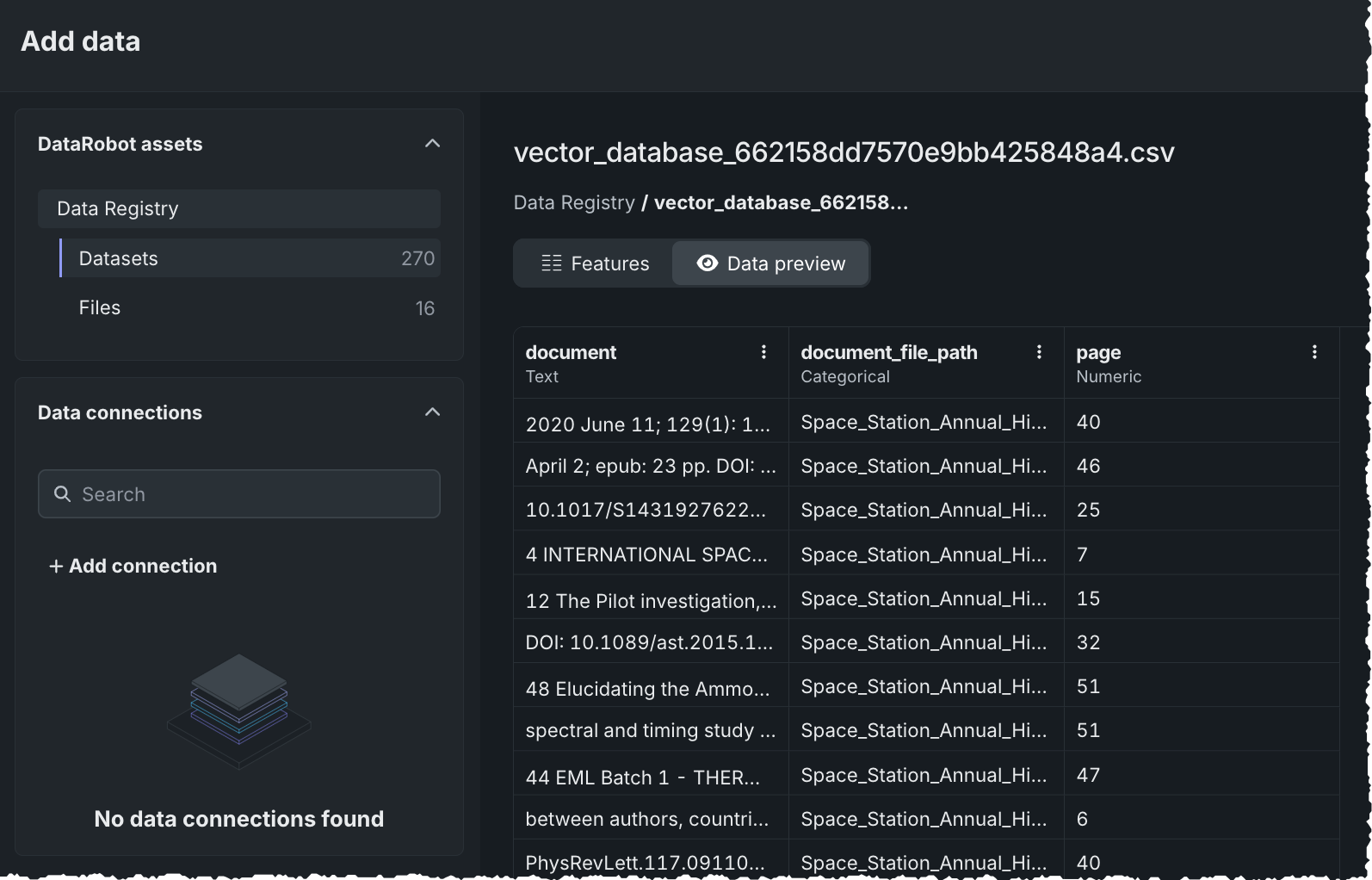

データソースの追加¶

利用可能なデータソースがない場合、または新しいソースを追加したい場合は、データソースドロップダウンでデータを追加を選択します。 データを追加モーダルが開きます。 ベクターデータベースの作成では、ZIPおよびCSVデータセット形式と、データセット内の特定のサポート対象ファイルタイプをサポートしています。 サポートされているデータセットには、ファイルレジストリまたはデータレジストリのどちらからでもアクセスできます。

Vector databases allow ingest from remote sources that support unstructured data, which are outlined on the Data Sources page. When you use supported remote sources (such as Google Drive or SharePoint), access control information can be propagated and enforced so that VDB results respect the original document permissions—see ACL hydration for details.

| レジストリのタイプ | 説明 |

|---|---|

| ファイル | あらゆるタイプのデータを保存できる「汎用」ストレージシステム。 データレジストリとは異なり、ファイルレジストリにアップロードされたファイルはCSV変換されません。 UIでは、ベクターデータベースの作成はファイルレジストリを使用できる唯一の場であり、データを追加モーダルからのみアクセスできます。 どのようなファイルタイプでも保存できますが、ベクターデータベースの作成では、レジストリのタイプに関係なく、同じファイルタイプがサポートされています。 |

| データ | データレジストリでは、ZIPファイルはCSVに変換され、各メンバーファイルの内容はCSVの行として保存されます。 各ファイルのファイルパスはdocument_file_path列になり、ファイルの内容(テキストまたはファイルのbase64エンコード)はdocument列になります。 |

サポートされているデータストア

サポートされているコネクターとドライバーの完全なリストについては、サポートされているデータストアを参照してください。 一部のコネクターは非構造化データのみをサポートしています。追加すると、データレジストリ内の「ファイル」セクションに表示されます。

ベクターデータベースにおけるデータコネクターの制限事項

データコネクター(GoogleドライブやSharePointなど)経由で取り込まれたデータは、ファイルレジストリに保存され、ベクターデータベース(VDB)のメタデータとして使用することはできません。 ファイルストレージに含まれるアセットはEDAプロセスによって検証されないため、すべてのメタデータファイルをデータレジストリのデータセットストレージにアップロードする必要があります。 ベクターデータベースにおいて、フィルター、アクセス制御、またはダウンストリーム取得ロジック用のメタデータが必要な場合は、メタデータがデータコネクターをソースとするのではなく、データレジストリのデータセットとして提供されていることを確認してください。

データセットを選択します。 データレジストリのデータセットには、チャンク(document)とそのソースとなったファイル(document_file_path)のプレビューが表示されます。

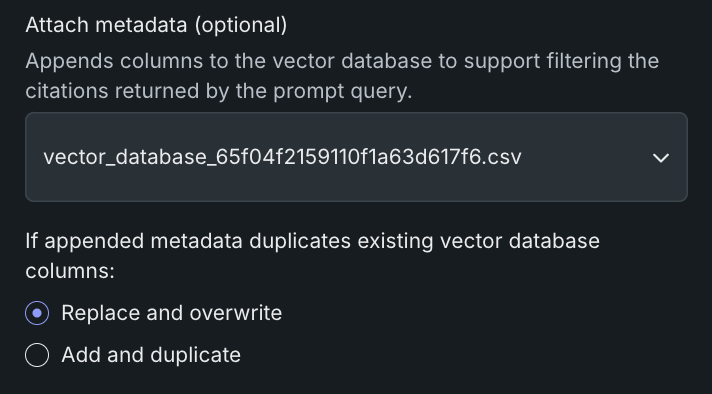

メタデータの添付¶

必要に応じて、追加のファイルを選択して、ベクターデータベース内のチャンクに添付するメタデータを定義できます。 そのファイルは、データレジストリのデータセットストレージに存在する必要があります。 (ファイルストレージには配置できません。これは、必要な列が存在することを検証するEDAプロセスが、データセットアセットでのみ実行されるためです。)

ファイルには、少なくともdocument_file_path列が含まれている必要があります。 document列はオプションです。 最大50個の列を追加できます。これらの列は、プロンプトクエリー時のフィルターに使用できます。

ドキュメントとメタデータの情報を1つのファイルにまとめたCSVをアップロードできます。 あるいは、データとメタデータを別々のファイルとしてアップロードしても、最終的な結果は同じになります。

備考

メタデータのフィルターを導入する以前に作成されたベクターデータベースは、この機能をサポートしていません。 それらにフィルターを使用するには、オリジナルからバージョンを作成し、代わりに新しいベクターデータベースを使用するようにLLMブループリントを設定します。

使用可能なファイルを選択するか、データを追加モーダルを使用してメタデータファイルをデータレジストリに追加します。 この例では、ファイルには、ファイルまたはチャンクを定義するdocument_file_pathという1つの列と、メタデータを定義するその他のさまざまな列があります。

メタデータファイルを選択すると、データセットにもメタデータがある場合、DataRobotで両方のメタデータセットを保持するか、新しいファイルで上書きするかを選択するよう求められます。 メタデータを置換するかマージするかは、データセットとメタデータデータセットの間に重複する列がある場合にのみ適用されます。 両方の重複しないメタデータ列は常に保持されます。

メタデータの重複例

データセットにはcol1とcol2があります。メタデータファイルにはcol2とcol3があります。 ベクターデータベースに入るメタデータはcol1、col2、col3となります。 col2は重複しているため、設定に応じて次のいずれかが実行されます。

- 置換:メタデータファイルの値が使用されます。

- 両方とも残す:メタデータファイルを優先して2つの列がマージされます。

距離指標の設定¶

接続されたプロバイダーを使用する場合は、類似性指標とも呼ばれる距離ベクトルを設定することもできます(DataRobotがプロバイダーとして選択されている場合、この設定は使用できません)。 これらの指標は、ベクトルがどの程度類似しているかを測定します。適切な指標を選択すると、分類およびクラスタリングタスクの効率が大幅に向上します。 埋め込みモデルのトレーニングに使用されたものと同じ類似性指標を選択することを検討してください。

| プロバイダー | プロバイダーのドキュメント |

|---|---|

| Pinecone | 類似性指標 |

| Elasticsearch | 類似性パラメーター |

| Milvus | 指標のタイプ:浮動 |

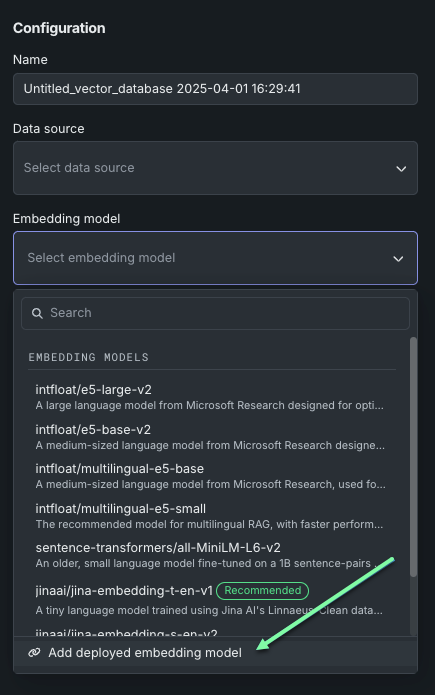

埋め込みモデルの設定¶

データをエンコードするには、ユースケースに最適な埋め込みモデルを選択します。 DataRobotが提供する埋め込みのいずれか、またはBYO埋め込みを使用します。 DataRobotは、次のタイプの埋め込みをサポートしています。埋め込みの完全な説明は、こちらを参照してください。

| 埋め込みタイプ | 説明 |

|---|---|

| cl-nagoya/sup-simcse-ja-base | 日本語RAGの中規模言語モデル |

| huggingface.co/intfloat/multilingual-e5-base | 複数の言語で多言語RAG処理に使用される中規模言語モデル。 |

| huggingface.co/intfloat/multilingual-e5-small | 多言語RAG処理に使用する小規模言語モデルで、 _multilingual-e5-base_よりも高速です。 |

| intfloat/e5-base-v2 | 中〜高程度のRAGパフォーマンスを実現するのに使用される中規模言語モデル。 パラメーターが少なくアーキテクチャが小さいため、e5_large_v2よりも高速です。 |

| intfloat/e5-large-v2 | 最適なRAGパフォーマンスを実現するように設計された大規模言語モデル。 そのアーキテクチャとサイズにより、低速として分類されます。 |

| jinaai/jina-embedding-t-en-v1 | 英語のコーパスで事前学習された小さな言語モデルで、DataRobotが提供する最速でデフォルトの埋め込みモデルです。 |

| jinaai/jina-embedding-s-en-v2 | Jina Embeddings v2ファミリーの1つであるこの埋め込みモデルは、長いドキュメントの埋め込みに最適です(最大8192の大きなチャンクサイズ)。 |

| sentence-transformers/all-MiniLM-L6-v2 | 比較的高速で英語のコーパスで事前学習された1Bの文対データセットで微調整された小規模言語モデル ただし、古いデータで学習されているため、RAGには推奨されません。 |

| デプロイ済み埋め込みモデルを追加 | ベクターデータベースの作成時に使用するデプロイ済みの埋め込みモデルを選択します。 列名は、デプロイのコンソール概要ページにあります。 |

DataRobotが提供する埋め込みモデルは、 SentenceBERTフレームワークに基づいており、文や段落の密なベクトル表現を計算する簡単な方法を提供します。 このモデルは、教師ありデータと教師なしデータの混合で訓練されたトランスフォーマーネットワーク(BERT、RoBERTA、T5)に基づいており、さまざまなタスクで最先端のパフォーマンスを達成しています。 テキストはベクトル空間に埋め込まれ、類似したテキストはより密接にグループ化され、コサイン類似度を使用して効率的に見つけることができます。

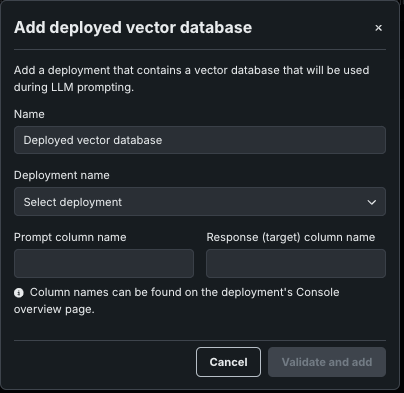

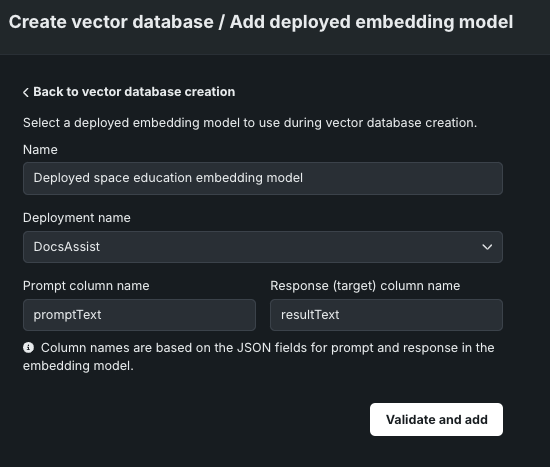

デプロイ済み埋め込みモデルを追加¶

ベクターデータベースを追加する際、 _非構造化カスタムモデル_としてデプロイされた埋め込みモデルを選択できます。 ベクターデータベースを作成パネルで、埋め込みモデルドロップダウンをクリックしてから、デプロイ済み埋め込みモデルを追加をクリックします。

デプロイ済み埋め込みモデルを追加パネルで、次の設定を行います。

| 設定 | 説明 |

|---|---|

| 名前 | 埋め込みモデルにわかりやすい名前を入力します。 |

| デプロイ名 | 非構造化カスタムのモデル デプロイを選択します。 |

| プロンプト列の名前 | ワークショップでカスタム埋め込みモデルを作成したときに定義した、ユーザープロンプトを含む列の名前を入力します(例:promptText)。 |

| 回答(ターゲット)列の名前 | ワークショップでカスタム埋め込みモデルを作成したときに定義した、LLMの回答を含む列の名前を入力します(例:responseTextまたはresultText)。 |

デプロイされた埋め込みモデルの設定を行った後、検証おおび追加をクリックします。 デプロイされた埋め込みモデルが、埋め込みモデルドロップダウンリストに追加されます。

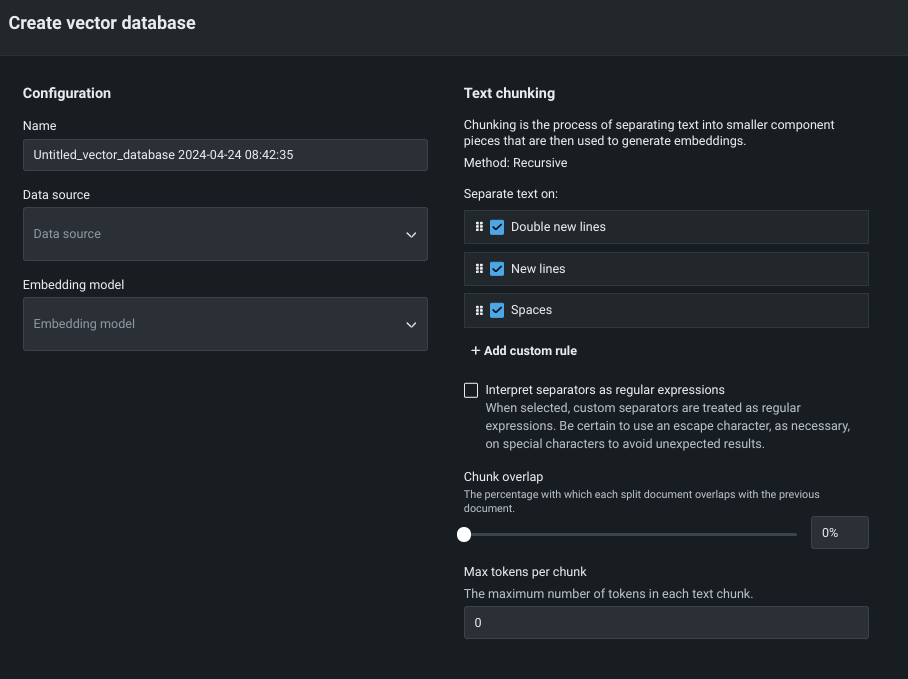

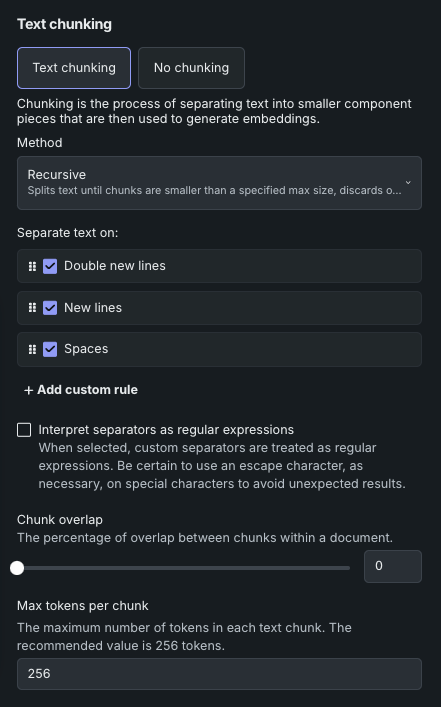

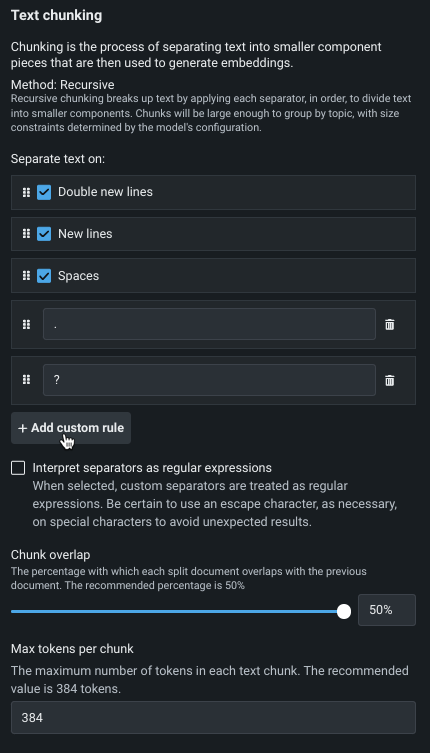

チャンク設定¶

テキストチャンキングは、テキストドキュメントをより小さなテキストチャンクに分割するプロセスで、埋め込みの生成に使用されます。 次のいずれかの原因が考えられます。

- テキストチャンキングを選択し、チャンクの派生方法(メソッド、 セパレーター、 その他のパラメーター)を設定します。

- チャンキングなしを選択します。 DataRobotは各行をチャンキングとして扱い、各行に埋め込みを直接生成します。

チャンキング方法¶

チャンキングメソッドでは、データソースからのテキストを、より小さく、管理しやすい断片に分割する方法を設定します。 これは、最近傍検索の効率を向上させるために使用され、クエリーが実行されると、データベースは最初に最近傍を含む可能性のある関連チャンキングを特定し、次にデータセット全体を検索するのではなく、それらのチャンク内を検索します。

| 方法 | 説明 |

|---|---|

| 再帰的 | テキストを分割し、チャンクのサイズが指定された最大サイズよりも小さくなるまで繰り返し、サイズが大きすぎるチャンクは破棄します。必要に応じて、チャンクのサイズ制限を維持するために、テキストを個々の文字で分割します。 |

| セマンティック | 長いテキストを、長さではなく内容に基づいて、意味のある小さな単位に分割します(チャンクサイズ)。 これは完全に自動化された方法で、これが選択されると、それ以上のチャンキング設定はできません。文が意味的に「閉じた」チャンクとなります。 詳しくは、以下の詳細を参照してください。 |

詳細:チャンキング方法

再帰的 生成されたチャンクの長さ/サイズが既に最大チャンクサイズよりも小さい場合、以降の区切り文字は無視されます。 そうでない場合、DataRobotは、チャンクの長さ/サイズが最大チャンキングサイズより小さくなるまで、 区切り文字のリストを順次適用します。 最終的に、生成されたチャンクが指定された長さよりも大きい場合、破棄されます。 その場合、DataRobotは「各文字を切り離す」戦略を使って各文字で分割し、チャンクサイズの上限まで、連続的に分割された文字チャンクをマージします。 「文字で分割」が区切り文字としてリストされていない場合、長いチャンクは切り取られます。 つまり、テキストの一部は埋め込みの生成で欠損しますが、チャンク全体は引き続きドキュメントの取得に使用できます。

セマンティック セマンティックチャンキングでは、テキストの長さだけで分割するのではなく、各チャンク内で一貫性のあるアイデアやトピックをそのまま維持しようとします。 この方法は、自然言語処理(NLP)などのタスクに有用で、テキストの意味や文脈を理解することは、情報検索、要約、機械学習モデルの埋め込みを生成するようなタスクに重要です。 たとえば、セマンティックチャンキングプロセスでは、特定のサイズ制限を超えても、同じトピックについて論じている段落はまとめられ、チャンクが完全な思考や概念を表すようにします。

とはいえ、DataRobotには標準の埋め込みモデルのためにセマンティックチャンキングが実装されているため、選択した埋め込みモデルでサポートされる最大チャンクサイズが自動的に検出され、安全性のカットオフとして使われます。 これにより、埋め込みモデルの最大入力長を超えるチャンクは強制的に切り捨てられるため、実際にはすべてのテキストが埋め込まれます。 デフォルトバージョンのアルゴリズムを使用するBYO埋め込みは、安全性のカットオフをサポートしていません。 チャンクは任意の長さにすることができ、埋め込みモデルの最大入力長を超えることもできます。これにより、テキストが切り捨てられる(したがって埋め込まれない)可能性があります。 埋め込まれていないテキストは、ベクターデータベースから返される引用に引き続き含まれます。

区切り文字の操作¶

区切り文字は、テキストを分割するための「ルール」または検索パターン(サポート可能ですが正規表現ではありません)です。各区切り文字は、テキストをより小さなコンポーネントに分割するために、順番に適用されます。区切り文字は、ドキュメントをチャンクに分割するためのトークンを定義します。 チャンクはトピックごとにグループ化するのに十分な大きさで、サイズ制約はモデルの設定によって決定されます。 再帰的テキストチャンキングは、チャンクルールに適用される方法です。

各ベクターデータベースは、テキストを分割する内容を定義する4つのデフォルトルールから始まります。

- 二重改行

- 改行

- スペース

これらのルールは、理解しやすいように単語で識別されますが、バックエンドでは個々の文字列として解釈されます(つまり、\n\n, \n, " ", "")。

ドキュメントに区切り文字が存在しない場合や、目的のチャンクサイズに分割するための十分なコンテンツがない場合があります。 その場合、DataRobotは「next-best character」(次にベストな文字)フォールバックルールを適用し、チャンクが定義されたチャンクサイズに適合するまで、次のチャンクに文字を移動します。 そうでない場合、埋め込みモデルは、継承されたコンテキストサイズを超えるチャンクを切り捨てます。

カスタムルールを追加¶

最大5つのカスタム区切り文字を追加して、チャンク戦略の一部として適用できます。 これにより、合計9つの区切り文字が使用できます(4つのデフォルトを一緒に考慮した場合)。 カスタム区切り文字には、以下が適用されます。

- 各区切り文字の最大文字数は20文字です。

-

区切り文字として単語を使用できる「変換ロジック」はありません。 たとえば、句読点を分割する場合は、各タイプに区切り文字を追加する必要があります。

-

区切り文字の順序は重要です。 区切り文字を並べ替えるには、セルをクリックして目的の場所にドラッグします。

-

チャンク戦略のファインチューニングや区切り文字追加のための空き容量調整などで区切り文字を削除するには、ごみ箱アイコンをクリックします。 デフォルトの区切り文字は削除できません。

正規表現の使用¶

区切り文字に正規表現を使用できるようにするには、セパレーターを正規表現として解釈を選択します。 この機能をアクティブにすると、すべての区切り文字が正規表現として扱われることを理解するのが重要です。 例えば、「.」を追加すると、各文字に一致して分割されることを意味します。 リテラルの「dots」で分割する場合は、記号(「\.」など)を付けてエスケープする必要があります。 このルールは、カスタム区切り文字と(この方法で動作するよう設定されている)事前定義済みの両方の区切り文字に適用されます。

チャンクパラメーター¶

チャンクパラメーターは、ベクターデータベースの出力をさらに定義します。 チャンクパラメーターのデフォルト値は、埋め込みモデルによって異なります。

チャンクのオーバーラップ¶

オーバーラップとは、隣接するチャンクがある程度のデータを共有できるようにする方法を指します。 チャンクオーバーラップパラメーターは、連続するチャンク間のトークンの重複割合(パーセント)を指定します。 重複は、言語モデルでテキストを処理するときにチャンク間のコンテキストの連続性を維持するのに役立ちますが、より多くのチャンクを生成しベクターデータベースのサイズを増やすという代償があります。

検索制限¶

Top K(近傍法)に設定した値は、ベクターデータベースから取得する関連チャンクの数をLLMに指示します。 チャンクの選択は、 類似性スコアに基づいて行われます。 以下の点に注意してください。

- 値を大きくすると、より広範囲をカバーできますが、処理のオーバーヘッドが増加し、関連性の低い結果が含まれる可能性があります。

- 値を小さくすると、より焦点の絞られた結果が得られ、処理も速くなりますが、関連する情報を見逃す可能性があります。

最大トークン数では、以下の内容を指定します。

- ベクターデータベースを構築するときにデータセットから抽出された各テキストチャンクの最大サイズ(トークン単位)。

- 埋め込みの作成に使用されるテキストの長さ。

- RAG操作で使用される引用のサイズ。

ベクターデータベースの保存¶

設定が完了したら、ベクターデータベースを作成をクリックして、データベースを プレイグラウンドで使用可能にします。

ベクターデータベースの管理¶

ベクターデータベースタイルには、ユースケースに関連付けられているすべてのベクターデータベースとデプロイ済み埋め込みモデルが一覧表示されます。 ベクターデータベースのエントリーには、親から派生したバージョンに関する情報が含まれています。ベクターデータベースのバージョニングの詳細については、 バージョニングのセクションを参照してください。

ユースケース内のベクターデータベースタブから、ユースケースのすべてのベクターデータベース(および関連バージョン)を表示できます。 外部ベクターデータベースの場合、ソースタイプのみが表示されます。 これらのベクターデータベースはDataRobotによって管理されていないため、他のデータはレポートには利用できません。

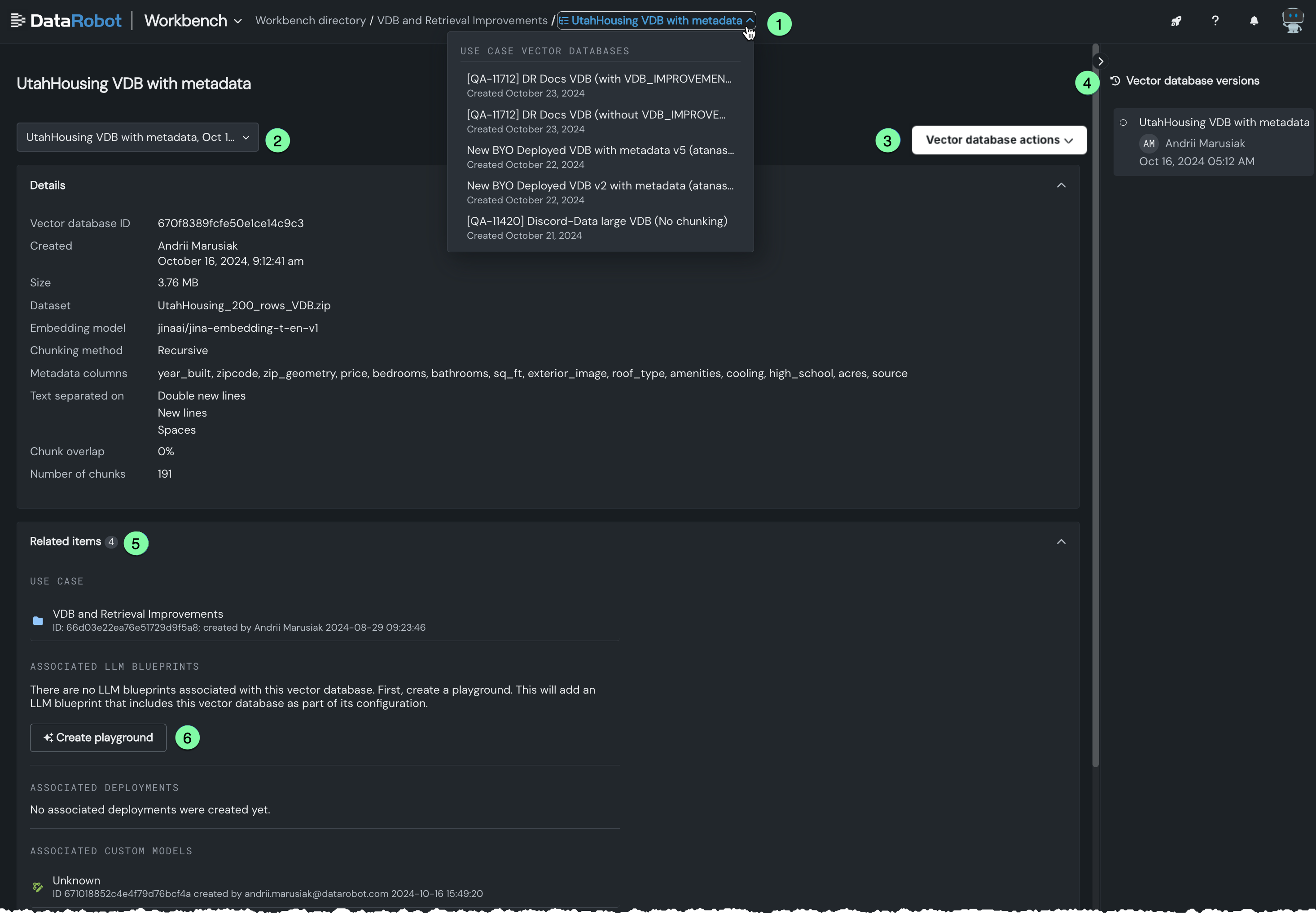

ベクターデータベースタイルのリストでいずれかのエントリーをクリックすると、新しいモーダルが開き、そのデータベースの設定と関連アイテムが展開表示されます。

以下を実行することが可能です。

| 説明 | |

|---|---|

| 1 | パンくずのドロップダウンから別のベクターデータベースを選択して検索します。 |

| 2 | ドロップダウンから別のバージョンのベクターデータベースを選択して検索します。 バージョンをクリックすると、 詳細および報告されたアセット(関連アイテム)が特定のバージョンに関連付けられているものに更新されます。 バージョンニングの詳細を参照してください。 |

| 3 | ベクターデータベースのさまざまなアクションを実行します。 |

| 4 | バージョニングの履歴を表示します。 バージョンをクリックすると、詳細および報告されたアセット(関連アイテム)が特定のバージョンに関連付けられているものに更新されます。 バージョンニングの詳細を参照してください。 |

| 5 | 関連するユースケースとLLMブループリント、デプロイされた顧客、ベクターデータベースを使用する登録済みモデルなど、ベクターデータベースに関連付けられた項目を表示します。 エンティティをクリックして、対応するコンソールタブで開きます。 |

| 6 | 選択したデータベースを使用するプレイグラウンドを作成します。 |

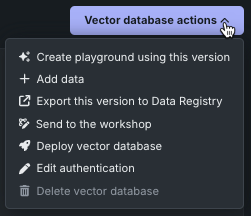

ベクターデータベースのアクション¶

アクションドロップダウンでは、表示中のベクターデータベースにアクションを適用できます。 実行可能なアクションは、ベクターデータベースのタイプや、メニューにアクセスしている場所によって若干異なります。

-

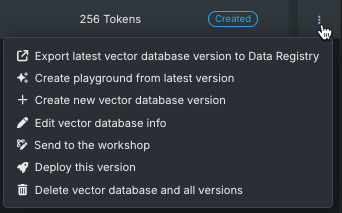

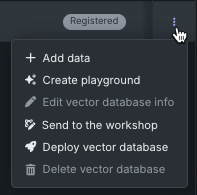

ベクターデータベースタイルからアクセスしたベクターデータベースのリストで、アクションメニュー を使用します。

-

ベクターデータベースタイルからベクターデータベースを開きます。モーダルに、そのデータベースの設定が詳細に表示されます。 メニューボタンベクターデータベースのアクションから、一連のアクションにアクセスできます。

アクションメニュー から、以下のことができます。

| アクション | 説明 |

|---|---|

| 最新のベクターデータベースバージョンをデータレジストリにエクスポート | 別のユースケースで再利用するために、選択したベクターデータベースの最新バージョンをデータレジストリにエクスポートします。 |

| 最新バージョンからプレイグラウンドを作成 | LLM設定にロードされたベクターデータベースで新しいプレイグラウンドを開きます。 |

| ベクターデータベースの新しいバージョンを作成 | 現在選択されているバージョンに基づいて、ベクターデータベースの新しいバージョンを作成します。 |

| ベクターデータベースの情報を編集 | ベクターデータベース名を変更するための入力ボックスを提供します。 |

| ワークショップに送信 | ベクターデータベースをワークショップに送信して、変更およびデプロイします。 詳細については、ベクターデータベースの登録とデプロイを参照してください。 |

| このバージョンをデプロイ | 選択した予測環境に最新バージョンのベクターデータベースをデプロイします。 詳細については、ベクターデータベースの登録とデプロイを参照してください。 |

| ベクターデータベースとすべてのバージョンを削除 | 親ベクターデータベースとすべてのバージョンを削除します。 デプロイで使用されるベクターデータベースはスナップショットであるため、ユースケースでベクターデータベースを削除しても、そのベクターデータベースを使用するデプロイには影響しません。 デプロイでは、ベクターデータベースの独立したスナップショットが使用されます。 |

| アクション | 説明 |

|---|---|

| データを追加 | 選択したデータソースを現在のベクターデータベースソースに追加します。 データはDataRobot内から追加され、プロバイダーに書き戻されます。 |

| プレイグラウンドの作成 | LLM設定にロードされたベクターデータベースで新しいプレイグラウンドを開きます。 |

| ベクターデータベースの情報を編集 | ベクターデータベース名を変更するための入力ボックスを提供します。 |

| ワークショップに送信 | ベクターデータベースをワークショップに送信して、変更およびデプロイします。 詳細については、ベクターデータベースの登録とデプロイを参照してください。 |

| ベクターデータベースをデプロイ | 選択した予測環境に更新されたベクターデータベースをデプロイします。 詳細については、ベクターデータベースの登録とデプロイを参照してください。 |

| ベクターデータベースを削除 | ベクターデータベースのインスタンスを削除します。 デプロイで使用されるベクターデータベースはスナップショットであるため、ユースケースでベクターデータベースを削除しても、そのベクターデータベースを使用するデプロイには影響しません。 デプロイでは、ベクターデータベースの独立したスナップショットが使用されます。 |

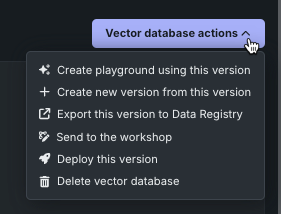

ベクターデータベースのアクションドロップダウンメニューから、以下のことができます。

| アクション | 説明 |

|---|---|

| このバージョンを使用してプレイグラウンドを作成 | LLM設定にロードされたベクターデータベースで新しいプレイグラウンドを開きます。 |

| このバージョンから新しいバージョンを作成 | 現在選択されているバージョンに基づいて、ベクターデータベースの新しいバージョンを作成します。 |

| このバージョンをデータレジストリにエクスポート | 別のユースケースで再利用するために、現在のベクターデータベースのバージョンをデータレジストリにエクスポートします。 |

| ワークショップに送信 | ベクターデータベースをワークショップに送信して、変更およびデプロイします。 詳細については、ベクターデータベースの登録とデプロイを参照してください。 |

| このバージョンをデプロイ | 選択した予測環境に最新バージョンのベクターデータベースをデプロイします。 詳細については、ベクターデータベースの登録とデプロイを参照してください。 |

| ベクターデータベースを削除 | 親ベクターデータベースとすべてのバージョンを削除します。 デプロイで使用されるベクターデータベースはスナップショットであるため、ユースケースでベクターデータベースを削除しても、そのベクターデータベースを使用するデプロイには影響しません。 デプロイでは、ベクターデータベースの独立したスナップショットが使用されます。 |

| アクション | 説明 |

|---|---|

| このバージョンを使用してプレイグラウンドを作成 | LLM設定にロードされたベクターデータベースで新しいプレイグラウンドを開きます。 |

| データを追加 | 選択したデータソースを現在のベクターデータベースソースに追加します。 データはDataRobot内から追加され、プロバイダーに書き戻されます。 |

| このバージョンをデータレジストリにエクスポート | 最新のベクターデータベースバージョンをデータレジストリにエクスポート その後、さまざまなユースケースのプレイグラウンドで使用することができます。 |

| ワークショップに送信 | ベクターデータベースをワークショップに送信して、変更およびデプロイします。 詳細については、ベクターデータベースの登録とデプロイを参照してください。 |

| ベクターデータベースをデプロイ | 選択した予測環境にベクターデータベースをデプロイします。 詳細については、ベクターデータベースの登録とデプロイを参照してください。 |

| 認証の編集 | 保存された資格情報の表示名を変更したり、新しい認証資格情報を追加したりできるモーダルを提供します。追加された認証資格情報は、その後、資格情報管理システムに保存されます。 上記のプロバイダー固有の資格情報を参照してください。 |

| ベクターデータベースを削除 | ベクターデータベースを削除します。 デプロイではベクターデータベースの独立したスナップショットが使用されるため、ユースケースでベクターデータベースを削除しても、そのベクターデータベースを使用するデプロイには影響しません。 |

詳細については、以下も参照してください。

ベクターデータベースの詳細¶

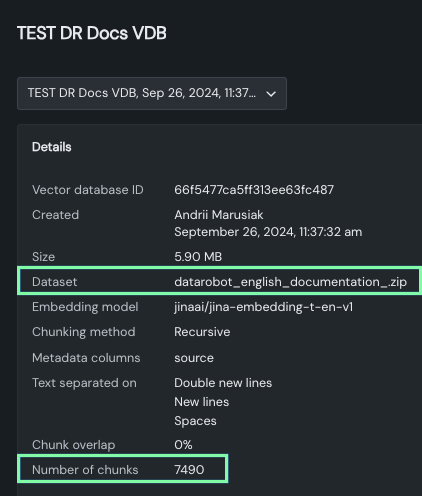

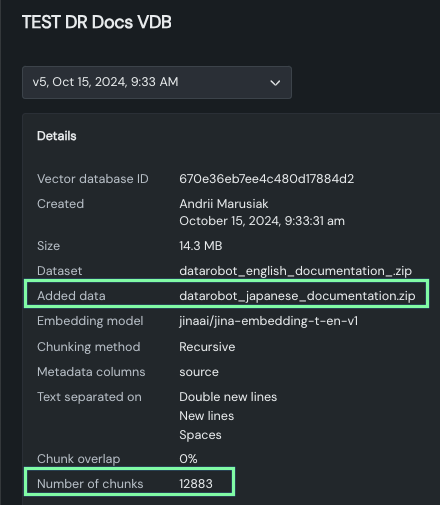

ベクターデータベースの展開ビューの詳細セクションには、ドロップダウンまたは右側のパネルから選択したバージョンに関する情報が表示されます。

- ベクターデータベースの基本メタデータ:ID、作成者と作成日、データソースの名前とサイズ。

- チャンキング設定:埋め込み列とチャンキング方法および設定。

- メタデータ列:後で メタデータのフィルターに使用できるデータソースの列の名前。

このエリアを使用してバージョンをすばやく比較し、設定の変更がチャンキング結果にどのように影響するかを確認します。 たとえば、DataRobotの英語版ドキュメントを使用する親バージョンの間で、チャンクのサイズと数がどのように変化するかに注目してください。

また、日本語ドキュメントを追加した状態で