本機能の提供について¶

以下のセクションでは、GenAIモデルの作成に含まれるさまざまな要素のサポートについて説明します。

- 利用可能なLLM。使用非推奨やサポート終了に関する情報も含まれます。

- 利用可能な埋め込み。多言語サポートも含まれます。

- 共有と権限。

- サポートされているデータセットタイプ。

トライアルユーザー

DataRobotの無料トライアルに関する注意事項をご覧ください。

ご参考までに、利用可能な各LLMの概要説明もご覧ください。

利用可能なLLM¶

LLMおよびLLM Gatewayを使用する際には、以下の点に注意してください。

LLM Gatewayを利用できるかどうかは、料金プランによって異なります。 利用できる場合、LLM Gateway経由で利用可能な特定のLLMは、最終的には組織の管理者が管理します。 以下のリストにあるLLMがLLMブループリントの構築時に選択オプションとして表示されない場合は、管理者に連絡してください。 外部のLLMプロバイダーとのインターフェイスに使用できるDataRobot APIエンドポイントについては、LLM Gatewayサービスのドキュメントも参照してください。 LLM GatewayサービスによるLLMの利用は、政府機関以外のリージョンに限定されています。

LLM Gatewayサービスでは利用できないLLMと連携するには、DataRobot Pythonクライアントを使用して外部LLM連携を構築および検証する方法の概要を説明したノートブックをご覧ください。

設定によっては、組織全体におけるチャット補完呼び出しの総数にレート制限が適用される場合があります。 上限に達したというメッセージがアプリケーションから返された場合、制限は24時間後にリセットされます。 リセットまでの時間はエラーメッセージに表示されます。 制限を解除するには、組織の料金プランを管理する管理者またはDataRobotの担当者に連絡してください。

LLM Gatewayの一部であるすべてのLLMは、デフォルトでは無効になっており、組織管理者のみが有効にできます。 ユーザーや組織でLLMを有効にするには、機能へのアクセスページでLLM_を検索します。利用可能なLLMの全リストが表示されます。 これらのLLMは、DataRobotプラットフォームでの実運用に対応しています。

さらに、組織管理者は、機能へのアクセスでファストトラックLLMを有効にするもオンにすることで、外部のLLMプロバイダーから最新のLLMにアクセスできるようになります。 これらのLLMについては、DataRobotのテストおよび承認プロセスがまだ完了していないため、本番環境での使用にはお勧めできません。

利用可能なプロバイダーリージョンの情報は、DataRobotのマネージドマルチテナントSaaS環境にのみ該当します。 セルフホスト型(シングルテナントSaaS、VPC、オンプレミス)のデプロイでは、プロバイダーリージョンはインストール構成に依存するため、この情報は該当しません。

以下の表は、プロバイダー別のLLMの一覧です。

以下の表は、利用可能なLLMをプロバイダー別に示したものですが、次の点に注意してください。

| インジケーター | 説明 |

|---|---|

| † | EUの規制により、EUプラットフォームのクラウドユーザーは、モデルへのアクセスができません。 |

| ‡ | 日本の規制により、JPプラットフォームのクラウドユーザーは、モデルへのアクセスができません。 |

| Δ | プレイグラウンドでLLMプロバイダーのサービスを呼び出すために使用されるモデルID。 この値は、デプロイされたLLMブループリントでボルトオンのガバナンスAPIを使用する際のmodelパラメーターの推奨値でもあります。 |

| © | Meta Llamaは、Meta Llama 4のコミュニティライセンスに基づいてライセンスされています。Copyright © Meta Platforms, Inc. All Rights Reserved. |

Amazon Bedrock¶

利用可能なAmazon Bedrock LLM

| タイプ | 最大コンテキストウィンドウ | 最大出力トークン数 | チャットモデルID Δ | 利用可能なプロバイダーリージョン |

|---|---|---|---|---|

| Amazon Nova Lite | 300,000 | 10,000 | bedrock/amazon.nova-lite-v1:0 |

|

| Amazon Nova Micro | 128,000 | 10,000 | bedrock/amazon.nova-micro-v1:0 |

|

| Amazon Nova Premier† | 1,000,000 | 32,000 | bedrock/amazon.nova-premier-v1:0 |

|

| Amazon Nova Pro | 300,000 | 10,000 | bedrock/amazon.nova-pro-v1:0 |

|

| Amazon Titan | 8,192 | 8,192 | bedrock/amazon.titan-text-express-v1 |

|

| Anthropic Claude Sonnet 4.5† | 200,000 | 64,000 | bedrock/anthropic.claude-sonnet-4-5-20250929-v1:0 |

|

| Anthropic Claude Sonnet 4† | 200,000 | 65,536 | bedrock/anthropic.claude-sonnet-4-20250514-v1:0 |

|

| Anthropic Claude Sonnet 3.7 v1 | 200,000 | 131,072 | bedrock/anthropic.claude-3-7-sonnet-20250219-v1:0 |

|

| Anthropic Claude Sonnet 3.5 v1 | 200,000 | 8,192 | bedrock/anthropic.claude-3-5-sonnet-20240620-v1:0 |

|

| Anthropic Claude Sonnet 3.5 v2† | 200,000 | 8,192 | bedrock/anthropic.claude-3-5-sonnet-20241022-v2:0 |

|

| Anthropic Claude Sonnet 3 | 200,000 | 4,096 | bedrock/anthropic.claude-3-sonnet-20240229-v1:0 |

|

| Anthropic Claude Opus 4.6 | 200,000 | 128,000 | bedrock/anthropic.claude-opus-4-6-v1 |

|

| Anthropic Claude Opus 4.5 | 200,000 | 64,000 | bedrock/anthropic.claude-opus-4-5-20251101-v1:0 |

|

| Anthropic Claude Opus 4.1† | 200,000 | 32,000 | bedrock/anthropic.claude-opus-4-1-20250805-v1:0 |

|

| Anthropic Claude Opus 4† | 200,000 | 32,768 | bedrock/anthropic.claude-opus-4-20250514-v1:0 |

|

| Anthropic Claude Opus 3† | 200,000 | 4,096 | bedrock/anthropic.claude-3-opus-20240229-v1:0 |

|

| Anthropic Claude Haiku 3.5 v1† | 200,000 | 8,192 | bedrock/anthropic.claude-3-5-haiku-20241022-v1:0 |

|

| Anthropic Claude Haiku 3 | 200,000 | 4,096 | bedrock/anthropic.claude-3-haiku-20240307-v1:0 |

|

| Anthropic Claude 2.1 | 200,000 | 4,096 | bedrock/anthropic.claude-v2:1 |

|

| Cohere Command R† | 128,000 | 4,096 | bedrock/cohere.command-r-v1:0 |

|

| Cohere Command R Plus† | 128,000 | 4,096 | bedrock/cohere.command-r-plus-v1:0 |

|

| DeepSeek R1 v1† | 128,000 | 32,768 | bedrock/deepseek.r1-v1:0 |

|

| Meta Llama 3 8B Instruct v1†© | 8,192 | 2,048 | bedrock/meta.llama3-8b-instruct-v1:0 |

|

| Meta Llama 3 70B Instruct v1†© | 8,192 | 2,048 | bedrock/meta.llama3-70b-instruct-v1:0 |

|

| Meta Llama 3.1 8B Instruct v1†© | 128,000 | 8,192 | bedrock/meta.llama3-1-8b-instruct-v1:0 |

|

| Meta Llama 3.1 70B Instruct v1†© | 128,000 | 8,192 | bedrock/meta.llama3-1-70b-instruct-v1:0 |

|

| Meta Llama 3.1 405B Instruct v1†© | 128,000 | 4,096 | bedrock/meta.llama3-1-405b-instruct-v1:0 |

|

| Meta Llama 3.2 1B Instruct v1© | 131,000 | 8,192 | bedrock/meta.llama3-2-1b-instruct-v1:0 |

|

| Meta Llama 3.2 3B Instruct v1© | 131,000 | 8,192 | bedrock/meta.llama3-2-3b-instruct-v1:0 |

|

| Meta Llama 3.2 11B Instruct v1†© | 128,000 | 8,192 | bedrock/meta.llama3-2-11b-instruct-v1:0 |

|

| Meta Llama 3.2 90B Instruct v1†© | 128,000 | 8,192 | bedrock/meta.llama3-2-90b-instruct-v1:0 |

|

| Meta Llama 3.3 70B Instruct v1†© | 128,000 | 8,192 | bedrock/meta.llama3-3-70b-instruct-v1:0 |

|

| Meta Llama 4 Maverick 17B Instruct v1†© | 1,000,000 | 8,192 | bedrock/meta.llama4-maverick-17b-instruct-v1:0 |

|

| Meta Llama 4 Scout 17B Instruct v1†© | 3,500,000 | 8,192 | bedrock/meta.llama4-scout-17b-instruct-v1:0 |

|

| Mistral Mistral 7B Instruct v0† | 32,768 | 8,192 | bedrock/mistral.mistral-7b-instruct-v0:2 |

|

| Mistral Mistral Large 2402 v1† | 32,768 | 8,192 | bedrock/mistral.mistral-large-2402-v1:0 |

|

| Mistral Mistral Small 2402 v1† | 32,768 | 8,192 | bedrock/mistral.mistral-small-2402-v1:0 |

|

| Mistral Mixtral 8x7B Instruct v0† | 32,768 | 4,096 | bedrock/mistral.mixtral-8x7b-instruct-v0:1 |

|

| NVIDIA Nemotron Nano 2 12B† | 128,000 | 128,000 | bedrock/converse/nvidia.nemotron-nano-12b-v2 |

|

| NVIDIA Nemotron Nano 2 9B† | 128,000 | 128,000 | bedrock/converse/nvidia.nemotron-nano-9b-v2 |

|

| OpenAI gpt-oss-20b | 131,072 | 128,000 | bedrock/openai.gpt-oss-20b-1:0 |

|

| OpenAI gpt-oss-120b | 131,072 | 128,000 | bedrock/openai.gpt-oss-120b-1:0 |

|

Azure OpenAI¶

利用可能なAzure OpenAI LLM

| タイプ | 最大コンテキストウィンドウ | 最大出力トークン数 | チャットモデルID Δ | 利用可能なプロバイダーリージョン |

|---|---|---|---|---|

| OpenAI GPT-5.2 | 400,000 | 128,000 | azure/gpt-5-2-2025-12-11 |

|

| OpenAI GPT-5.1 | 400,000 | 128,000 | azure/gpt-5-1-2025-11-13 |

|

| OpenAI GPT-5 Codex†‡ | 400,000 | 128,000 | azure/gpt-5-codex-2025-09-15 |

|

| OpenAI GPT-5 | 400,000 | 128,000 | azure/gpt-5-2025-08-07 |

|

| OpenAI GPT-5 mini | 400,000 | 128,000 | azure/gpt-5-mini-2025-08-07 |

|

| OpenAI GPT-5 nano | 400,000 | 128,000 | azure/gpt-5-nano-2025-08-07 |

|

| OpenAI GPT-4o | 128,000 | 16,384 | azure/gpt-4o-2024-11-20 |

|

| OpenAI GPT-4o mini | 128,000 | 16,384 | azure/gpt-4o-mini |

|

| OpenAI GPT-4 Turbo | 128,000 | 4,096 | azure/gpt-4-turbo |

|

| OpenAI GPT-3.5 Turbo | 16,385 | 4,096 | azure/gpt-35-turbo |

|

| OpenAI o4-mini | 200,000 | 100,000 | azure/o4-mini |

|

| OpenAI o3 | 200,000 | 100,000 | azure/o3 |

|

| OpenAI o3-mini | 200,000 | 100,000 | azure/o3-mini |

|

| OpenAI o1 | 200,000 | 100,000 | azure/o1 |

|

Google VertexAI¶

利用可能なGoogle VertexAI LLM

| タイプ | 最大コンテキストウィンドウ | 最大出力トークン数 | チャットモデルID Δ | 利用可能なプロバイダーリージョン |

|---|---|---|---|---|

| Google Gemini 3 Pro Preview†‡ | 1,048,576 | 65,536 | vertex_ai/gemini-3-pro-preview |

|

| Google Gemini 2.5 Pro | 1,048,576 | 65,535 | vertex_ai/gemini-2.5-pro |

|

| Google Gemini 2.5 Flash | 1,048,576 | 65,535 | vertex_ai/gemini-2.5-flash |

|

| Google Gemini 2.0 Flash | 1,048,576 | 8,192 | vertex_ai/gemini-2.0-flash-001 |

|

| Google Gemini 2.0 Flash Lite | 1,048,576 | 8,192 | vertex_ai/gemini-2.0-flash-lite-001 |

|

| Google Gemini 1.5 Pro | 1,048,576 | 8,192 | vertex_ai/gemini-1.5-pro-002 |

|

| Google Gemini 1.5 Flash | 1,048,576 | 8,192 | vertex_ai/gemini-1.5-flash-002 |

|

| Claude Sonnet 4.5 | 200,000 | 64,000 | vertex_ai/claude-sonnet-4-5@20250929 |

|

| Claude Sonnet 4 | 200,000 | 64,000 | vertex_ai/claude-sonnet-4@20250514 |

|

| Claude Sonnet 3.7 | 200,000 | 64,000 | vertex_ai/claude-3-7-sonnet@20250219 |

|

| Claude Sonnet 3.5 v2 | 200,000 | 8,192 | vertex_ai/claude-3-5-sonnet-v2@20241022 |

|

| Claude Sonnet 3.5 | 200,000 | 8,192 | vertex_ai/claude-3-5-sonnet@20240620 |

|

| Claude Opus 4.1† | 200,000 | 32,000 | vertex_ai/claude-opus-4-1@20250805 |

|

| Claude Opus 4† | 200,000 | 32,000 | vertex_ai/claude-opus-4@20250514 |

|

| Claude Opus 3† | 200,000 | 4,096 | vertex_ai/claude-3-opus@20240229 |

|

| Claude Haiku3.5 † | 200,000 | 8,192 | vertex_ai/claude-3-5-haiku@20241022 |

|

| Claude Haiku 3 | 200,000 | 4,096 | vertex_ai/claude-3-haiku@20240307 |

|

| Llama 3.1 8B Instruct MAAS† © | 128,000 | 8,192 | vertex_ai/meta/llama-3.1-8b-instruct-maas |

|

| Llama 3.1 70B Instruct MAAS† © | 128,000 | 8,192 | vertex_ai/meta/llama-3.1-70b-instruct-maas |

|

| Llama 3.1 405B Instruct MAAS† © | 128,000 | 8,192 | vertex_ai/meta/llama-3.1-405b-instruct-maas |

|

| Llama 3.2 90B Vision Instruct† © | 128,000 | 8,192 | vertex_ai/meta/llama-3.2-90b-vision-instruct-maas |

|

| Llama 3.3 70B Instruct† © | 128,000 | 8,192 | vertex_ai/meta/llama-3.3-70b-instruct-maas |

|

| Llama 4 Maverick 17B 128E Instruct MAAS† © | 524,288 | 8,192 | vertex_ai/meta/llama-4-maverick-17b-128e-instruct-maas |

|

| Llama 4 Scout 17B 16E Instruct MAAS† © | 1,310,720 | 8,192 | vertex_ai/meta/llama-4-scout-17b-16e-instruct-maas |

|

Anthropic¶

利用可能なAnthropic LLM

| タイプ | 最大コンテキストウィンドウ | 最大出力トークン数 | チャットモデルID Δ | 利用可能なプロバイダーリージョン |

|---|---|---|---|---|

| Anthropic Claude Sonnet 4.5 | 200,000 | 64,000 | anthropic/claude-sonnet-4-5-20250929 |

|

| Anthropic Claude Sonnet 4 | 200,000 | 64,000 | anthropic/claude-sonnet-4-20250514 |

|

| Anthropic Claude Sonnet 3.7 | 200,000 | 64,000 | anthropic/claude-3-7-sonnet-20250219 |

|

| Anthropic Claude Sonnet 3.5 v1 | 200,000 | 8,192 | anthropic/claude-3-5-sonnet-20240620 |

|

| Anthropic Claude Sonnet 3.5 v2 | 200,000 | 8,192 | anthropic/claude-3-5-sonnet-20241022 |

|

| Anthropic Claude Opus 4.6 | 200,000 | 128,000 | anthropic/claude-opus-4-6 |

|

| Anthropic Claude Opus 4.5 | 200,000 | 64,000 | anthropic/claude-opus-4-5-20251101 |

|

| Anthropic Claude Opus 4.1 | 200,000 | 32,000 | anthropic/claude-opus-4-1-20250805 |

|

| Anthropic Claude Opus 4 | 200,000 | 32,000 | anthropic/claude-opus-4-20250514 |

|

| Anthropic Claude Haiku 3.5 | 200,000 | 8,192 | anthropic/claude-3-5-haiku-20241022 |

|

| Anthropic Claude Haiku 3 | 200,000 | 4,096 | anthropic/claude-3-haiku-20240307 |

|

Cerebras¶

利用可能なCerebras LLM

| タイプ | 最大コンテキストウィンドウ | 最大出力トークン数 | チャットモデルID Δ | 利用可能なプロバイダーリージョン |

|---|---|---|---|---|

| Cerebras Llama 3.1 8B | 128,000 | 8,192 | cerebras/llama3.1-8b |

|

| Cerebras Llama 3.3 70B | 128,000 | 8,192 | cerebras/llama-3.3-70b |

|

| Cerebras Llama 4 Scout 17B 16E Instruct | 32,000 | 8,192 | cerebras/llama-4-scout-17b-16e-instruct |

|

| Cerebras Qwen 3 32B | 128,000 | 8,192 | cerebras/qwen-3-32b |

|

| Cerebras Qwen 3 235B Instruct | 128,000 | 8,192 | cerebras/qwen-3-235b-a22b-instruct-2507 |

|

TogetherAI¶

利用可能なTogetherAI LLM

| タイプ | 最大コンテキストウィンドウ | 最大出力トークン数 | チャットモデルID Δ | 利用可能なプロバイダーリージョン |

|---|---|---|---|---|

| Arcee AI Virtuoso Large | 131,072 | 65,537 | together_ai/arcee-ai/virtuoso-large |

グローバル |

| Arcee AI Coder-Large | 32,768 | 32,768 | together_ai/arcee-ai/coder-large |

グローバル |

| Arcee AI Maestro Reasoning | 131,072 | 32,768 | together_ai/arcee-ai/maestro-reasoning |

グローバル |

| Google Gemma 3N E4B Instruct | 32,768 | 32,768 | together_ai/google/gemma-3n-E4B-it |

グローバル |

| Meta Llama 3 8B Instruct Lite | 8,192 | 8,192 | together_ai/meta-llama/Meta-Llama-3-8B-Instruct-Lite |

グローバル |

| Meta Llama 3.1 8B Instruct Turbo | 131,073 | 131,073 | together_ai/meta-llama/Meta-Llama-3.1-8B-Instruct-Turbo |

グローバル |

| Meta Llama 3.2 3B Instruct Turbo | 131,073 | 131,073 | together_ai/meta-llama/Llama-3.2-3B-Instruct-Turbo |

グローバル |

| Meta Llama 3.3 70B Instruct Turbo | 131,073 | 131,073 | together_ai/meta-llama/Llama-3.3-70B-Instruct-Turbo |

グローバル |

| Meta Llama 4 Maverick Instruct (17Bx128E) | 1,048,576 | 32,768 | together_ai/meta-llama/Llama-4-Maverick-17B-128E-Instruct-FP8 |

グローバル |

| Mistral Small 3 Instruct (24B) | 32,768 | 32,768 | together_ai/mistralai/Mistral-Small-24B-Instruct-2501 |

グローバル |

| Mistral Mixtral-8x7B Instruct v0.1 | 32,768 | 32,768 | together_ai/mistralai/Mixtral-8x7B-Instruct-v0.1 |

グローバル |

使用非推奨のLLMとサポートが終了したLLM¶

急速に進化するエージェント型AIの状況において、LLMは常に改善されており、古いモデルは新しいバージョンで置き換えられています。 これに対処するため、DataRobotのLLM使用非推奨プロセスでは、LLMとLLMブループリントにバッジを付けて、今後の変更を示しています。 なお、サポート終了日はプロバイダーが定めるものであり、変更される場合があります。

以下のLLMは現在、またはまもなく使用非推奨になります。

| LLM | サポート終了日 |

|---|---|

| Anthropic Claude 2.1 | サポート終了 |

| Anthropic Claude 3 Sonnet | サポート終了 |

| Anthropic Claude Opus 3 | サポート終了 |

| Cohere Command Light Text v14 | サポート終了 |

| Cohere Command Text v14 | サポート終了 |

| Titan | サポート終了 |

| LLM | サポート終了日 |

|---|---|

| GPT-3.5 Turbo | サポート終了 |

| GPT-3.5 Turbo 16k | サポート終了 |

| GPT-4 | サポート終了 |

| GPT-4 32k | サポート終了 |

| GPT-4 Turbo | サポート終了 |

| GPT-4o Mini | サポート終了 |

| o1-mini | サポート終了 |

| LLM | サポート終了日 |

|---|---|

| Bison | サポート終了 |

| Gemini 1.5 Flash | サポート終了 |

| Gemini 1.5 Pro | サポート終了 |

| Mistral CodeStral 2501 | サポート終了 |

| Mistral Large 2411 | サポート終了 |

| LLM | サポート終了日 |

|---|---|

| Claude Opus 3 | サポート終了 |

| LLM | サポート終了日 |

|---|---|

| Cerebras Qwen 3 32B | サポート終了 |

| Cerebras Llama 3.3 70B | サポート終了 |

| LLM | サポート終了日 |

|---|---|

| Meta Llama 3 70B Instruct Reference | サポート終了 |

| Meta Llama 3.1 405B Instruct Turbo | サポート終了 |

| Meta Llama 4 Scout Instruct | サポート終了 |

| Mistral (7B) Instruct | サポート終了 |

| Mistral (7B) Instruct v0.3 | サポート終了 |

| Mistral (7B) Instruct v0.2 | サポート終了 |

| Marin Community Marin 8B Instruct | サポート終了 |

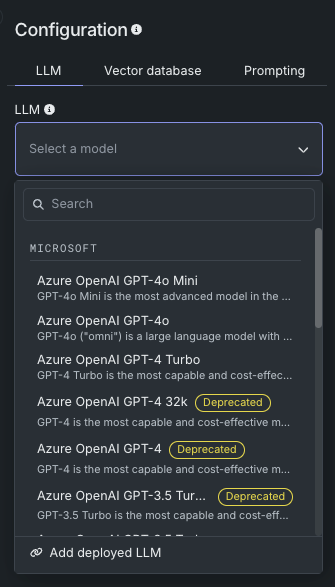

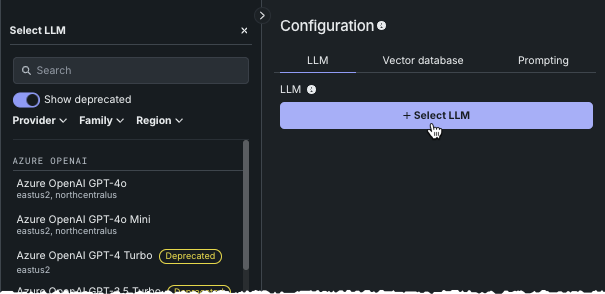

プロバイダーのサポートが予期せず終了する事態からエクスペリメントやデプロイを保護するため、使用非推奨のLLMを示すバッジがLLMブループリント作成パネルに表示されます。

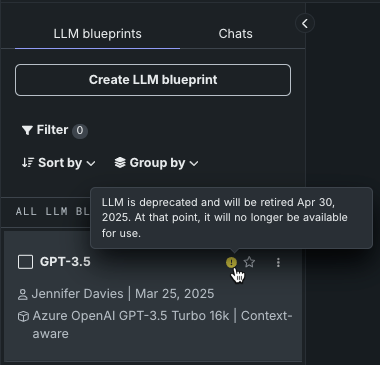

あるいは、作成済みの場合、影響を受けるLLMブループリントには警告や通知が示され、カーソルを合わせると日付が表示されます。

LLMブループリントが構築されると、LLMブループリントタブ に表示されます。 使用非推奨またはサポートが終了したLLMブループリントには警告や通知が示され、カーソルを合わせると日付が表示されます。

-

LLMが使用非推奨プロセスにある場合、そのLLMのサポートは90日以内に終了します。 バッジと警告が表示されますが、機能は制限されません。

-

サポートが終了すると、そのモデルから作成されたアセットは引き続き表示できますが、新しいアセットは作成できません。 サポートが終了したLLMは、単一のプロンプトや比較プロンプトでは使用できません。

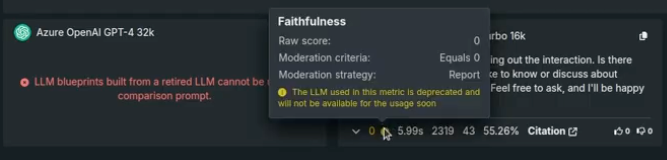

一部の評価指標、たとえば忠実度や正確性などは、その設定でLLMを使用します。 それらの場合、指標の表示または設定時、およびプロンプトの回答にメッセージが表示されます。

LLMがデプロイされている場合、DataRobotはベースとなるLLMに使用されている資格情報を制御できないため、デプロイは予測を返すことができません。 このような場合は、デプロイ済みのLLMを新しいモデルに置き換えてください。

利用可能な埋め込み¶

DataRobotは、データをエンコードするために次のタイプの埋め込みをサポートしています。すべての埋め込みは、教師ありデータと教師なしデータの混合で学習された変換モデルです。

| 埋め込みタイプ | 説明 | 言語 |

|---|---|---|

| cl-nagoya/sup-simcse-ja-base | 名古屋大学 大学院情報学研究科(「Japanese SimCSE Technical Report」)による中規模言語モデル。 日本語RAGの高速モデルです。

|

日本語 |

| huggingface.co/intfloat/multilingual-e5-base | 複数の言語で多言語RAG処理に使用されるMicrosoft Researchの中規模言語モデル(「大規模多言語コーパスでの弱教師付き対照事前トレーニング」)。

|

100以上、 ISO 639を参照 |

| huggingface.co/intfloat/multilingual-e5-small | 多言語RAG処理に使用するMicrosoft Researchの小規模言語モデル(「大規模多言語コーパスでの弱教師付き対照事前トレーニング」)で、MULTILINGUAL_E5_BASEよりも高速です。 この埋め込みモデルは、低レイテンシーのアプリケーションに適しています。

|

100以上、 ISO 639を参照 |

| intfloat/e5-base-v2 | 中〜高程度のRAGパフォーマンスを実現するためのMicrosoft Researchの中規模言語モデル(「大規模英語コーパスでの弱教師付き対照事前トレーニング」)。 パラメーターが少なく、アーキテクチャが小さいため、E5_LARGE_V2よりも高速です。

|

英語 |

| intfloat/e5-large-v2 | 最適なRAGパフォーマンスを実現するように設計されたMicrosoft Researchの大規模言語モデル(「大規模英語コーパスでの弱教師付き対照事前トレーニング」)。 そのアーキテクチャとサイズにより、低速と分類されます。

|

英語 |

| jinaai/jina-embedding-t-en-v1 | Jina AIのLinnaeus-Cleanデータセットを使用してトレーニングされた小さな言語モデル。 英語コーパスで事前にトレーニングされており、DataRobotが提供する埋め込みモデルの中で最も高速で、デフォルトのモデルです。

|

英語 |

| jinaai/jina-embedding-s-en-v2 | Jina Embeddings v2ファミリーの1つであるこの埋め込みモデルは、長いドキュメントの埋め込みに最適です(最大8192の大きなチャンクサイズ)。

|

英語 |

| sentence-transformers/all-MiniLM-L6-v2 | 10億個のセンテンスペアのデータセットでファインチューニングされた小さな言語モデル。 比較的高速で、英語のコーパスで事前トレーニングされています。 ただし、古いデータでトレーニングされているため、RAGには推奨されません。

|

英語 |

* 入力ディメンション = max_sequence_length

E5-baseおよびE5-smallの多言語サポート。ISO 639も参照してください。

対応言語:

"アフリカーンス語",

"アムハラ語",

"アラビア語",

"アッサム語",

"アゼルバイジャン語",

"ベラルーシ語",

"ブルガリア語",

"ベンガル語",

"ブルトン語",

"ボスニア語",

"カタルーニャ語",

"チェコ語",

"ウェールズ語",

"デンマーク語",

"ドイツ人語",

"ギリシャ語",

"英語",

"エスペラント語",

"スペイン語",

"エストニア語",

"バスク語",

"ペルシャ語",

"フィンランド語",

"フランス語",

"西フリジア語",

"アイルランド語",

"スコットランドのゲール語",

"ガリシア語",

"グジャラート語",

"ハウサ語",

"ヘブライ語",

"ヒンディー語",

"クロアチア語",

"ハンガリー語",

"アルメニア語",

"インドネシア語",

"アイスランド語",

"イタリア語",

"日本語",

"ジャワ語",

"ジョージア語",

"カザフ語",

"クメール語",

"カンナダ語",

"韓国語",

"クルド語",

"キルギス語",

"ラテン語",

"ラオス語",

"リトアニア語",

"ラトビア語",

"マダガスカル語",

"マケドニア語",

"マラヤーラム語",

"モンゴル語",

"マラーティー語",

"マレー語",

"ビルマ語",

"ネパール語",

"オランダ語",

"ノルウェー語",

"オロモ語",

"オリヤ語",

"パンジャブ語",

"ポーランド語",

"パシュトゥー語",

"ポルトガル語",

"ルーマニア語",

"ロシア語",

"サンスクリット語",

"シンド語",

"シンハラ語",

"スロバキア語",

"スロベニア語",

"ソマリ語",

"アルバニア語",

"セルビア語",

"スンダ語",

"スウェーデン語",

"スワヒリ語",

"タミル語",

"テルグ語",

"タイ語",

"タガログ語",

"トルコ語",

"ウイグル語",

"ウクライナ語",

"ウルドゥー語",

"ウズベク語",

"ベトナム語",

"コサ語",

"イディッシュ語",

"中国語",

共有と権限¶

以下の表に、GenAIコンポーネント関連のユーザー権限を示します。 すべてのロール(コンシューマー、エディター、オーナー)は、ユースケースにおけるユーザーのロールを示しています。さまざまな機能へのアクセスは、ユースケースの役割に基づきます。 たとえば、共有はユースケースレベルで処理されるため、ベクターデータベースのみを共有することはできません(ベクターデータベースでは共有ルールは定義されません)。

GenAI機能に対する権限

| 機能 | ユースケースのコンシューマー | ユースケースのエディター | ユースケースのオーナー |

|---|---|---|---|

| ベクターデータベース | |||

| ベクターデータベースの作成者 | |||

| ベクターデータベースを作成 | ✘ | ✔ | ✔ |

| ベクターデータベースバージョンの作成 | ✘ | ✔ | ✔ |

| ベクターデータベースの情報を編集 | ✘ | ✔ | ✔ |

| ベクターデータベースを削除 | ✘ | ✔ | ✔ |

| ベクターデータベースの非作成者 | |||

| ベクターデータベースの情報を編集 | ✘ | ✘ | ✔ |

| ベクターデータベースを削除 | ✘ | ✘ | ✔ |

| プレイグラウンド | |||

| プレイグラウンドの作成者 | |||

| プレイグラウンドの作成 | ✘ | ✔ | ✔ |

| プレイグラウンド名の変更 | ✘ | ✔ | ✔ |

| プレイグラウンドの説明を編集 | ✘ | ✔ | ✔ |

| プレイグラウンドを削除 | ✘ | ✔ | ✔ |

| プレイグラウンドの非作成者 | |||

| プレイグラウンドの説明を編集 | ✘ | ✘ | ✔ |

| プレイグラウンドを削除 | ✘ | ✘ | ✔ |

| プレイグラウンド → 評価タブ | |||

| 評価の設定 | ✘ | ✔ | ✔ |

| 評価指標を有効/無効にする | ✘ | ✔ | ✔ |

| プレイグラウンド → トレースタブ | |||

| ログをダウンロード | ✔ | ✔ | ✔ |

| AIカタログにアップロード | ✔ | ✔ | ✔ |

| 他者が作成したLLMブループリント(ユースケースを共有) | |||

| 設定 | ✘ | ✘ | ✘ |

| プロンプトの送信(設定から) | ✘ | ✘ | ✘ |

| 集計された指標を生成 | ✘ | ✔ | ✔ |

| 会話の作成(比較から) | ✘ | ✘ | ✘ |

| 回答に賛成/反対 | ✔ | ✔ | ✔ |

| スターを付ける/お気に入り | ✘ | ✘ | ✘ |

| 新しいLLMブループリントにコピー | ✘ | ✔ | ✔ |

| 削除 | ✘ | ✘ | ✘ |

| 登録 | ✘ | ✘ | ✘ |

サポートされているデータセットタイプ¶

ベクターデータベースの作成に使用するデータセットをアップロードする場合、サポートされている形式は.zipまたは.csvです。 ファイルにはdocumentとdocument_file_pathの2つの列が必須です。 最大50のメタデータ列を追加して、プロンプトクエリーの際にフィルターに使用することができます。 メタデータのフィルターでは、document_file_pathがsourceとして表示されます。

.zipファイルの場合、DataRobotはファイルを処理して、関連するリファレンスID(document_file_path)列を持つテキスト列(document)を含む.csvバージョンを作成します。 テキスト列の内容はすべて、文字列として扱われます。 リファレンスID列は、.zipがアップロードされると自動的に作成されます。 すべてのファイルは、アーカイブのルート(root)、またはアーカイブ内の単一のフォルダーに配置する必要があります。 フォルダーツリー階層の使用はサポートされていません。

ファイルタイプに関して、DataRobotは以下をサポートします。

-

.txtドキュメント -

PDFドキュメント

- テキストベースのPDFがサポートされています。

- 画像ベースのPDFからテキストを抽出するには、Python APIクライアントを使う必要があります。 GUIを使用して画像ベースのPDFからテキストを抽出することは、完全にはサポートされていません。

- 画像とテキストコンテンツが混在するドキュメントがサポートされます。テキストのみが解析されます。

- 画像だけで構成される単一のドキュメントは空のドキュメントになり、無視されます。

- 画像のみのドキュメント(テキストなし)で構成されるデータセットは処理できません。

-

.docxドキュメントはサポートされていますが、古い.doc形式はサポートされていません。 -

.mdドキュメント(および.markdown形式)はサポートされています。 -

単一のデータセットでサポートされているすべてのドキュメントタイプを組み合わせることができます。