DataRobotのモデレーションを備えたNVIDIA NeMo Guardrailsの使用¶

プレミアム機能

DataRobotでNVIDIA Inference Microservices (NIM)を利用するには、GenAIのエクスペリメントとGPUを使用した推論のためのプレミアム機能にアクセスする必要があります。 NVIDIA NeMo Guardrailsはプレミアム機能です。 この機能を有効にする方法については、DataRobotの担当者または管理者にお問い合わせください。

追加の機能フラグ:モデレーションのガードレールを有効にする(プレミアム機能)、モデルレジストリでグローバルモデルを有効にする(プレミアム機能)、予測応答で追加のカスタムモデル出力を有効にする

DataRobotには、すぐに使用できるガードレールが用意されており、単純なルール、コード、またはモデルを使用してアプリケーションをカスタマイズできます。 NVIDIA Inference Microservices (NIM)を使用して、DataRobotのテキスト生成モデルにNVIDIA NeMo Guardrailsを接続することで、トピックから外れたディスカッション、安全でないコンテンツ、ジェイルブレイクの試みから保護できます。 以下のNVIDIA NeMo Guardrailsが利用可能であり、関連する評価指標タイプを使用して実装できます。

| モデル名 | 評価指標のタイプ |

|---|---|

llama-3.1-nemoguard-8b-content-safety |

カスタムデプロイ |

llama-3.1-nemoguard-8b-topic-control |

入力のトピックを維持 / 出力のトピックを維持 |

nemoguard-jailbreak-detect |

カスタムデプロイ |

デプロイされたNIMをNVIDIA NeMo Guardrailsで使用する¶

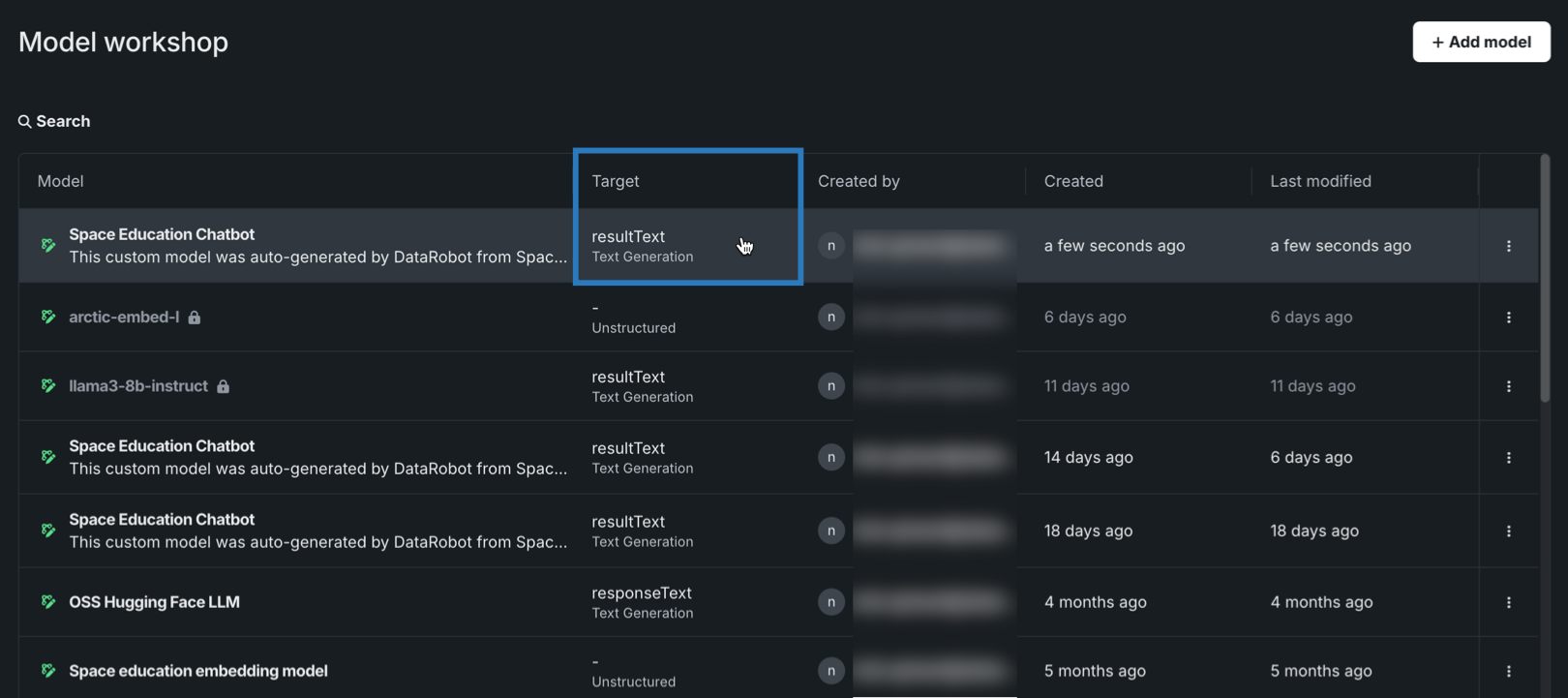

デプロイされたllama-3.1-nemoguard-8b-topic-control NVIDIA NIMをトピックを維持評価指標で使用するには、NVIDIA NeMo Guardrailを登録し、デプロイします。 ターゲットタイプがテキスト生成であるカスタムモデルを作成したら、トピック維持の評価指標を設定します。

トピック制御のためにNVIDIA NeMo Guardrailsを選択して設定するには:

-

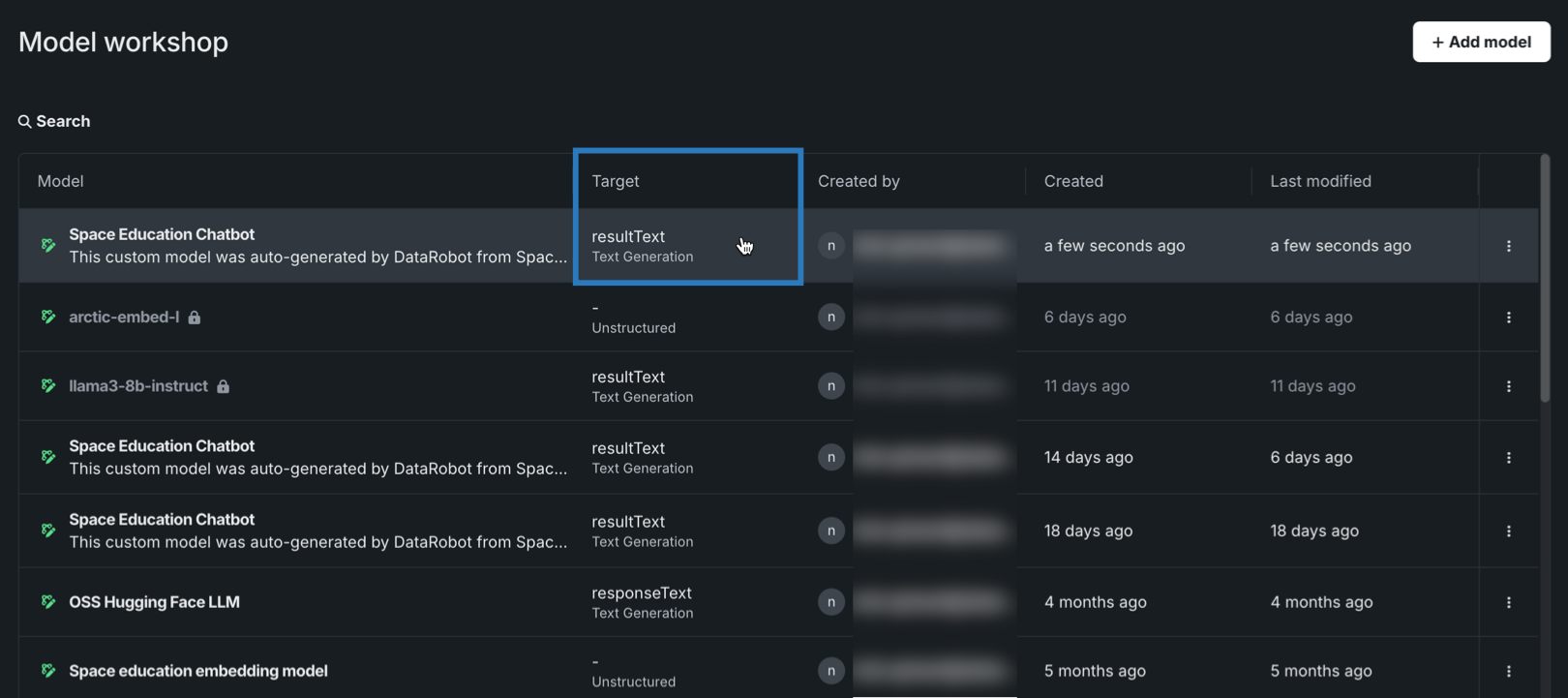

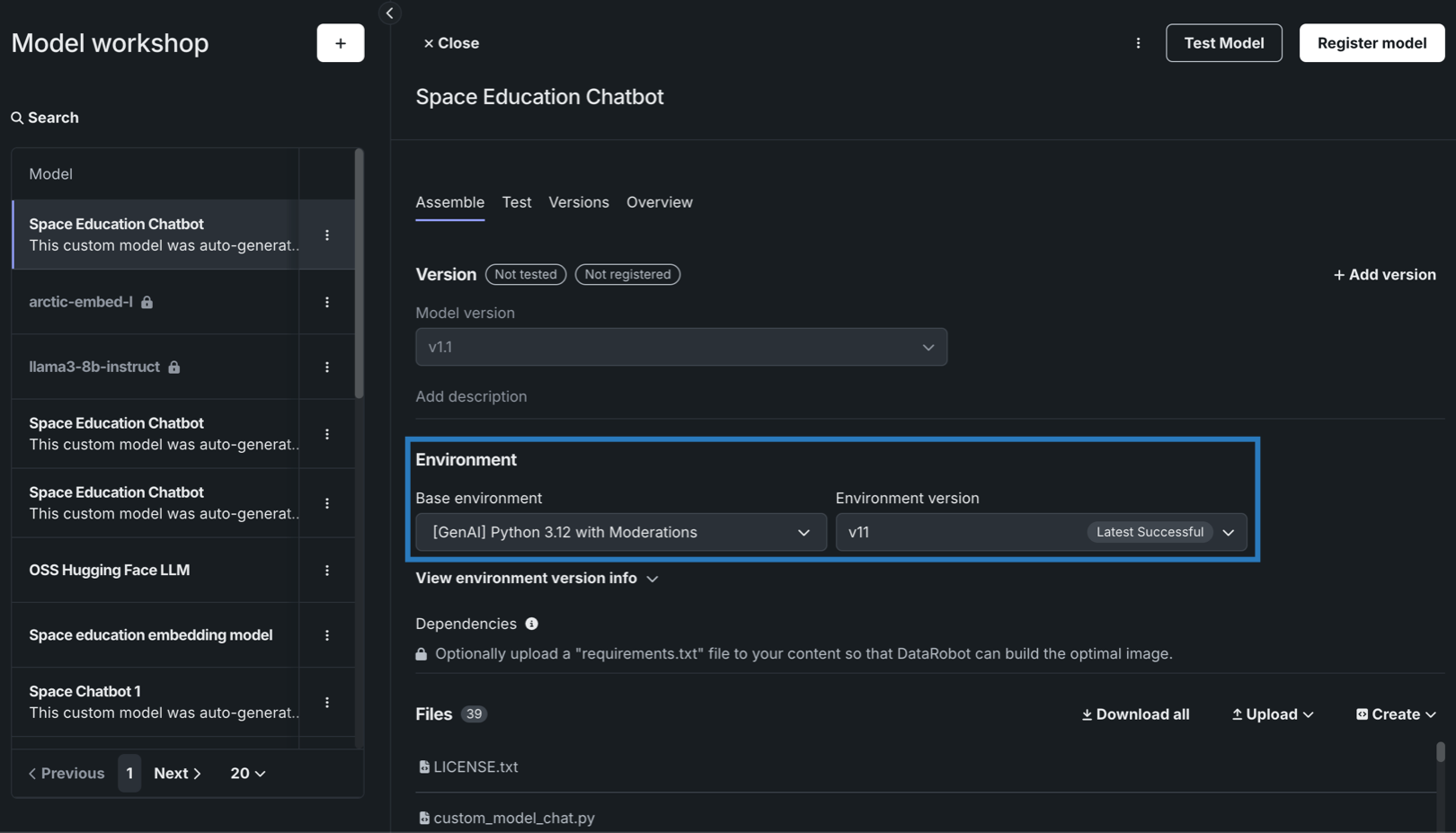

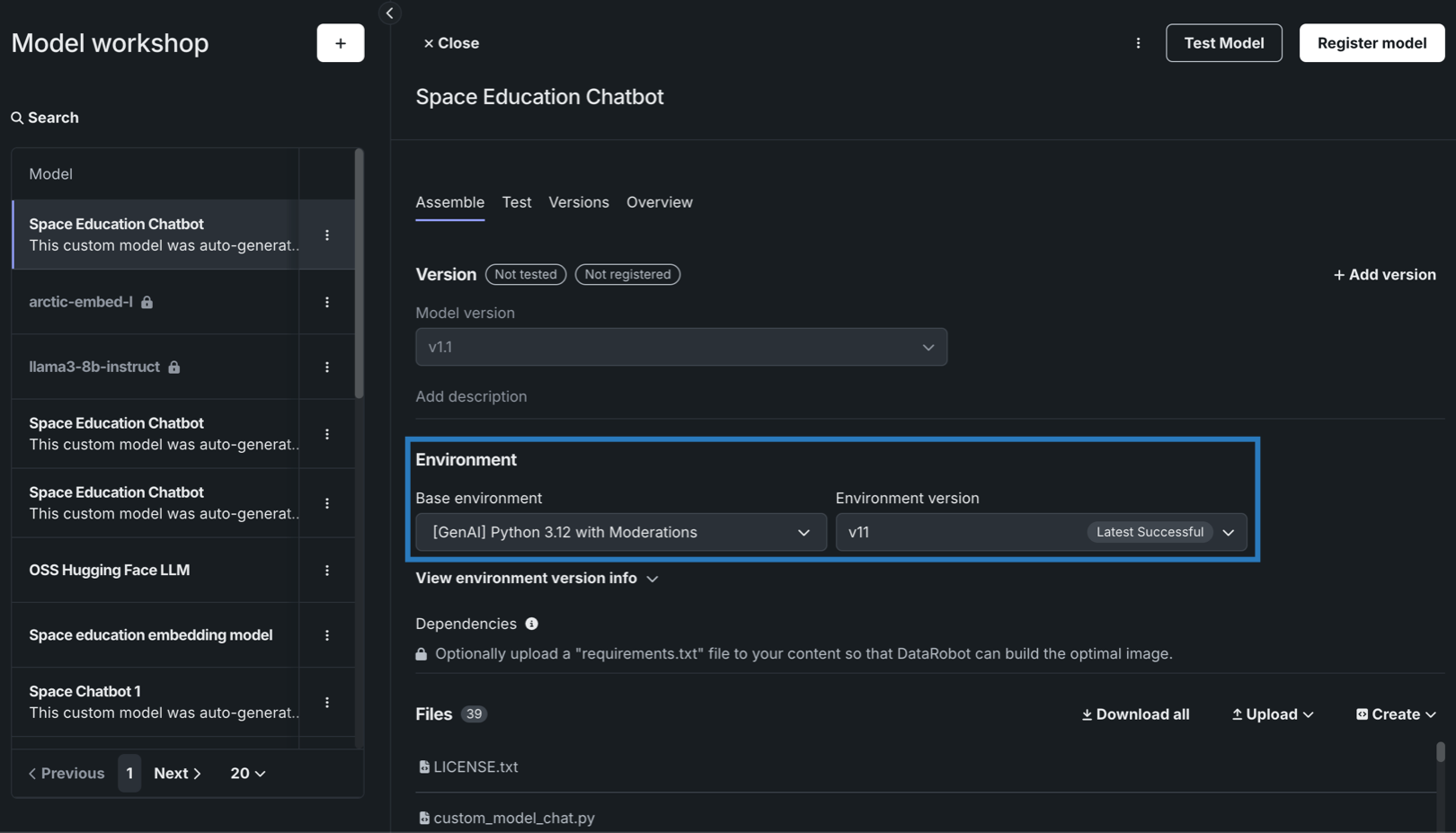

モデルワークショップで、テキスト生成ターゲットタイプを持つカスタムモデルのアセンブルタブを開き、 DataRobotの外部で作成したカスタムモデルから手動で、または ユースケースのLLMプレイグラウンドで作成されたモデルから自動的に モデルを構築します。

モデレーションを使ってテキスト生成モデルを構築する場合、必要なランタイムパラメーター(資格情報など)の設定やリソース設定(パブリックネットワークへのアクセスなど)を必ず行います。 最後に、基本環境をモデレーション対応の環境([GenAI] Python 3.12 with Moderationsなど)に設定します。

リソース設定

DataRobotでは、より多くのメモリーおよびCPUリソースを備えた、より大きなリソースバンドルを使用してLLMカスタムモデルを作成することをお勧めします。

-

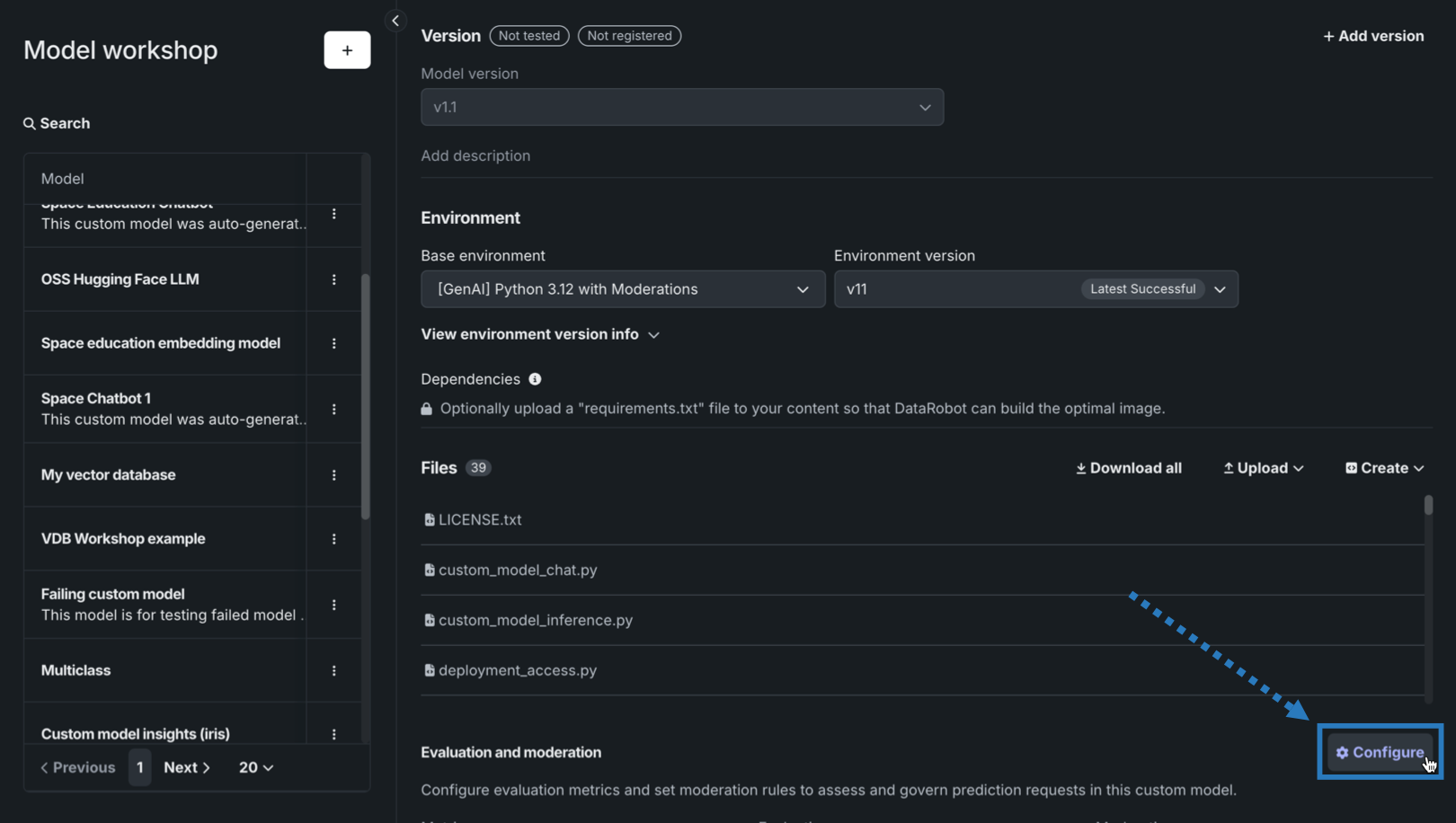

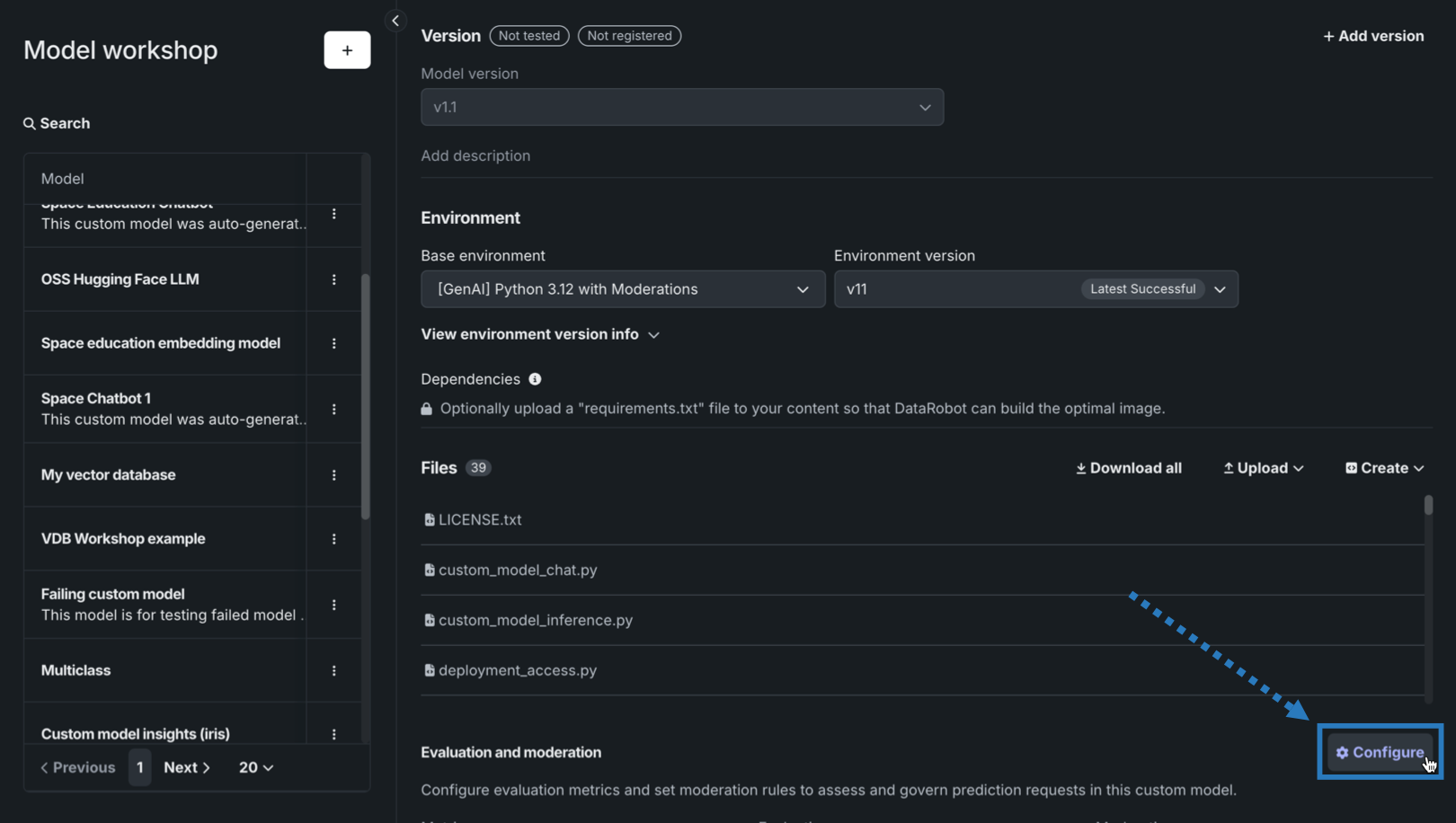

カスタムモデルに必要な設定を行ったら、評価とモデレーションセクションに移動し、 設定をクリックします。

-

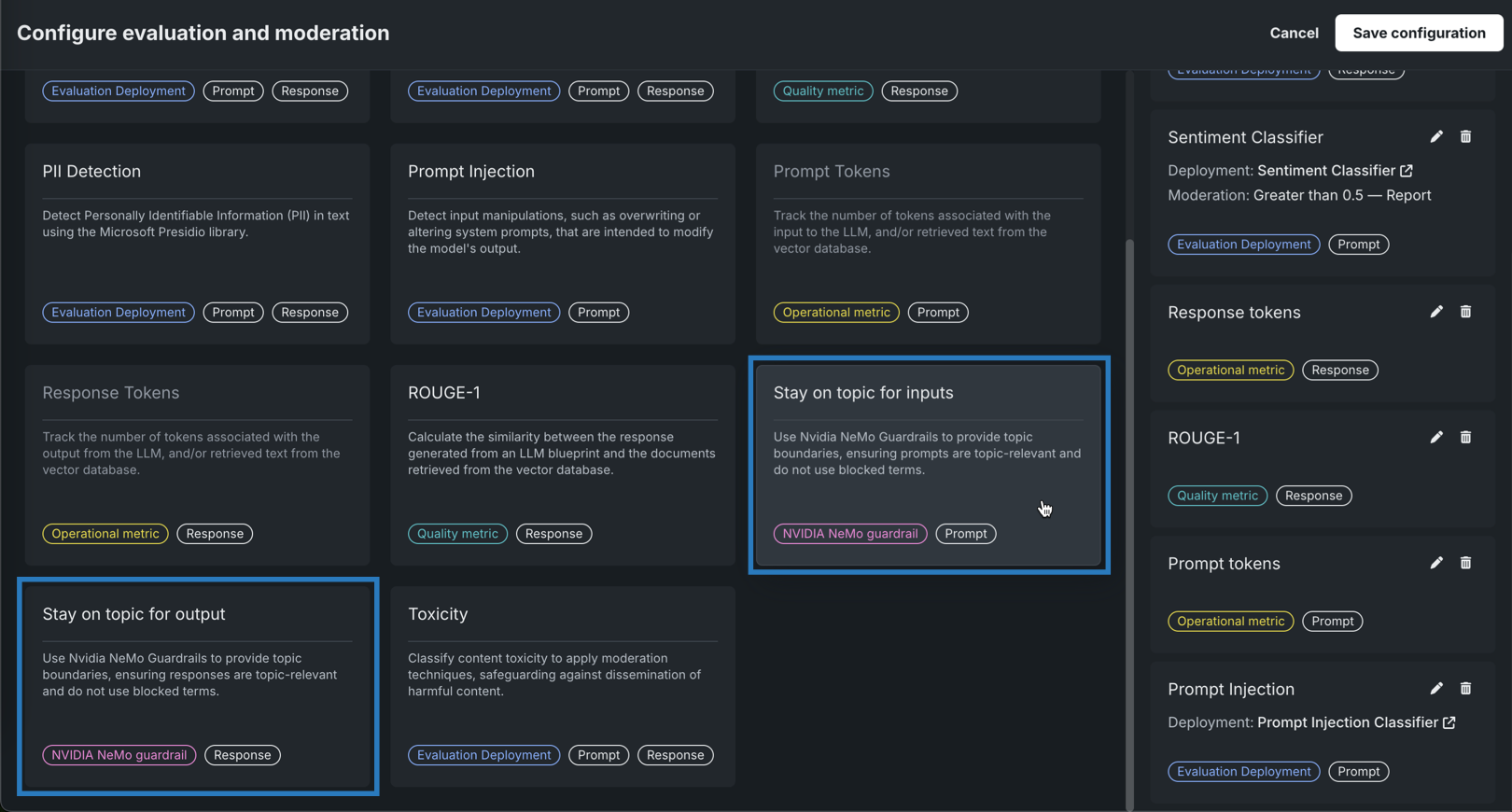

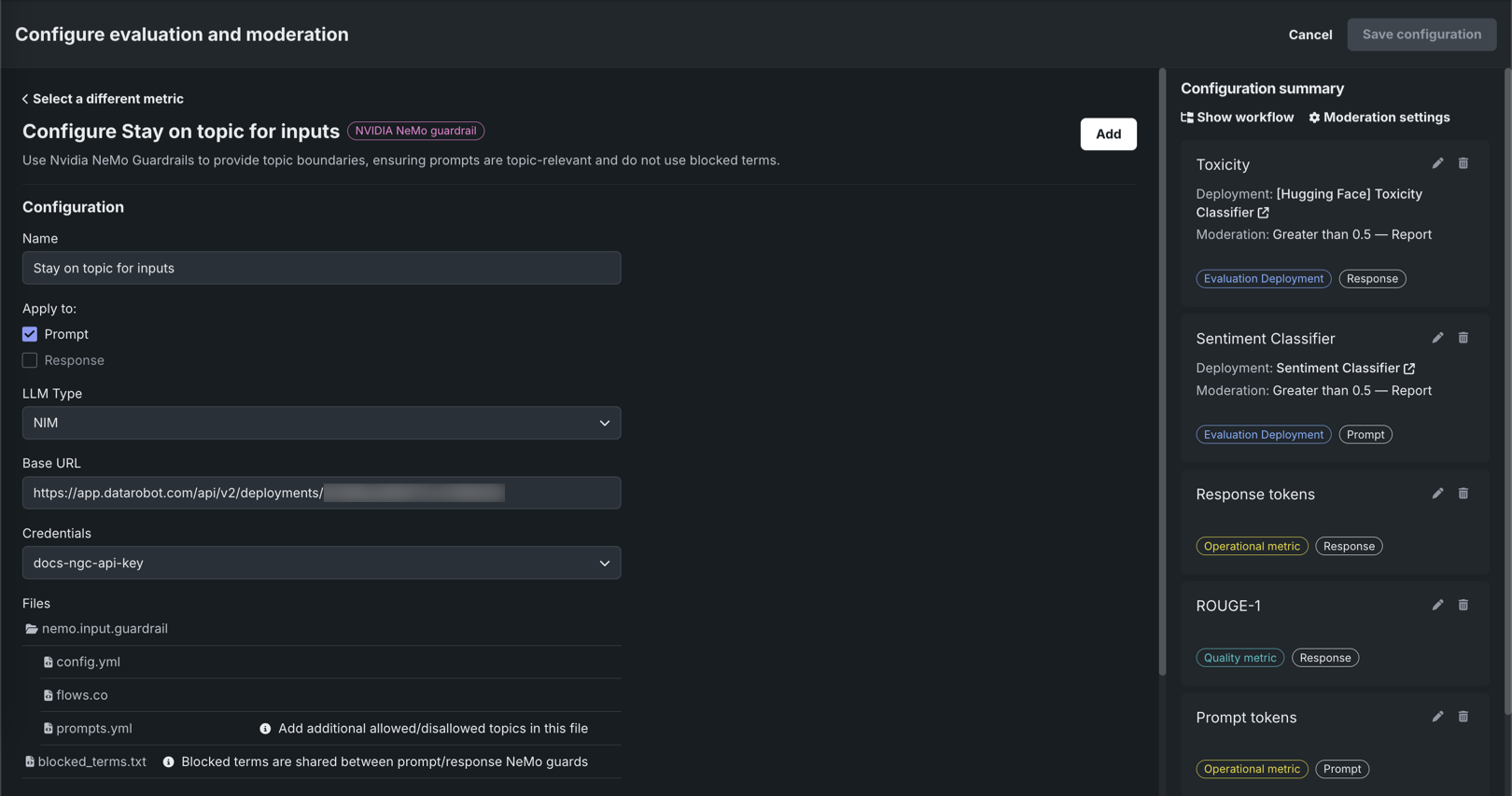

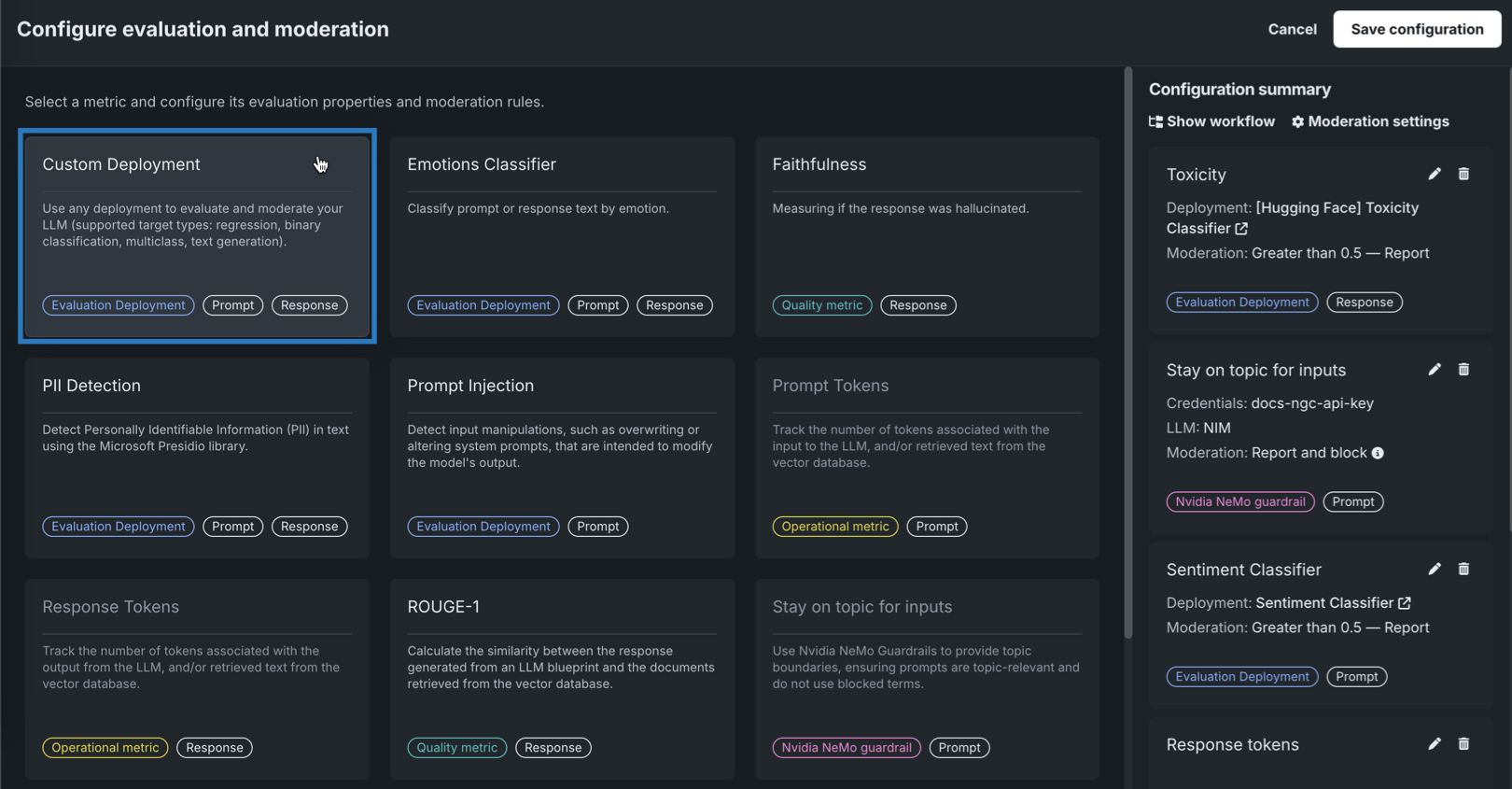

評価とモデレーションを設定パネルで、NVIDIA NeMo Guardrailsのタグが付いている指標を探し、入力のトピックを維持または出力のトピックを維持をクリックします。

評価指標 要件 説明 入力のトピックを維持 NVIDIA NeMoガードレールの設定 NVIDIA NeMo Guardrailsを使用してトピックの境界を設定することで、プロンプトがトピックに関連し、禁止用語を使用しないようにします。 出力のトピックを維持 NVIDIA NeMoガードレールの設定 NVIDIA NeMo Guardrailsを使用してトピックの境界を設定することで、回答がトピックに関連し、禁止用語を使用しないようにします。 -

入出力のトピックを維持指標の評価とモデレーションを設定ページのLLMタイプリストで、NIMを選択します。 次に、以下の設定を行います。

フィールド 説明 基本URL NVIDIA NIMデプロイのベースURLを入力します(例: https://app.datarobot.com/api/v2/deployments/<deploymentId>/)。資格情報 リストからDataRobot APIキーを選択します。 資格情報は、資格情報管理ページで定義されます。 ファイル (オプション)NeMoファイルを設定します。 ファイルの横にある をクリックして、NeMo Guardrailsの設定ファイルを変更します。 特に、 prompts.ymlを許可されたトピックとブロックされたトピックで、blocked_terms.txtをブロックされた用語で更新し、NeMoガードレールが実施するルールを提供します。blocked_terms.txtファイルは、入力と出力の_ トピックの維持 指標間で共有されるため、入力指標のblocked_terms.txtを変更すると出力指標でも変更され、その逆も同様です。 カスタムモデルには、1つは入力用、もう1つは出力用の2つのNeMo _トピックの維持 指標しか存在できません。 -

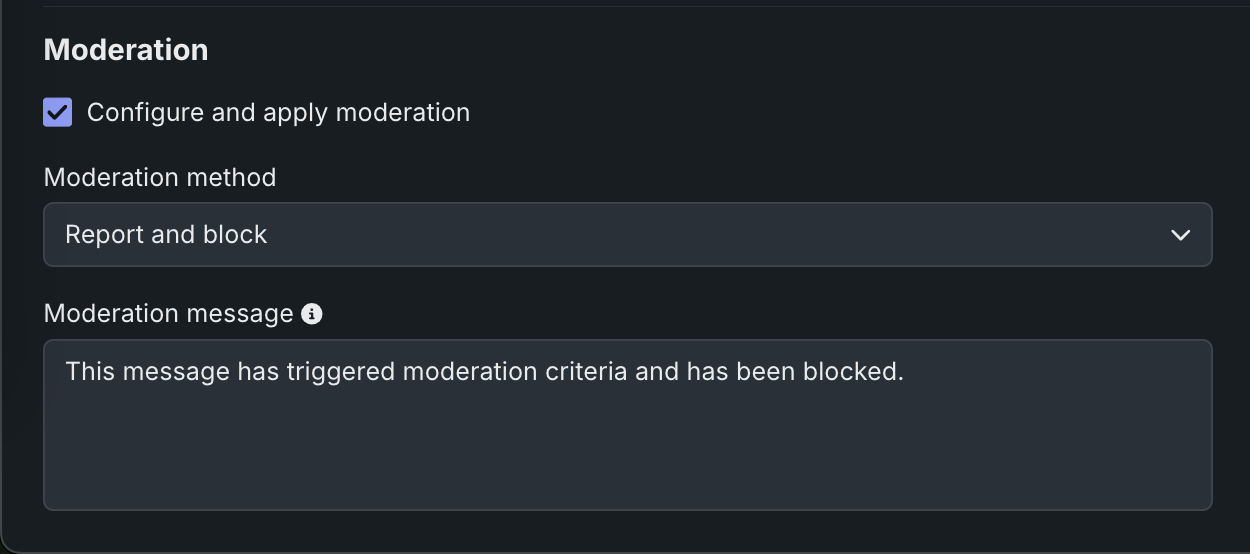

モデレーションセクションで、モデレーションの設定と適用を有効にして、評価指標ごとに以下を設定します。

フィールド 説明 モデレーション方法 レポートまたはレポートとブロックを選択します。 モデレーションのメッセージ レポートとブロックを選択すると、オプションでデフォルトのメッセージを変更できます。 -

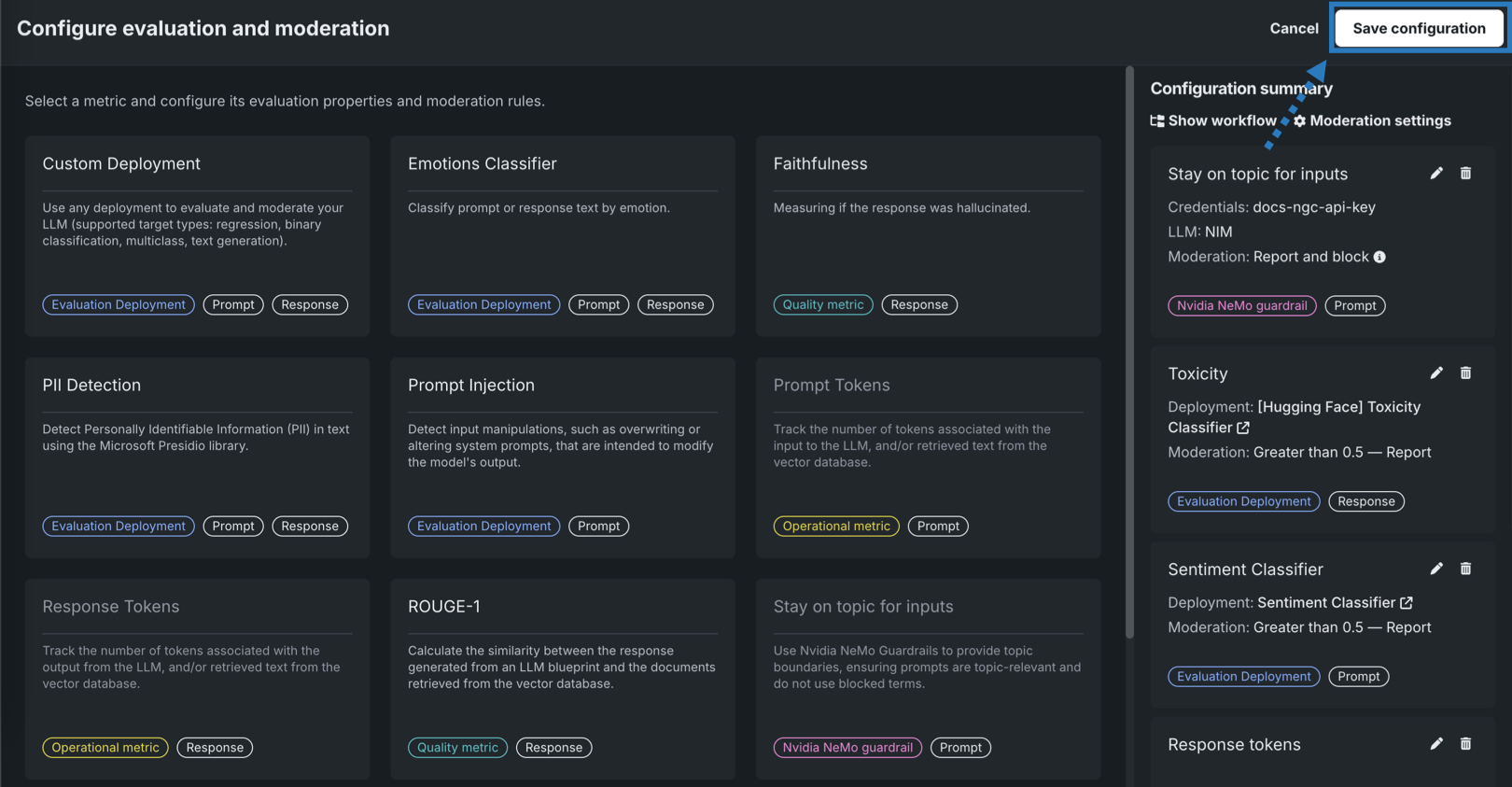

必須フィールドを設定した後、追加をクリックして評価を保存し、評価選択ページに戻ります。 次に、別の指標を選択して設定するか、設定を保存をクリックします。

選択したガードレールは、アセンブルタブの評価とモデレーションセクションに表示されます。

デプロイされたNIMをカスタムモデルのガードレールとして使用する¶

デプロイされたllama-3.1-nemoguard-8b-content-safetyまたはnemoguard-jailbreak-detect NVIDIA NIMをカスタムデプロイ評価指標で使用するには、まずNVIDIA NeMo Guardrailsを登録してデプロイしてから、ターゲットタイプがテキスト生成のカスタムモデルを作成するときに、カスタムデプロイ評価指標を設定します。

コンテンツの安全性とジェイルブレイクの検出のためにNVIDIA NeMo Guardrailsを選択して設定するには:

-

モデルワークショップで、テキスト生成ターゲットタイプを持つカスタムモデルのアセンブルタブを開き、 DataRobotの外部で作成したカスタムモデルから手動で、または ユースケースのLLMプレイグラウンドで作成されたモデルから自動的に モデルを構築します。

モデレーションを使ってテキスト生成モデルを構築する場合、必要なランタイムパラメーター(資格情報など)の設定やリソース設定(パブリックネットワークへのアクセスなど)を必ず行います。 最後に、基本環境をモデレーション対応の環境(たとえば[GenAI] Python 3.12 with Moderations)に設定します。

リソース設定

DataRobotでは、より多くのメモリーおよびCPUリソースを備えた、より大きなリソースバンドルを使用してLLMカスタムモデルを作成することをお勧めします。

-

カスタムモデルに必要な設定を行ったら、評価とモデレーションセクションに移動し、 設定をクリックします。

-

評価とモデレーションを設定パネルで、カスタムデプロイをクリックします。

-

カスタムデプロイの設定ページで、LLMに接続しているガードモデル(

llama-3.1-nemoguard-8b-content-safetyまたは`nemoguard-jailbreak-detect)に応じて、設定を行います。llama-3.1-nemoguard-8b-content-safetyでは、カスタムデプロイを以下のように設定します。フィールド 説明 名前 作成するカスタムデプロイ指標にわかりやすい名前を入力します。 デプロイ名 リストで、DataRobotに登録およびデプロイされているllama-3.1-nemoguard-8b-content-safetyモデルの名前を探し、デプロイ名をクリックします。 入力列名 入力列名としてtextと入力します。 出力列名 出力列名としてcontent_PREDICTIONと入力します。 nemoguard-jailbreak-detectでは、カスタムデプロイを以下のように設定します。フィールド 説明 名前 作成するカスタムデプロイ指標にわかりやすい名前を入力します。 デプロイ名 リストで、DataRobotに登録およびデプロイされているnemoguard-jailbreak-detectモデルの名前を探し、デプロイ名をクリックします。 入力列名 入力列名としてtextと入力します。 出力列名 出力列名としてjailbreak_True_PREDICTIONと入力します。 -

モデレーションセクションで、モデレーションの設定と適用を有効にして、評価指標ごとに以下を設定します。

フィールド 説明 モデレーション方法 レポートまたはレポートとブロックを選択します。 モデレーションのメッセージ レポートとブロックを選択すると、オプションでデフォルトのメッセージを変更できます。 -

必須フィールドを設定した後、追加をクリックして評価を保存し、評価選択ページに戻ります。

-

別の指標を選択して設定するか、設定を保存をクリックします。

選択したガードレールは、アセンブルタブの評価とモデレーションセクションに表示されます。

テキスト生成カスタムモデルにガードレールを追加した後、モデルを テスト、 登録、および デプロイして本番環境で予測を作成できます。 予測を作成した後、 カスタム指標 タブで評価指標を表示し、 データ探索タブでプロンプト、回答、およびフィードバック(設定されている場合)を表示できます。