DataRobotへの直接インポート¶

このセクションでは、DataRobotにデータをインポートする詳細なステップを説明します。 データをインポートする前に、DataRobotのデータガイドラインを確認して、ファイル形式やサイズを含むデータセットを理解します。

インポートのガイドライン¶

インポートする前に、AutoML、時系列、Visual Artificial Intelligence (AI)プロジェクトに関する以下のデータガイドラインを確認してください。

データセットの形式

データセットに数値以外のデータ(改行、復帰、二重引用符、カンマ、その他のフィールド区切り文字などの特殊文字も該当します)が含まれている場合は、データのインポート時に予期しない改行や誤ったフィールド分割が発生しないように、数値以外のデータのインスタンスを引用符(")で囲むようにしてください。 数値以外のデータを適切に引用することは、プレビュー機能「最小限のCSVクォーティングを有効にする」が有効な場合に特に重要です。

AutoMLプロジェクトの場合¶

- データはフラットファイルの表形式である必要があります。

- 予測しようとするターゲットを含む列が必要です。

時系列プロジェクトの場合¶

- データはフラットファイルの表形式である必要があります。

- 各行に 日付/時刻特徴量を含める必要があります。

- 時系列モデリングを使用する場合、DataRobotは、時間ステップ、つまり数値として測定される行間の差分、およびデータに含まれる差分時間の単位(15、分)を検出します。 データセットには、差分時間の単位ごとに行が必要です。 たとえば、7日先を予測する場合(時間ステップは7日)、データセットには日付範囲全体の各日の行が必要です。同様に、7年先まで予測するのであれば、データには日付範囲全体で毎年1つの行が必要です。

- 予測しようとしているターゲットを含む列が必要です。

Visual Artificial Intelligence (AI)プロジェクトの場合¶

- 各クラスの画像を含むフォルダーを設定し、そのクラスのフォルダーに名前を付けます。 そのフォルダーのZIPアーカイブを作成し、DataRobotにアップロードします。

- 上部フォルダー内に画像へのリンクが含まれている場合は、表形式データを追加することもできます。 詳細については、こちらをご覧ください。

プロジェクトの作成¶

モデルの構築を開始する前に、次のいずれかの方法で新規DataRobotプロジェクトを作成する必要があります。

- 画面左上にあるDataRobotロゴをクリックします。

- 右上にあるプロジェクトフォルダーを開き、新規プロジェクトの作成リンクをクリックします。

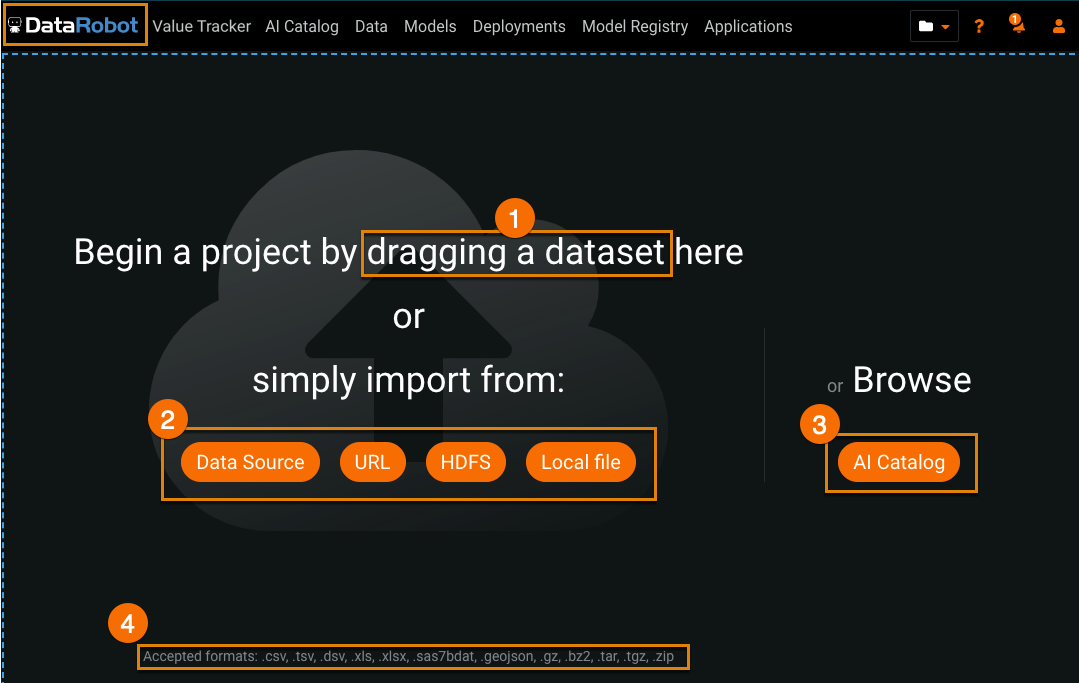

新規プロジェクトページが表示されたら、受け入れ可能なファイルタイプをページにインポートする方法を選択します。 (受け入れ可能なファイルタイプは画面の最下部に一覧表示されています。) 特定のアップロード方法がクラスターで無効化されている場合、対応する取込みボタンはグレー表示されます。

インポート方法¶

DataRobotにインポートするには、左上のDataRobotロゴをクリックして、プロジェクトを開始ページに移動します。 アカウントタイプに応じて、このページにアクセスする方法が他にもあります。

| インポート方法 | 説明 | |

|---|---|---|

| 1 | ドラッグアンドドロップ | ファイルをコンピューターからプロジェクトを開始ページにドラッグアンドドロップします。 |

| 2 | インポート元 | インポート方法を選択します。 |

| 3 | 参照 | AIカタログを参照します。 AIカタログを通じて、データのインポート、保存、ブレンド、共有が可能です。 |

| 4 | ファイルタイプ | インポート可能な形式を表示します。 詳細については、 データセットの要件を参照してください。 |

各インポート方法を次の表に示します。

| 方法 | 説明 |

|---|---|

| 既存のデータソースの使用 | 設定されたデータソースからインポートします。 |

| URLからのデータセットのインポート | データをインポートするURLを指定します。 |

| ローカルファイルのインポート | ローカルファイルを参照してインポートします。 |

| S3からのファイルのインポート | AWS S3バケットからアップロードします。 |

| Google Cloud Storageからのファイルのインポート | Google Cloudから直接インポートします。 |

| Azure Blob Storageからのファイルのインポート | Azure Blobから直接インポートします。 |

備考

クラスターでは特定のアップロード方法を無効にすることができます。無効になった方法に関するボタンが表示されない場合があります。 設定されたインポート方法については、システム管理者にお問い合わせください。

インポート方法によっては、以下のセクションで説明するように、使用前に管理者による設定が必要な場合があります。

より大きなデータセットの場合、DataRobotは、データを事前に表示し、プロジェクトオプションを選択できる特殊な処理を提供します。

ローカルファイルをアップロード¶

本機能の提供について

マネージドAIプラットフォームユーザーは、ローカルにマウントされたファイルをDataRobotに直接ロードできる機能を使用できません。

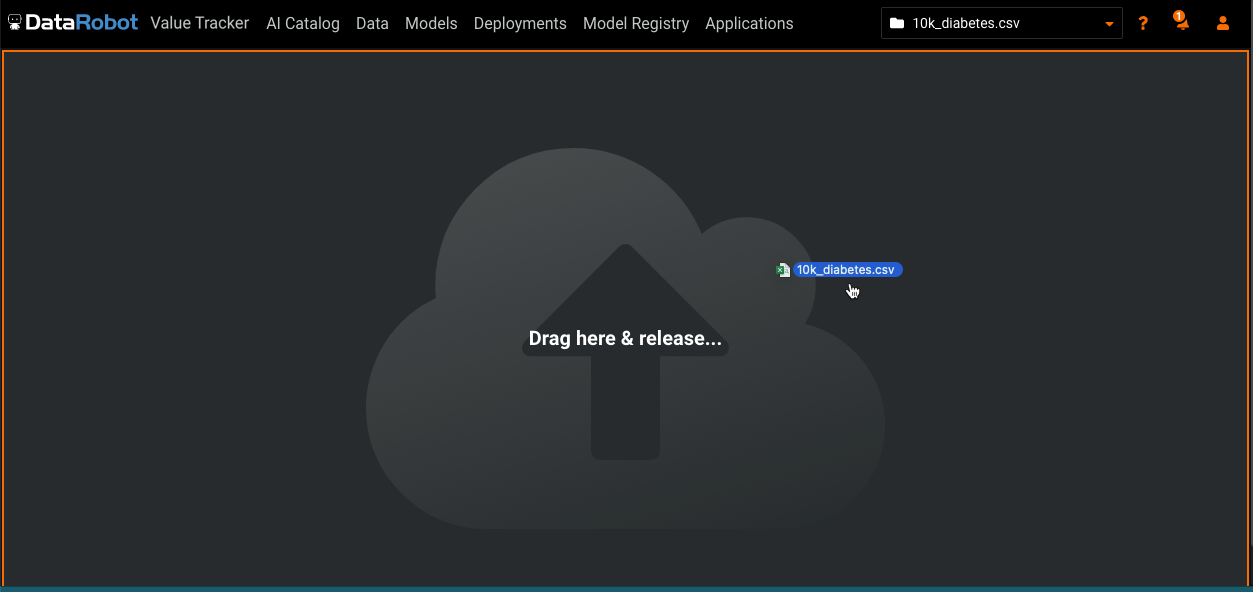

ローカルファイルをクリックしてファイルを参照するか、プロジェクトを開始ページにファイルを直接ドラッグします。 URLリンクをfile:///local/file/locationとして指定することもできます。

DataRobotは、クラスターに接続されたネットワークストレージドライブからファイルを取り込み、プロジェクトを作成します。 このインポート方法は、組織のインストールに合わせて設定する必要があります。

備考

(100MBを超える)サイズの大きいファイルをドロップする場合は、アップロードプロセスがハングする可能性があります。 その場合、以下のように対応してください。

- もう一度試す。

- サポートされている形式にファイルを圧縮して、再試行する。

- ファイルをリモートデータストア(S3など)に保存して、サイズの大きいファイルでの安定性が高いURL取込みを使用する。

- セキュリティの懸念がある場合、一時的に署名されたS3 URLを使用します。

URLからインポート¶

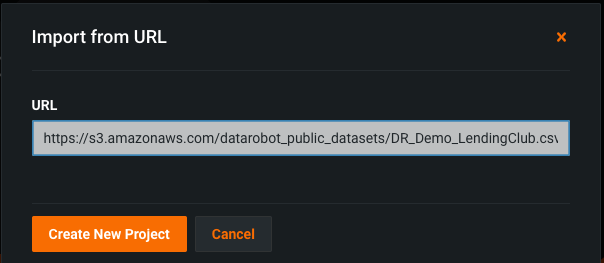

URLを使用してデータをインポートします。 これは、ローカル、HTTP、HTTPS、Google Cloud Storage、Azure Blob Storage、またはS3です(URLには、HTTPを使用する必要があります)。

-

URLをクリックします。

-

データのURLを入力して、新しいプロジェクトを作成をクリックします。 これは、ローカル、HTTP、HTTPS、Google Cloud Storage、Azure Blob Storage、またはS3です。

DataRobotがデータをインポートし、プロジェクトを作成します。

備考

URLを使用してGoogle Cloud、Azure Blob Storage、またはS3からインポートする機能を、組織のインストールに合わせて設定する必要があります。 設定されたインポート方法については、システム管理者にお問い合わせください。

データソースからのインポート¶

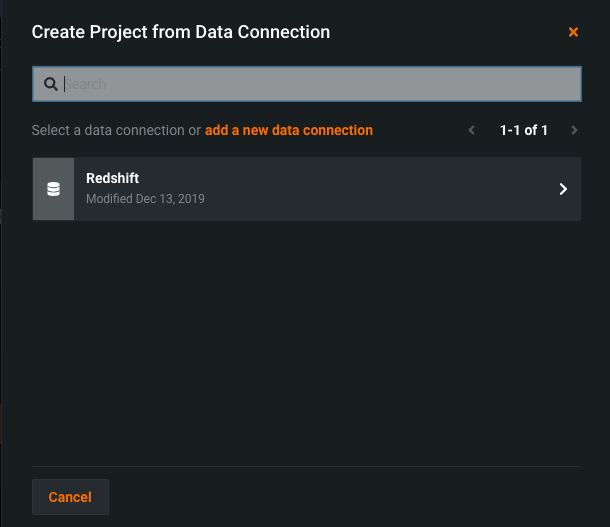

データソースからインポートする前に、外部データベースへの JBDC接続を設定します。

備考

DataRobotがデータソースオプションから取り込む場合、プロジェクトで使用する選択したデータベース行のコピーを作成します。

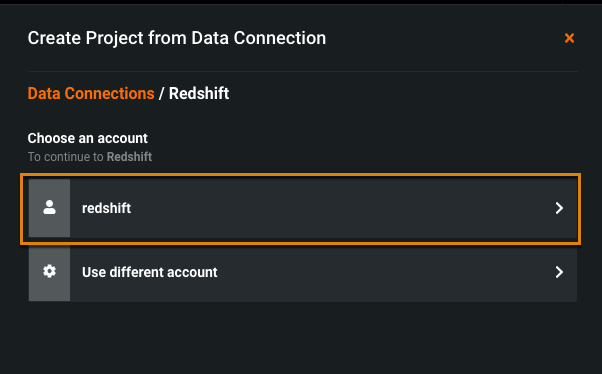

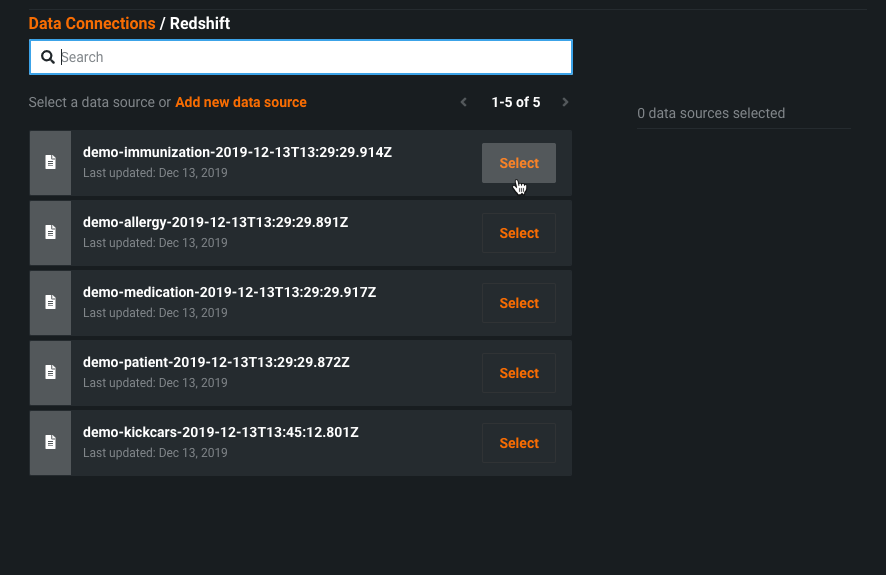

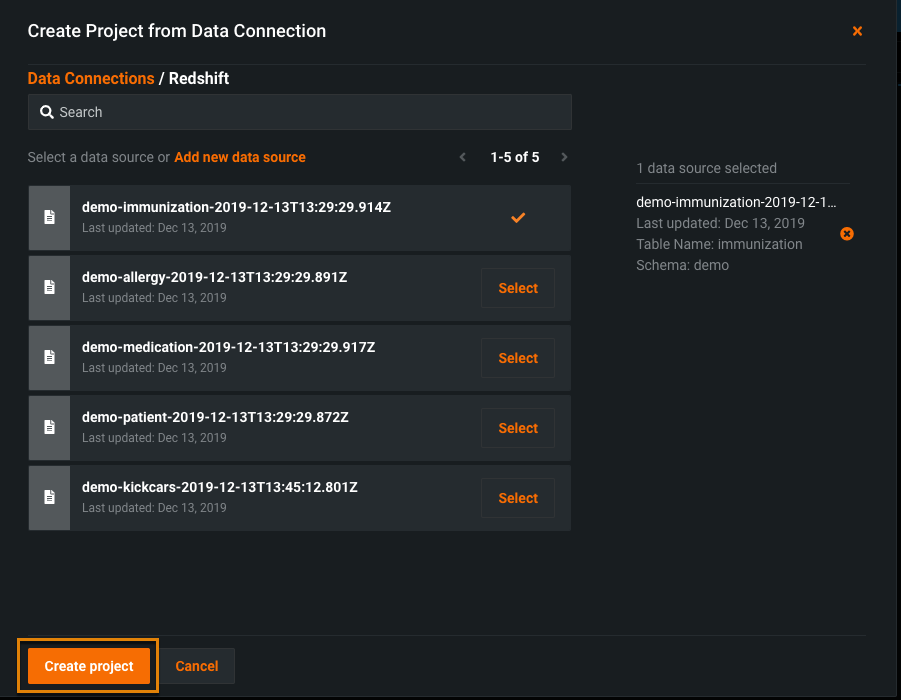

既存のデータソースからインポートするには:

-

データソースをクリックします。

-

データソースを検索して選択します。

新しいデータ接続を追加することもできます。

-

アカウントを選択します。

-

接続するデータを選択します。

-

クリックしてプロジェクトを作成します。

DataRobotはデータに接続し、プロジェクトを作成します。

S3からのファイルのインポート¶

このインポート方法が設定されたセルフマネージドAIプラットフォームインストールでは、S3へのリンクを(たとえばhttps://s3.amazonaws.com/bucket/file?AWSAccessKeyId...ではなく)s3://<bucket-name>/<file-name.csv>として指定することにより、URLを介してS3ファイルを取り込むことができます。 オブジェクトおよび区分けをパブリックに設定せずにS3からファイルを取込むことができます。

備考

この方法は、マネージドAIプラットフォームユーザーでは使用できません。 代わりに、次のいずれかの方法を使用してS3ファイルをインポートしてください。

- Amazon S3データ接続の使用。

- 認証付きのS3バケットへのパブリックアクセスを許可する事前署名済みURLを生成すると、直接URLを使用してデータセットの取込みができます。

Google Cloud Storageからのファイルのインポート¶

gs://<bucket-name>/<file-name.csv>のリンクを直接使用して Google Cloud Storageに格納されているファイルを直接インポートするようDataRobotを設定できます。 このインポート方法は、組織のインストールに合わせて設定する必要があります。

備考

gs://<bucket-name>/<file-name.csv>のリンクを使用してファイルをインポートする機能は、マネージドAIプラットフォームユーザーでは使用できません。

Azure Blob Storageからのファイルのインポート¶

azure_blob://<container-name>/<file-name.csv>のリンクを使用して、Azure Blob Storageに保存されているファイルを直接インポートすることができます。 このインポート方法は、組織のインストールに合わせて設定する必要があります。

備考

azure_blob://<container-name>/<file-name.csv>のリンクを使用してファイルをインポートする機能は、マネージドAIプラットフォームユーザーでは使用できません。

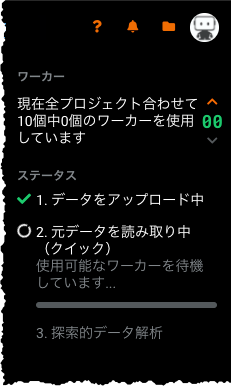

プロジェクトの作成と分析¶

データソースを選択してデータをインポートした後、DataRobotは新しいプロジェクトを作成します。 最初の探索的データ解析ステップは、EDA1と呼ばれます。 (DataRobotでの大規模データセットの処理方法については、「高速EDA」に関するセクションを参照してください。)

進捗メッセージが表示され、ファイルの処理状況が示されます。

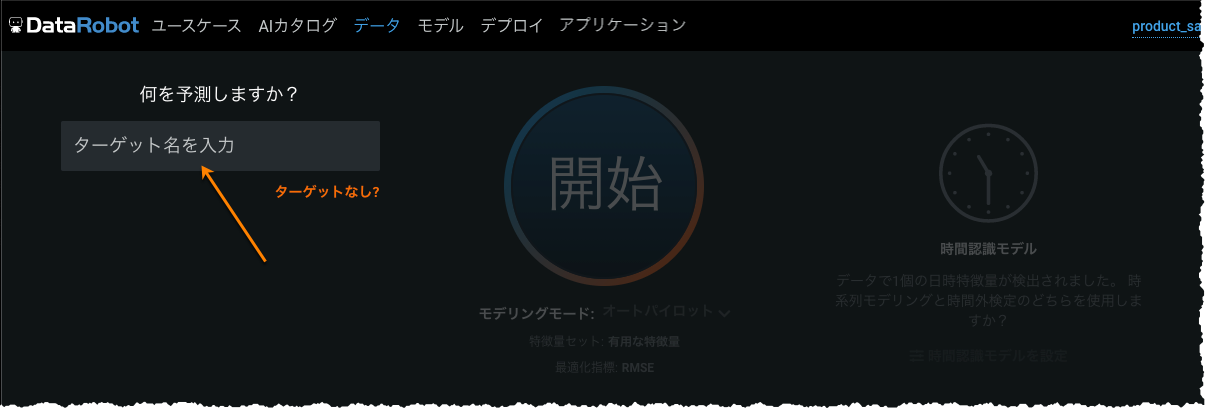

EDA1が完了すると、開始画面が表示されます。 ここから下にスクロールするか、参照リンクをクリックしてデータサマリーを表示します。 予測に使用するターゲット特徴量を指定することもできます。

データセクションでは、以下の操作を行うことができます。

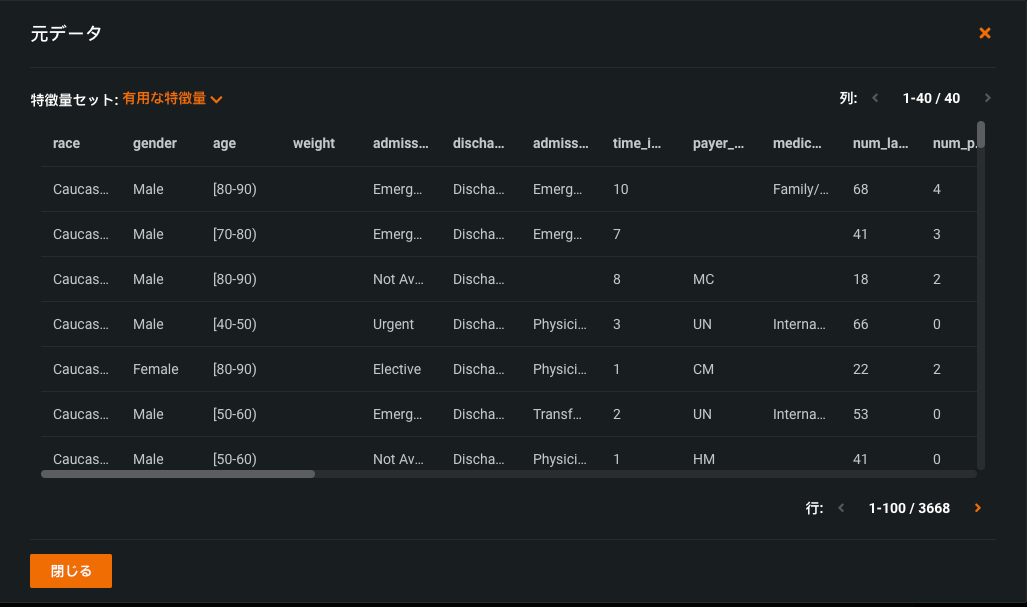

-

元データを見るをクリック(1)すると、DataRobotがモデル構築に使用する元のデータテーブルの最大1MBのランダムサンプルを表すモーダルが表示されます。

-

データ表示内の特徴量名の上にカーソルを置いてターゲットを設定(2)します。

-

特徴量セットを操作(3)します。

各特徴量のヒストグラムを表示することもできます。 ヒストグラムは、特徴量とそのデータセットとの関係性を理解するのに役立つように、 表示を変更するためのオプションがいくつか用意されています。

次のステップでターゲット特徴量を設定してモデルの構築を開始すると、多くの情報が利用可能になります。