カスタムモデルのデプロイ¶

カスタムモデルワークショップを使用して、カスタム推論モデルを作成すると、カスタムモデル環境にデプロイできます。

備考

テストをしないでカスタム推論モデルを環境にデプロイすることもできますが、DataRobotでは、デプロイの前にテストに合格をすることが強く推奨されます。

カスタムモデルの登録とデプロイ¶

登録されていないカスタムモデルをデプロイするには:

-

モデルレジストリ > カスタムモデルワークショップ > モデルに移動し、デプロイするモデルを選択します。

-

アセンブルタブで、ページの中央にある登録してデプロイをクリックします。

備考

モデルによる予測が可能であることをテストしてから、デプロイすることをお勧めします。

-

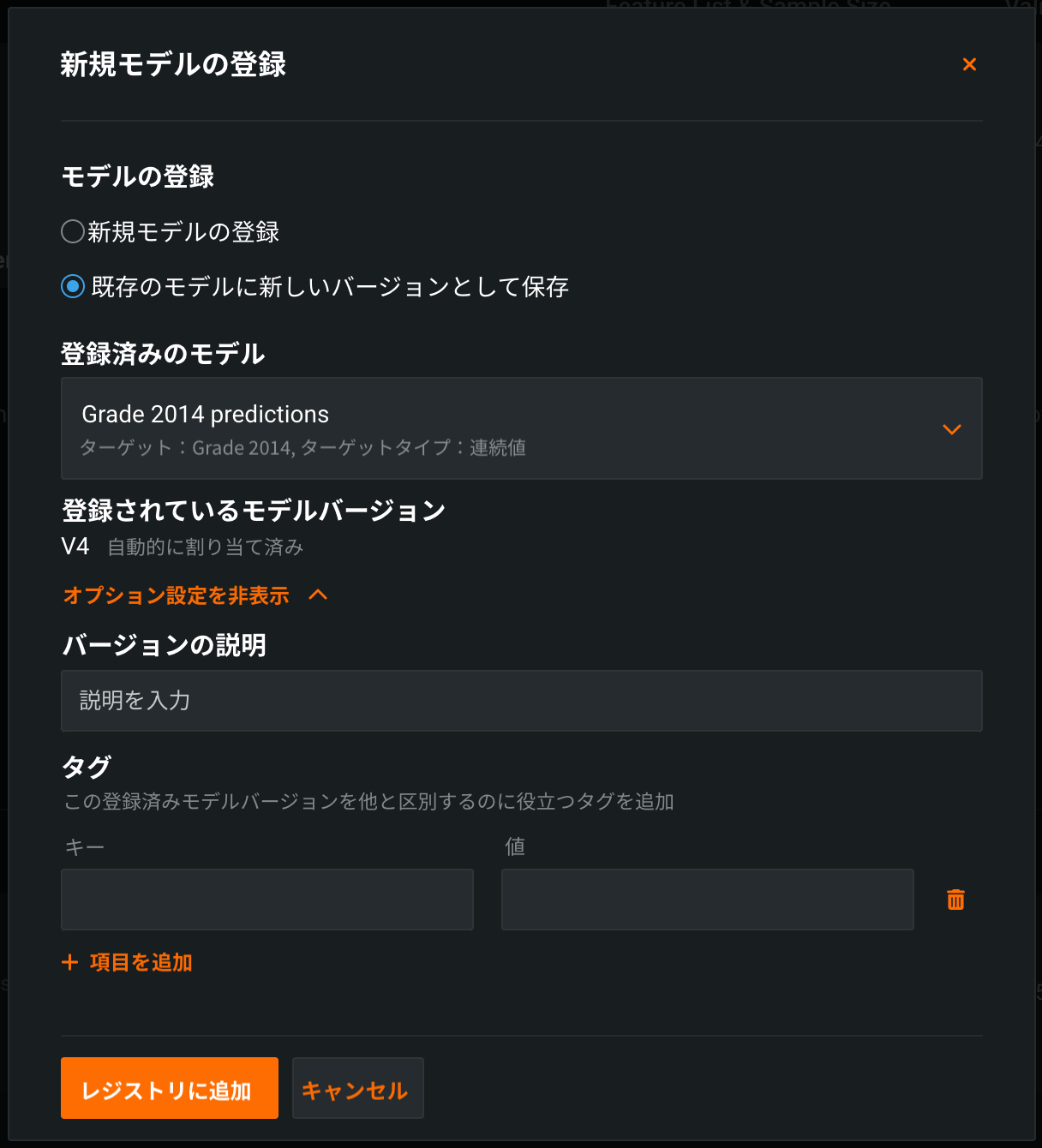

新規モデルの登録ダイアログボックスで、以下の設定を行います。

フィールド 説明 モデルの登録 次のいずれかを選択: - 新規モデルの登録:登録済みのモデルを新規作成します。 これにより、最初のバージョン(V1)が作成されます。

- 既存のモデルに新しいバージョンとして保存:既存の登録済みモデルのバージョンを作成します。 これにより、バージョン番号が増加し、登録済みモデルに新規バージョンが追加されます。

登録モデルの名前/登録済みのモデル 次のいずれかを実行します。 - 登録済みモデル名:新しい登録モデルに一意でわかりやすい名前を入力します。 組織内のどこかに存在する名前を選択すると、モデルの登録に失敗したという警告が表示されます。

- 登録済みのモデル:新規バージョンを追加する既存の登録済みモデルを選択します。

登録モデルのバージョン 自動的に割り当て済み。 作成するバージョンの予想バージョン番号(V1, V2, V3など)が表示されます。 新しいモデルを登録を選択すると、これは常にV1になります。 オプション設定 バージョンの説明 これらのモデルパッケージが解決するビジネス上の問題、またはより一般的には、それらの関係性を説明します。 タグ + 項目を追加をクリックし、モデルバージョンにタグ付けする各キーと値のペアのキーと値を入力します。 タグは登録済みモデルには適用されず、その中のバージョンにのみ適用されます。 新規モデルの登録時に追加されたタグがV1に適用されます。 -

レジストリに追加をクリックします。 モデルレジストリ > 登録済みのモデルタブでモデルが開きます。

-

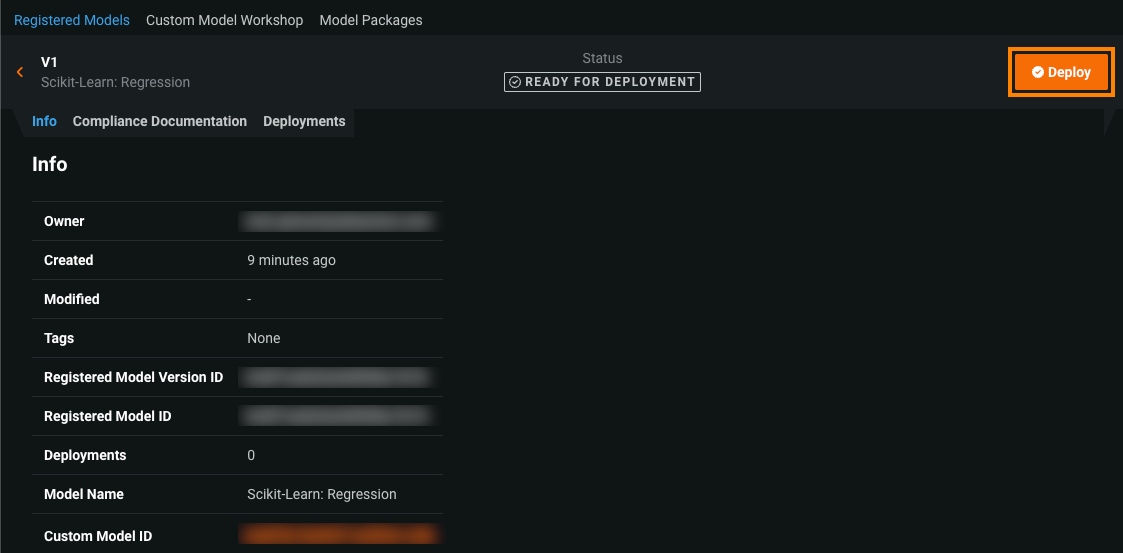

登録されているモデルバージョンヘッダーで、デプロイをクリックし、 デプロイ設定を行います。

カスタムモデルのほとんどの情報は自動的に指定されます。

-

モデルをデプロイをクリックします。

登録済みのカスタムモデルをデプロイ¶

登録済みのカスタムモデルをデプロイするには:

-

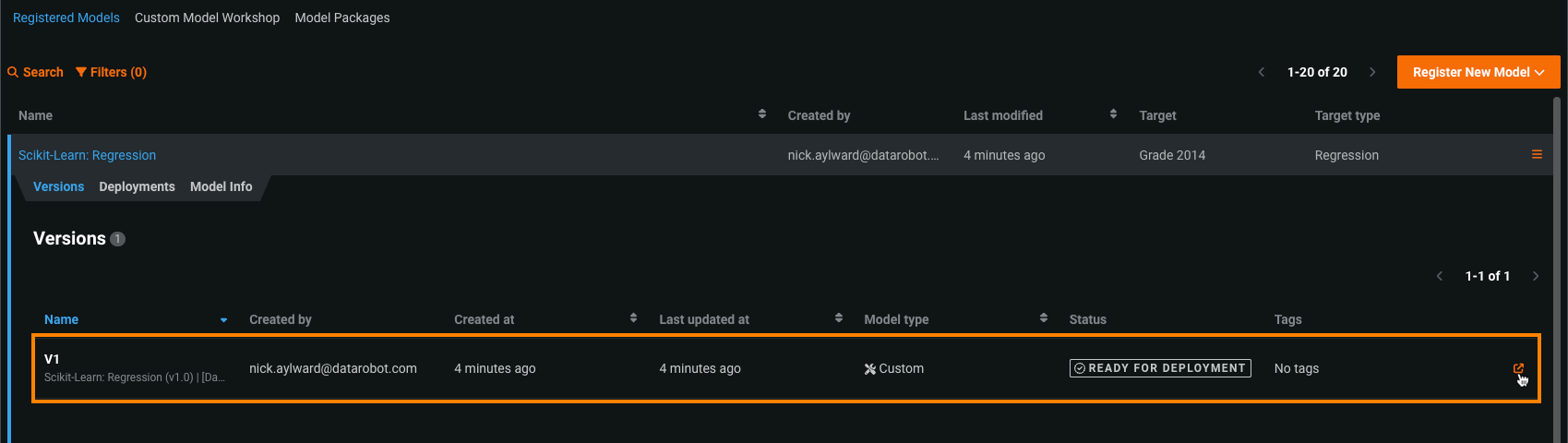

登録済みのモデルページで、デプロイするモデルバージョンを含む登録済みモデルをクリックします。

-

登録済みのモデルバージョンを開くには、次のいずれかを実行します。

-

バージョンヘッダーで、デプロイをクリックし、 デプロイ設定を行います。

-

モデルをデプロイをクリックします。

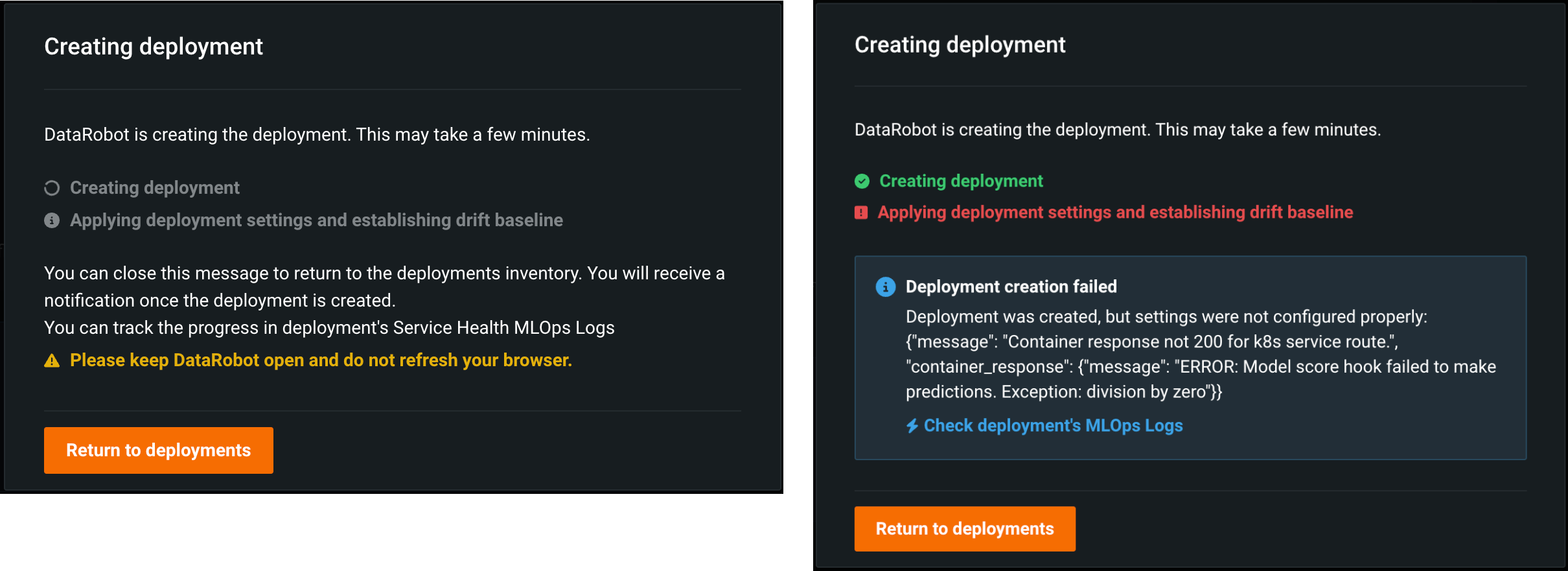

デプロイを作成していますモーダルが表示され、デプロイ設定の適用やドリフトベースラインの計算など、デプロイ作成プロセスのステータスを追跡します。 デプロイに戻ることも、モーダルからデプロイの進捗を監視することもでき、エラーが発生した場合はデプロイのMLOpsログをチェックするリンクにアクセスできます。

予測の作成¶

カスタム推論モデルをデプロイしたら、DataRobotによって管理されている専用の予測サーバーへのAPI呼び出しを使用して予測できます。 予測APIの使用の詳細については、予測のドキュメントを参照してください。

トレーニングデータセットに関する注意事項

デプロイされたモデルを使用して予測を行う場合、予測データセットは次のように処理されます。

-

トレーニングデータが_ない_ 場合、ターゲット特徴量のみが予測データセットから削除されます。

-

トレーニングデータが_ある_ 場合、トレーニングデータセットに含まれない特徴量が予測データセットから削除されます。

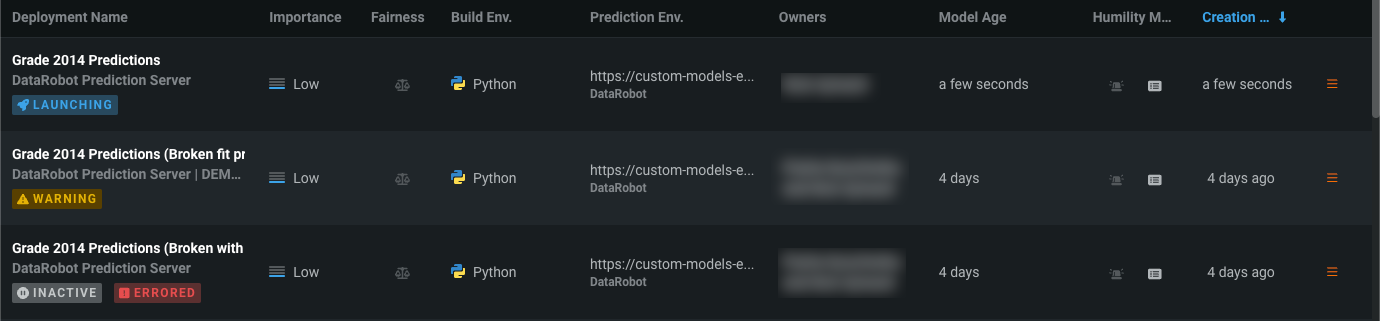

デプロイステータス¶

DataRobotがカスタムモデルをデプロイすると、デプロイインベントリのデプロイ名の下と、デプロイ内のタブに 起動中バッジが表示されます。 カスタムモデルのデプロイには、以下のデプロイステータス値があります。

| ステータス | バッジ |

|---|---|

|

カスタムモデルのデプロイプロセスは、まだ処理中です。 現在、このデプロイを使用して予測を行ったり、アクティブなデプロイを必要とするデプロイタブにアクセスしたりすることはできません。 |

|

カスタムモデルのデプロイプロセスは、エラーで完了しました。 このデプロイでは予測を行うことができないかもしれません。ただし、このデプロイを非アクティブ化した場合、デプロイエラーを解決するまで再アクティブ化できません。 MLOpsログを確認して、カスタムモデルデプロイのトラブルシューティングを行う必要があります。 |

|

カスタムモデルのデプロイプロセスは失敗し、デプロイは非アクティブです。 現在、このデプロイを使用して予測を行ったり、アクティブなデプロイを必要とするデプロイタブにアクセスしたりすることはできません。 MLOpsログを確認して、カスタムモデルデプロイのトラブルシューティングを行う必要があります。 |

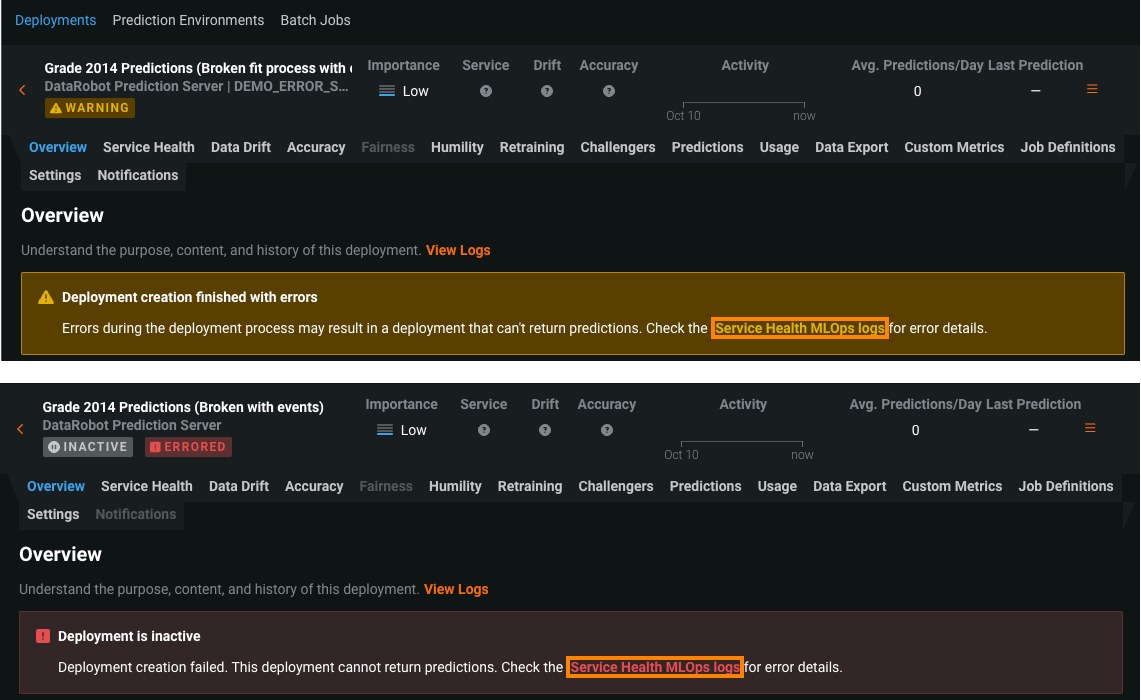

エラー発生または警告ステータスのデプロイでは、どのタブでもその警告から、サービスの正常性に関するMLOpsログのリンクにアクセスできます。 このリンクをクリックすると、サービスの正常性タブに直接移動します。

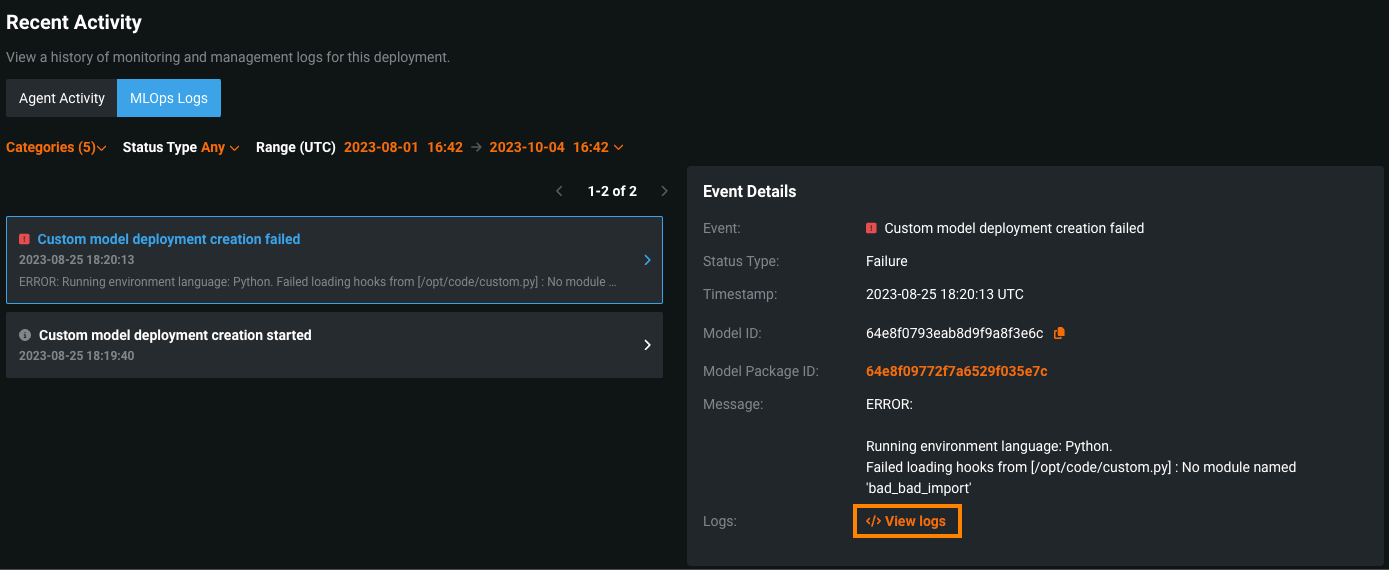

サービスの正常性タブの最近のアクティビティで、MLOpsログタブをクリックすると、イベントの詳細を表示できます。 イベントの詳細では、 "ログを表示"をクリックしてカスタムモデルのデプロイログにアクセスすることで、エラーの原因を診断できます。

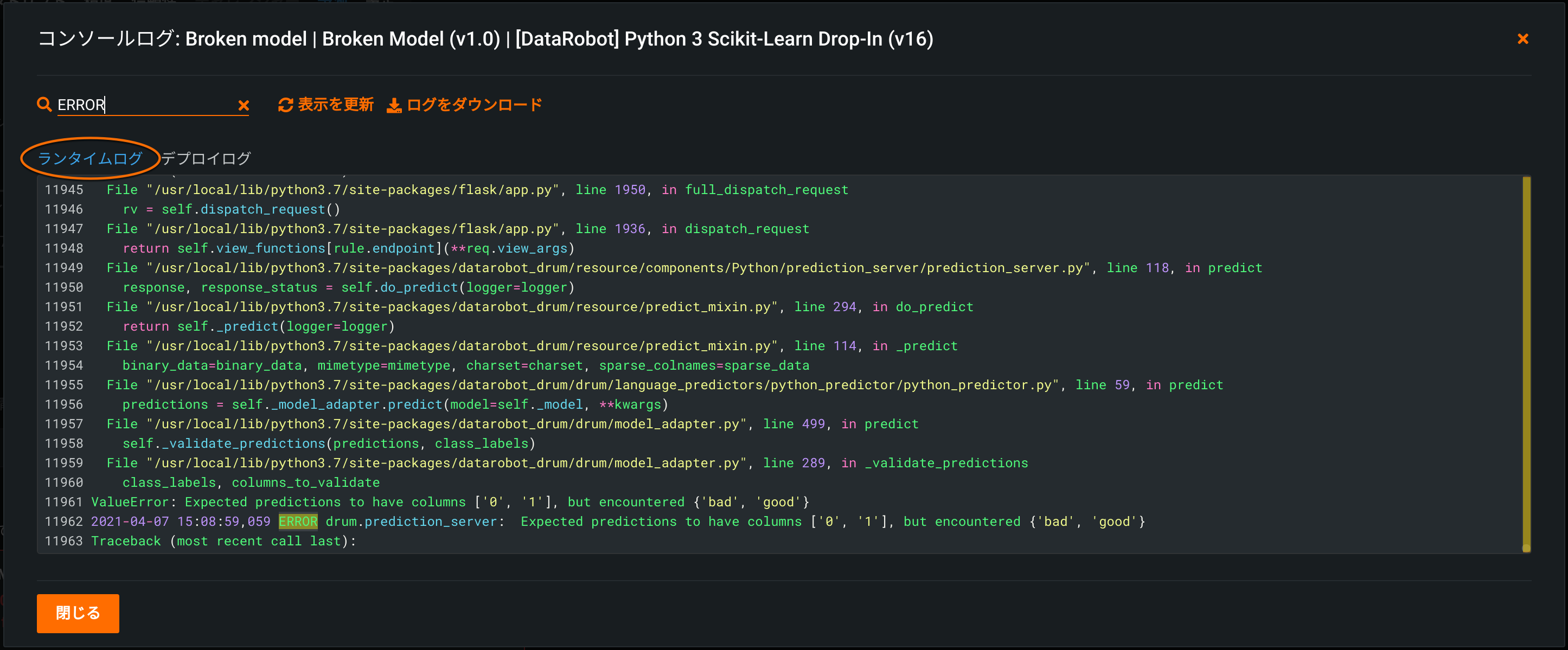

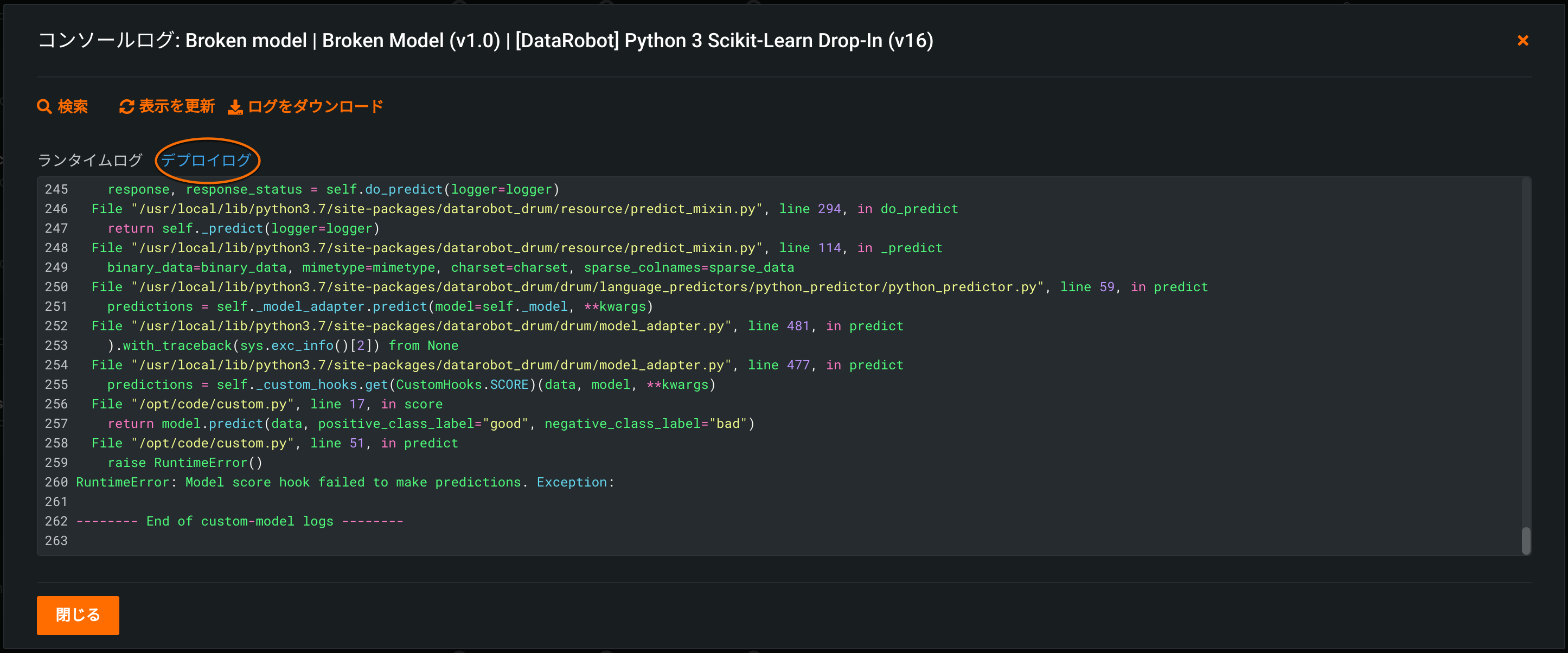

デプロイログ¶

カスタムモデルをデプロイすると、このタイプのデプロイに一意のログレポートが生成されるため、DataRobot内からカスタムコードをデバッグし、予測リクエストの失敗のトラブルシューティングを行うことができます。

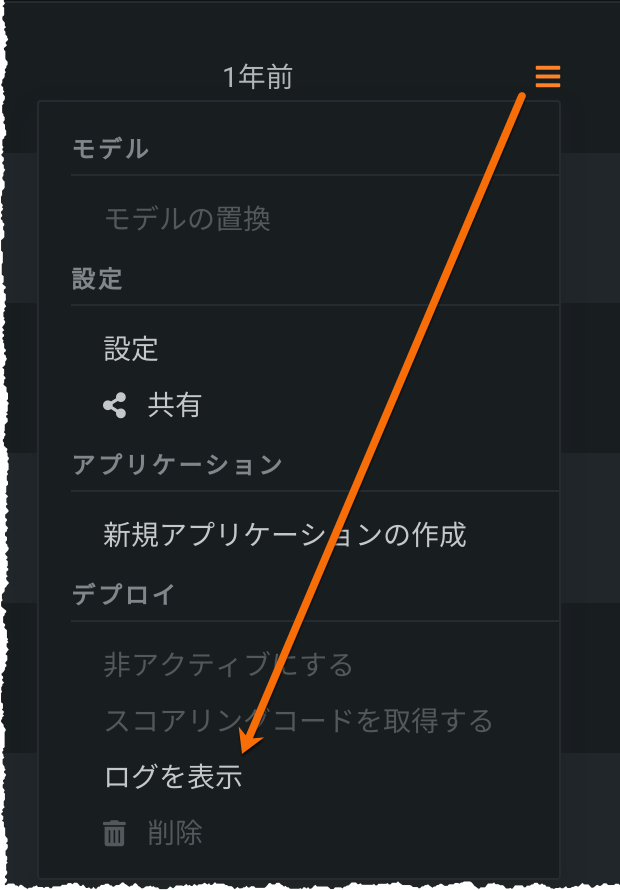

デプロイされたモデルのログを表示するには、デプロイに移動し、アクションメニュー を開いて、ログを表示を選択します。

次の2種類のログにアクセスできます。

-

ランタイムログは失敗した予測リクエストのトラブルシューティングに使用できます(予測タブまたはAPIからアクセス)。 ログは、デプロイされたカスタムモデルを実行しているDockerコンテナからキャプチャされ、最大1MBのデータが含まれます。 予測リクエストを行った後、ログは5分間キャッシュされます。 更新をクリックすると、ログを再リクエストできます。

-

デプロイログは、デプロイ中にカスタムモデルが失敗した場合に自動的に出力されます。 ログは、デプロイの一部として恒久的に保存されます。

備考

DataRobotは、カスタムモデルが実行されるDockerコンテナ内からのログのみを提供します。 したがって、カスタムモデルのデプロイに失敗した場合や、予測リクエストの実行に失敗した場合、ログが利用できなくなることがあります。 この理由は、Dockerコンテナの外部で障害が発生したためです。

検索バーを使用して、ログ内の特定の参照を検索できます。 ログをダウンロードをクリックすると、ログのローカルコピーを保存できます。