時系列のデータ準備¶

時系列プロジェクトを開始するとき、データ品質検出は時間ステップが不規則かどうかを評価します。 これにより、一部の系列で大きなギャップが生じることがあり、その場合は、精度を向上させることができる季節差や交差系列特徴量が使用できなくなります。 これらのギャップが引き起こす可能性のある不正確なローリング統計を回避するには、次のことができます。

- DataRobotに行ベースのパーティショニングを使用させます。

- 期間ベースのパーティショニングを使用して、時系列データ準備ツールとのギャップを修正します。

一般的に、データ準備ツールは最初にデータセットを選択された時間ステップに集計し、まだ行が欠落している場合は、ターゲット値を補完します。 これにより、数値、カテゴリー値、およびテキスト値の集計方法を選択できます。 また、これを使用して、さまざまな時間スケールでモデリングを調べることもできます。 結果として得られたデータセットは、AIカタログにパブリッシュされます。

データ準備ツールにアクセスする¶

データ準備ツールは、プロジェクトの開始画面、またはAIカタログから直接アクセスできます。

AIカタログのデータセットを変更する方法は、開始画面から開始したか、カタログから開始したかに関係なく同じです。

プロジェクトからデータ準備にアクセスする¶

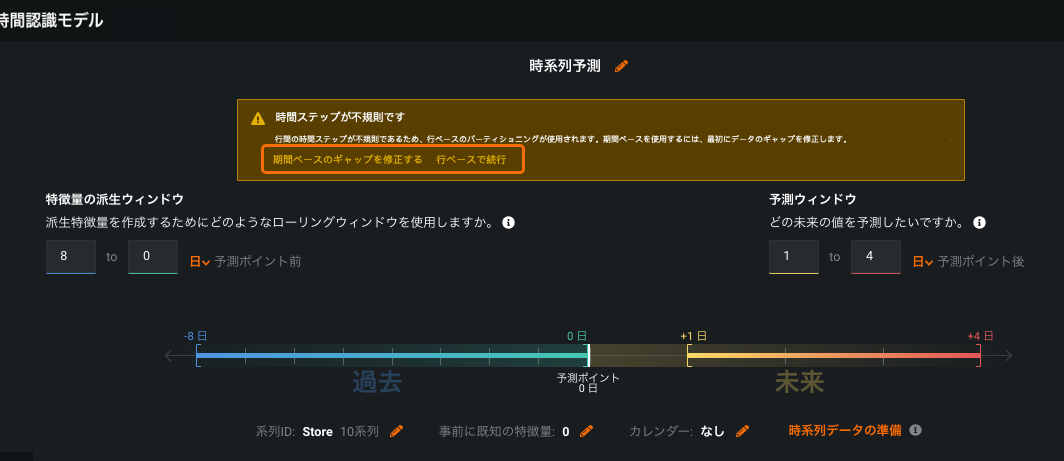

開始画面から、初期設定(ターゲット、日付/時刻特徴量、予測またはナウキャスト、系列ID(該当する場合))の後、データ準備ツールが利用可能になります。 期間ベースのギャップを修正するをクリックすると、時間ステップが不規則であることが検出された場合にツールを利用できます。

または、時間ステップが定期的であっても、それを使用してデータセットのカスタマイズを適用します。

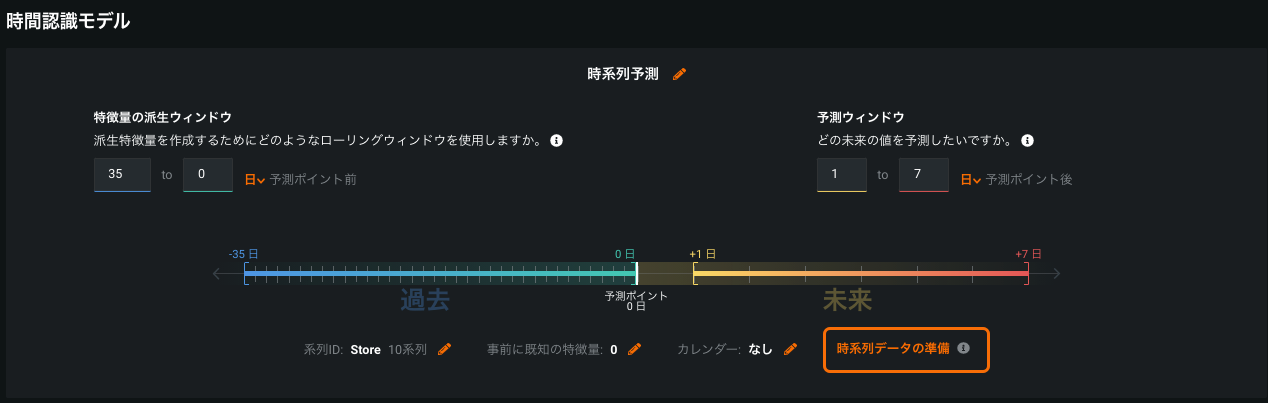

時系列データ準備をクリックします。

注意

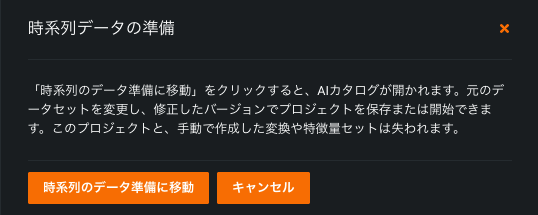

プロジェクトから時系列データ準備ツールにアクセスすると、現在のプロジェクトと、プロジェクト内で手動で作成された特徴量の変換または特徴量セットが失われることを注意するメッセージが表示されます。

時系列データ準備へ移動をクリックして、AIカタログのデータセットを開いて変更します。 キャンセルをクリックして、現在のプロジェクトで作業を継続します。

AIカタログからデータ準備にアクセスする¶

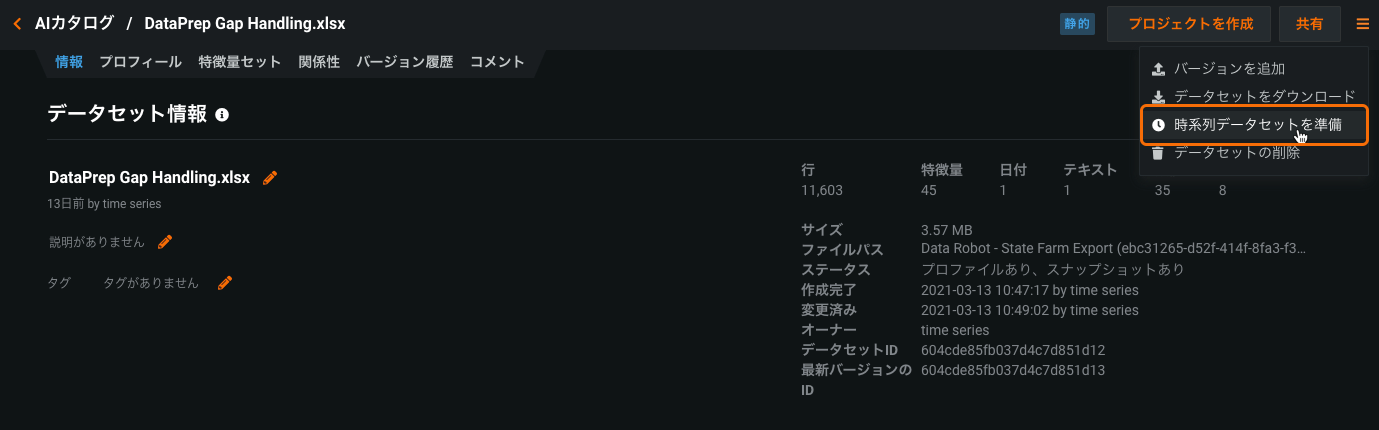

AIカタログで、インベントリからデータセットを開き、メニューから時系列データセットを準備を選択します。

時系列データセットを準備オプションをAIカタログのデータセットで有効にするには、それを変更する権限が必要です。 さらに、データセットは次の条件を満たしている必要があります。

- 静的またはSparkのステータスがあること。

- 1つ以上の日付/時刻特徴量があること。

- 1つ以上の数値特徴量があること。

データセットの変更¶

時系列データ準備ツールを使用してデータセットを変更するには、次のメカニズムを使用します。

- ドロップダウンとセレクターを使用して、手動オプションを設定し、集計と補完の方法を設定するコードを生成します。

- (オプション)手動設定から生成されたSpark SQLクエリーを変更します。 (その代わりに、空白のSpark SQLクエリーからデータセットを作成するには、AIカタログのSpark SQLでのデータ準備機能を使用します。)

手動オプションの設定¶

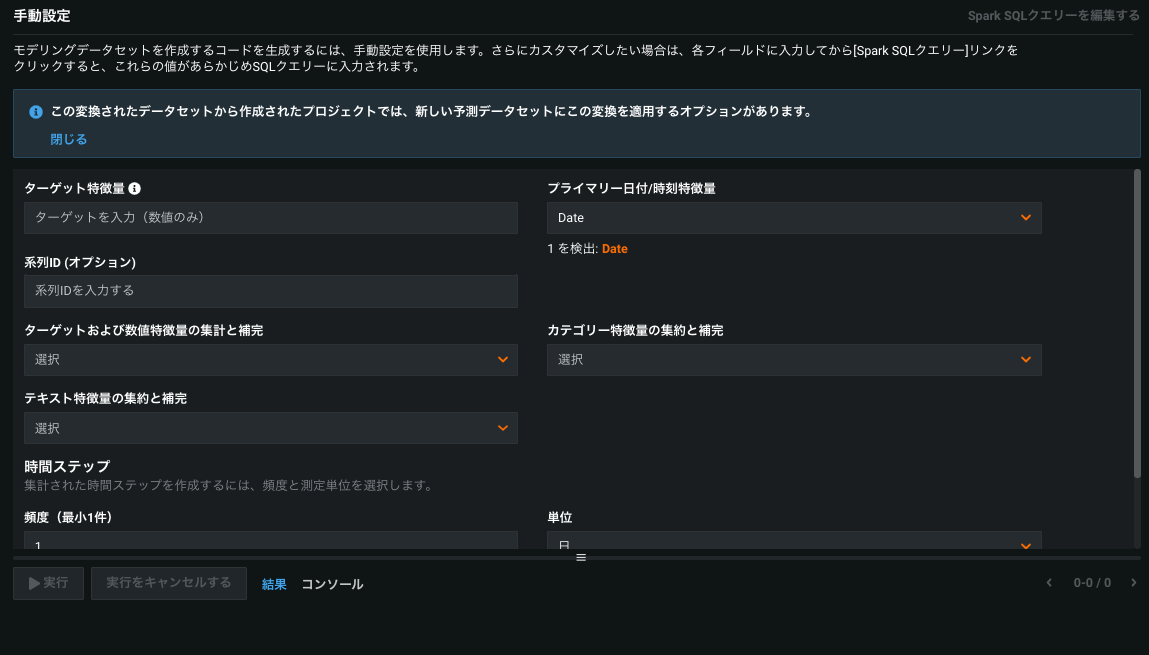

時系列データ準備を開くと、手動設定ページが表示されます。

フィールドに入力します。これらのフィールドはDataRobotが計算する補完と集計の基準として使用されます。 必須フィールドのすべてに入力するまで、クエリーを保存することも、Spark SQLを編集することもできません。 (以下の補完に関する追加情報を参照してください。)

| フィールド | 説明 | 必須 |

|---|---|---|

| ターゲット特徴量 | 予測するデータセットの数値列。 | はい |

| プライマリー日付/時刻特徴量 | パーティショニングの基準として使用する時間型特徴量。 ドロップダウンを使用するか、特定された特徴量から選択します。 | はい |

| 系列ID | DataRobotがデータセットを個別の時系列として処理できるようにする系列識別子を含む列。 | いいえ |

| 系列開始日(系列IDが設定された場合のみ利用可能) | 系列の開始日の基準。各系列の最も早い日付(系列ごと)または任意の系列で見つかった最も早い日付(グローバル)。 | デフォルトは系列ごと |

| 系列終了日(系列IDが設定された場合のみ利用可能) | 系列の終了日の基準。各系列の最終エントリー日(系列ごと)または任意の系列で見つかった最新の日付(グローバル)。 | デフォルトは系列ごと |

| ターゲットおよび数値特徴量の集計と補完 | 平均と直近または合計とゼロのいずれかを使用してターゲットを集計します。 つまり、時間ステップの集計は、値の合計または平均値のいずれかを使用して作成されます。 集計後も欠損しているターゲット値がまだある場合は、ターゲット値としてゼロ(合計の場合)または直近の値(平均の場合)が補完されます。 |

はい |

| カテゴリー特徴量の集約と補完 | 集約する時間ステップ内で最も頻繁に出現する値または直近の値を使用して、カテゴリー特徴量を集約します。 補完が適用されるのは、系列内で一定の特徴量(交差系列の groupby 列など)に対してのみであり、系列内で一定になるように補完されます。 | はい |

| テキスト特徴量の集約と補完(テキスト特徴量が存在する場合のみ使用可能) | 無視するを選択してテキスト特徴量の処理をスキップするか、以下で集約します。• 最も頻繁に出現するテキスト値 • 直近のテキスト値• テキスト値の すべてを連結する• テキスト長の合計• テキスト長の平均 |

はい |

| 時間ステップ:新しいデータセットの行間で検出された中央値の時間デルタを構成するコンポーネント(頻度と単位)。 たとえば、15(頻度)日(単位)です。 | ||

| 頻度 | 時間ステップを構成する(時間)単位の数。 | デフォルトは検出済み |

| 単位 | 時間ステップを構成する時間単位(秒、日、月など)。 | デフォルトは検出された単位 |

すべての必須フィールドに入力すると、次の3つのオプションが使用可能になります。

-

実行をクリックして、クエリー(結果のデータセット)の最初の10,000件の結果をプレビューする。

備考

出力が大きすぎると、プレビューの実行に失敗する可能性があり、代わりにコンソールにアラートが返されます。 ただし、データセットをAIカタログに保存することはできます。

-

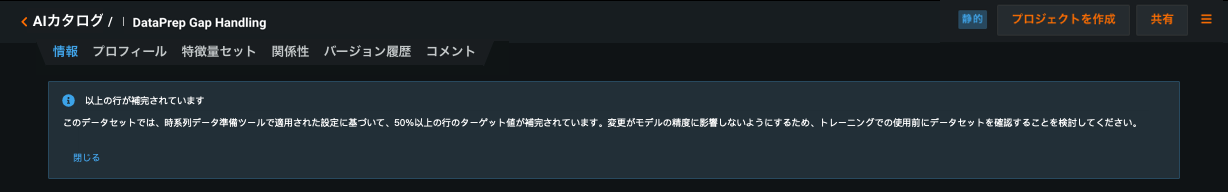

保存をクリックして、AIカタログに新しいSpark SQLデータセットを作成します。 そのデータセットの情報タブが開きます。データセットは、AIカタログのSpark SQLデータセット向けのオプション(新規プロジェクトの作成など)で使用できます。 データセットに50%を超える補完行がある場合、DataRobotは注意メッセージを提供します。

-

Spark SQLクエリーを編集するをクリックして、Spark SQLエディターを開き、最初のクエリーを変更します。

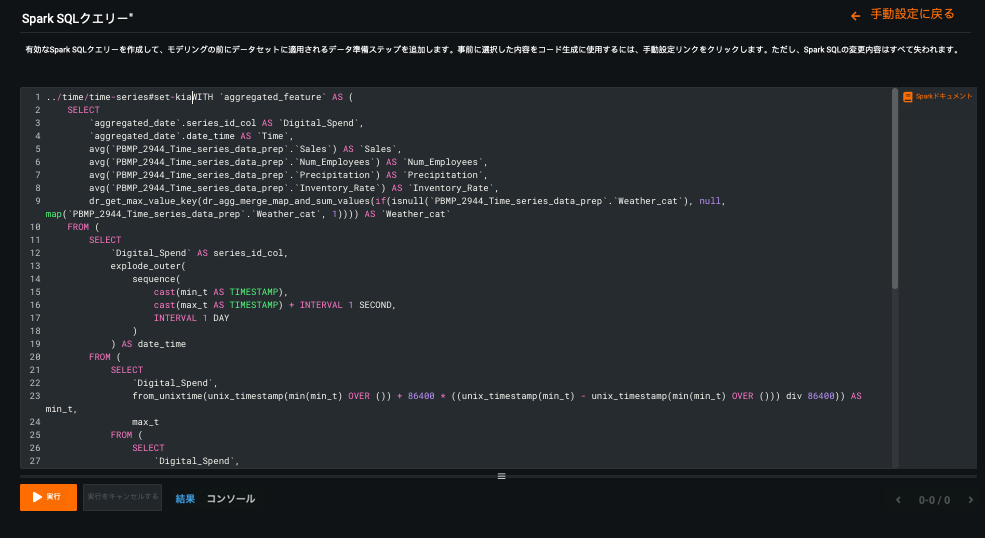

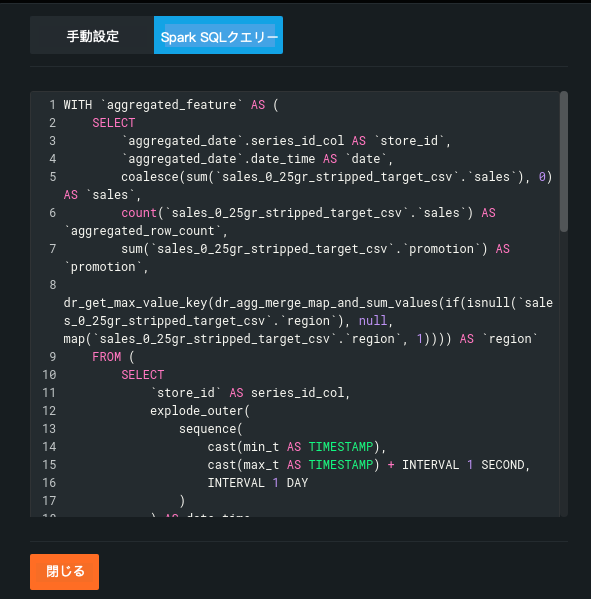

Spark SQLクエリーの編集¶

手動設定を完了し、Spark SQLクエリーを編集するをクリックすると、DataRobotは手動設定に基づき、編集ウィンドウに初期クエリーを入力します。 このスクリプトは他のSpark SQLクエリーと同様にカスタマイズ可能で、このスクリプトを使用して、新規データセットを作成することや既存のデータセットの新しいバージョンを作成することができます。

変更が完了したら、実行をクリックして結果をプレビューします。 問題がなければ、保存をクリックして新しいデータセットをAIカタログに追加します。 または、手動設定に戻るをクリックして、ドロップダウンベースのエントリーに戻ります。 Spark SQLクエリー設定から手動設定に切り替えるとSpark SQLデータセットの準備内容がすべて失われるので、変更を元に戻す方法として使用できます。 データセットに50%を超える補完行がある場合、DataRobotは注意メッセージを提供します。

備考

クエリーを更新してから、新しいAIカタログSpark SQLアイテムとして保存しようとすると、予測に使用できなくなります。 この場合、DataRobotは注意メッセージを表示します。 更新されたクエリーを保存するか、初期クエリーで保存するか、何も実行せずにウィンドウを閉じるかを選択できます。 更新されたクエリーを保存すると、データセットは標準のSparkデータセットとして保存されます。

値の補完¶

これらの補完の考慮事項に留意してください。

-

事前に既知:時系列データ準備ツールはターゲット値を補完するため、ターゲットリーケージのリスクがあります。 これは、特徴が事前に既知(KA)の場合のターゲットの補完と特徴値の相関関係によるものです。 すべてのKA機能は、補完リーケージがないかチェックされ、リーケージが検出された場合は、時系列特徴量の派生を実行する前にKAから削除されます。

-

系列内の数値特徴量:数値特徴量が系列内で一定である場合、それらを合計集計で処理すると問題が発生する可能性があります。 たとえば、出力データセットの日付が複数の入力行を集計する場合、その結果、数値列が交差系列のグループ別の列になる資格がなくなる可能性があります。 プロジェクトで、値を集計ではなく系列内で一定に保つ必要がある場合は、データ準備ツールを実行する前に、数値をカテゴリーに変換してください。

特徴量の補完¶

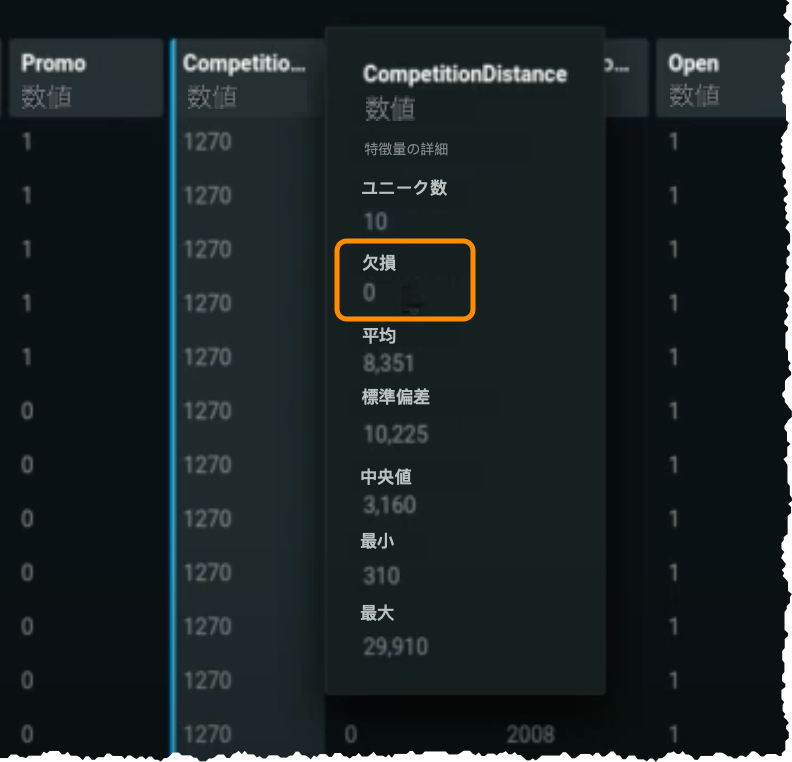

トレーニングや予測に使用する前にデータセットを確認して、変更が精度に影響を与えないことを確認することをお勧めします。 これを行うには、AIカタログで「新しい」データセットを選択し、プロフィールタブを開きます。 新しい列が表示されます—aggregated_row_count。 列の値をスクロールします。行の0は、値が補完されたことを示します。

他の非ターゲット特徴量にも欠損値がないことに注意してください(フォワードフィルする値がない各系列の先頭の先行値を除いて)。 特徴量の補完は、時系列データの準備を適用するときに、すべての特徴量(ターゲットおよびその他)の補完を有効にするためにフォワードフィリングを使用します。

補完注意¶

データ準備ツールで変更を加えた結果、ターゲット行の50%以上が補完された場合、DataRobotは次の両方で注意します。

モデルの構築¶

データセットが準備されたら、それを使用してプロジェクトを作成できます。 AIカタログから新しいデータセットをアップロードすると、EDA1が完了した後、不規則な時間ステップを示す注意が消え、予測ウィンドウの設定に行ではなく期間が表示されることに注意してください。

データ準備中の補完による事前に既知の特徴量からのターゲットリーケージがないようにするために、DataRobotは補完リーケージチェックを実行します。 チェックはEDA2中に実行され、データ品質評価の一部として表示されます。

チェックでは、KA特徴量を調べて、入力された行がリークされていないかどうかを確認します。 ターゲットリーケージチェックに似ていますが、代わりにis_imputedをターゲットとして使用します。 特徴量のリーケージが見つかった場合、その特徴量の事前に既知のステータスは削除され、プロジェクトが続行されます。

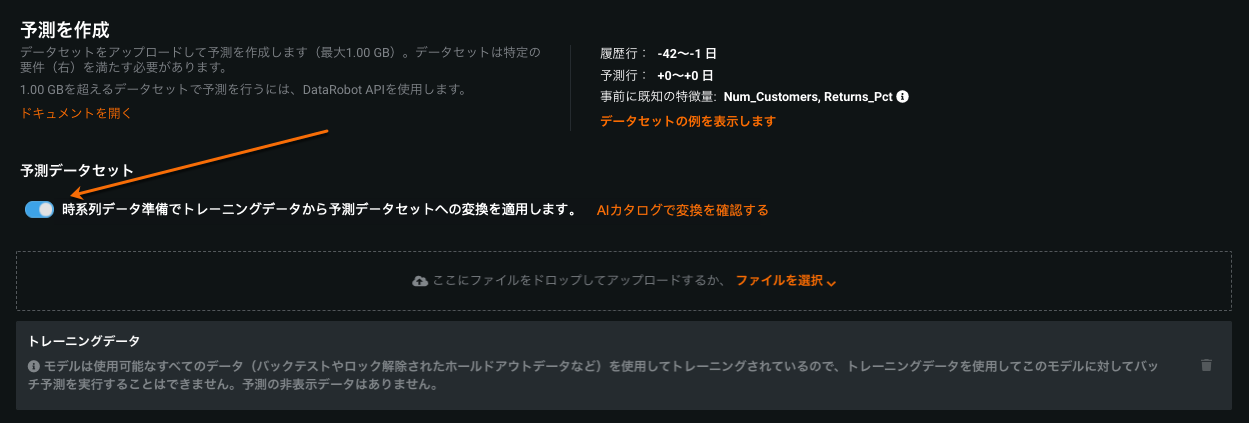

予測の作成¶

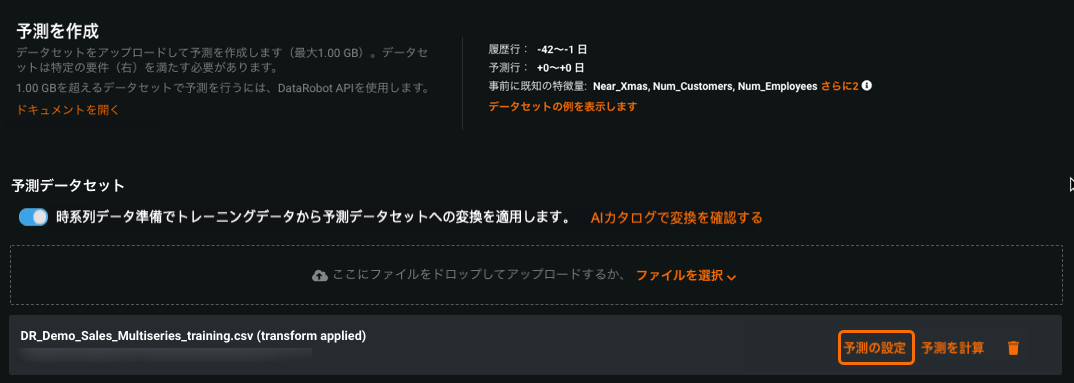

データ準備ツールによって変更されたデータセットからプロジェクトが作成されると、対応する予測データセットに変換を自動的に適用できます。 予測を作成タブで、オプションを切り替えて選択します。

オンの場合、DataRobotはアップロードしたデータセットに同じ変換を適用します。 AIカタログで変換を確認するをクリックして、手動およびSparkSQL設定の読み取り専用バージョンを表示します。次に例を示します。

データセットがアップロードされたら、予測の設定を構成します。 (予測ポイントを使用して特定の日付を選択するか、または予測範囲を使用して選択した範囲内のすべての予測距離を予測します。)

備考

予測ポイント予測には、予測ポイントを指定する必要があります。 DataRobotは、最新の有効なタイムスタンプ(ツールを使用しない場合のデフォルト)を適用しません。

準備されたデータセットから構築されたモデルをデプロイする場合、デプロイセクションの予測を作成タブでは、時系列データの準備変換を適用することもできます。

時系列データ準備ツールを使用する際の考慮事項も参照してください。