チャレンジャータブ¶

本機能の提供について

チャレンジャータブはDataRobot MLOpsユーザー専用の機能です。 この機能を有効にする方法については、DataRobotの担当者にお問い合わせください。

モデルの開発中、運用環境にデプロイするモデルが選択されるまで多くのモデルを比較することがあります。 チャレンジャータブを使用してデプロイ後のモデル比較を続行できます。 デプロイされたモデルをシャドーイングするチャレンジャーモデルを送信し、デプロイされたモデルで行われた予測を再実行できます。 チャレンジャーモデルによって行われた予測を現在デプロイされているモデル(「チャンピオン」)と比較して、より適切な優れたDataRobotモデルがあるかどうかを判断できます。

チャレンジャーモデルの有効化¶

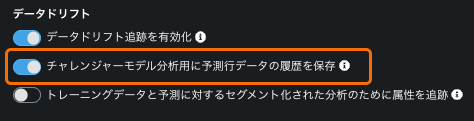

デプロイのチャレンジャーモデルを有効にするには、チャレンジャータブおよび予測行ごとの履歴保存を有効にする必要があります。 これを行うには、デプロイの作成時、またはチャレンジャー > 設定タブで、デプロイのデータドリフトを設定します。 チャレンジャーモデルを有効にすると、予測行ごとの履歴保存が自動的にデプロイで有効になります。 チャレンジャーに必要なため、オフにすることはできません。

本機能の提供について

チャレンジャーを有効にし、それらで予測を再実行するには、デプロイ済みモデルがターゲットドリフト追跡をサポートしている必要があり、また、 特徴量探索あるいは 非構造化カスタム推論モデルではないことが条件です。

チャレンジャーモデルの選択¶

チャレンジャーモデルをデプロイに追加する前に、チャレンジャーとして追加するモデルを最初にビルドして選択する必要があります。 モデリングプロセスを完了してリーダーボードからモデルを選択するか、モデルパッケージとしてカスタムモデルをデプロイします。 チャレンジャーモデルを選択するときは、次の点に注意してください。

- チャンピオンモデルと同じターゲットタイプである必要があります。

- 既存のチャンピオンやチャレンジャーと同じリーダーボードモデルにすることはできません。各チャレンジャーは一意のモデルである必要があります。 同じリーダーボードモデルから複数のモデルパッケージを作成する場合、それらのモデルを同じデプロイでチャレンジャーとして使用することはできません。

- 特徴量探索モデルにすることはできません。

- チャンピオンモデルと同じ特徴量セットでトレーニングする必要はありませんが、いくつかの特徴量を共有している必要があります。ただし、予測の再実行を正常に行うには、チャンピオンとチャレンジャーに必要なすべての特徴量の和集合を予測として利用する必要があります

- チャンピオンモデルと同じプロジェクトから構築する必要はありません。

チャレンジャーとして機能するモデルを選択したら、リーダーボードから予測 > デプロイを選択し、登録してデプロイを選択します。 選択したモデルの登録されているモデルバージョンがモデルレジストリに作成され、モデルをチャレンジャーとしてデプロイに追加できます。

デプロイへのチャレンジャーの追加¶

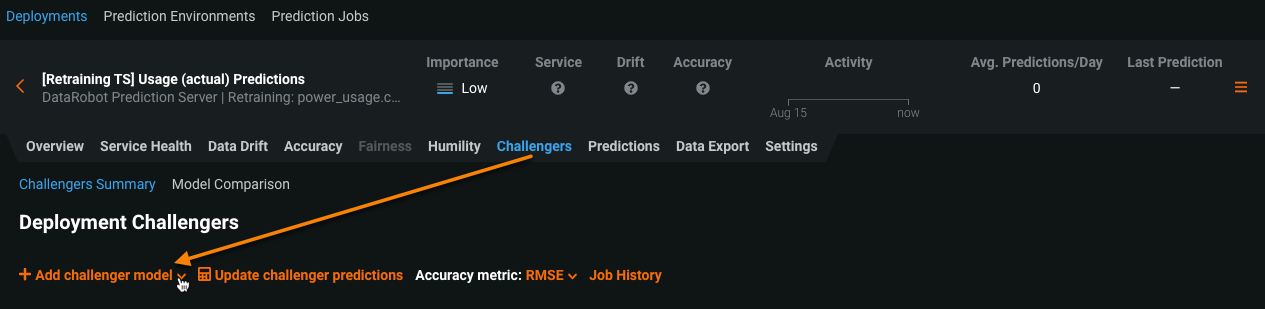

チャレンジャーモデルをデプロイに追加するには、チャレンジャータブを選択して+チャレンジャーモデルを追加 > 既存のモデルを選択を選択します。 各デプロイに最大4つのチャレンジャーモデルを追加できます。 つまり、チャンピオンモデルを含めると、チャレンジャー分析では合計で最大5つのモデルを比較できます。

備考

選択リストには、ターゲットのタイプと名前がチャンピオンモデルと同じであるモデルパッケージしか含まれていません。

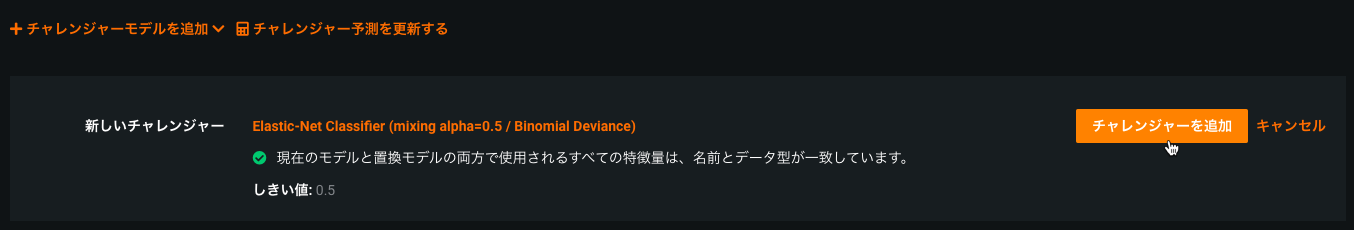

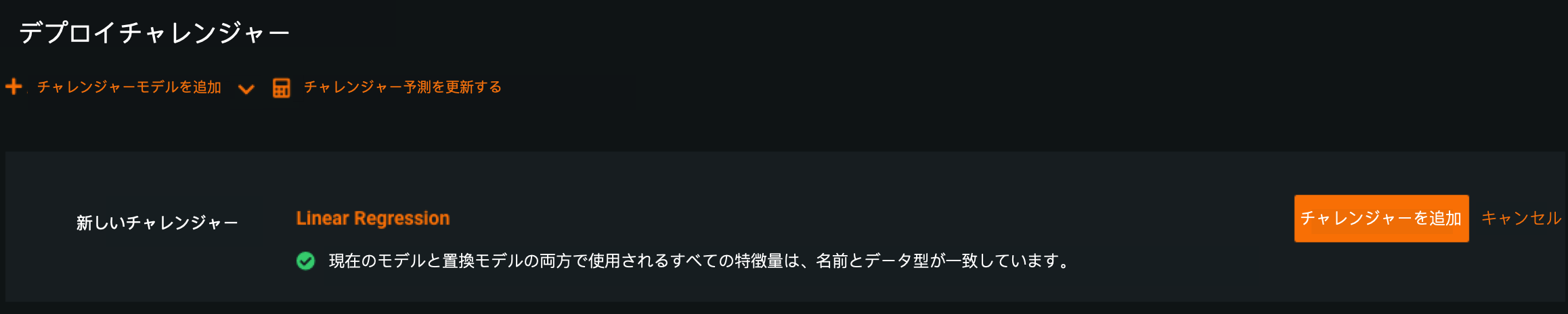

チャレンジャーモデルとして機能するモデルパッケージをレジストリから選択するように求めるモーダルが表示されます。 追加するモデルを選択してモデルのバージョンを選択をクリックします。

モデルが特徴量とターゲットタイプをチャンピオンモデルと共有していることが検証されます。 検証が完了したらチャレンジャーを追加をクリックします。 モデルがチャレンジャーとしてデプロイに追加されます。

予測の再実行¶

チャレンジャーモデルを追加したら、チャンピオンモデルで作成された保存済み予測をすべてのチャレンジャーで再実行できます。これにより、各モデルの予測値、精度、データエラーなどのパフォーマンス指標を比較できます。

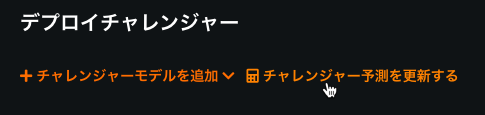

予測を再実行するには、チャレンジャー予測を更新するを選択します。

チャンピオンモデルは、1時間あたり最大100,000の予測行を計算して保存します。 日付スライダーで指定した時間範囲内で、1時間ごとに行われた予測リクエストの最初の10,000行がチャレンジャーで再実行されます。 時系列デプロイの場合、この制限は適用されません。 すべての予測データは、統計を比較するためにチャレンジャーによって使用されます。

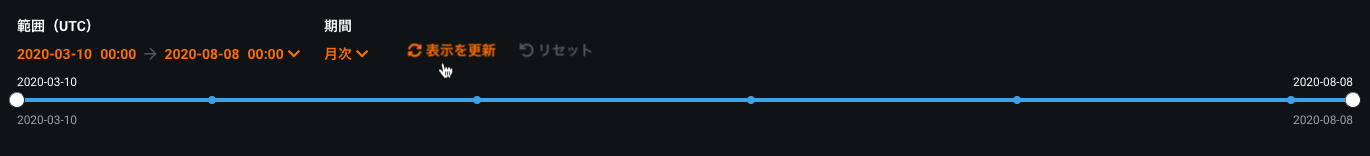

予測が作成された後、日付スライダーで表示を更新をクリックして、チャレンジャーモデルのパフォーマンス指標の更新された表示を表示します。

予測の再実行をスケジュールする¶

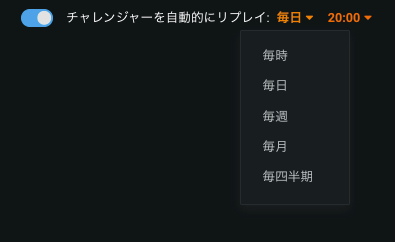

手動で行う代わりに、定期的なスケジュールでチャレンジャーを使用して予測を再実行できます。 デプロイのチャレンジャー > 設定タブに移動し、チャレンジャー予測を自動的に再計算トグルを有効にして、予測の再実行に望ましい頻度と時間を設定します。

備考

チャレンジャーの予測再実行をスケジュールできるのは、デプロイオーナーだけです。

有効にすると、すべてのチャレンジャーに対して設定された時間に再実行がトリガーされます。 過去に予測リクエストが作成されたデプロイがあり、チャレンジャーを追加した場合、スケジュールされたジョブは、次の実行サイクルで新しく追加されたチャレンジャーモデルをスコアリングします。

チャレンジャージョブ履歴の表示¶

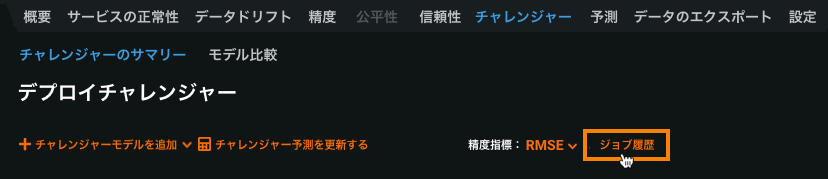

1つ以上のチャレンジャーモデルを追加して予測を再実行した後、 デプロイ > 予測ジョブページでデプロイのチャレンジャーのチャレンジャー予測ジョブを表示できます。

チャレンジャー予測ジョブを表示するには、ジョブ履歴をクリックします。

[予測ジョブ]ページが開き、フィルターされて、ジョブ履歴にアクセスしたデプロイのチャレンジャージョブが表示されます。

チャレンジャーモデルの概要¶

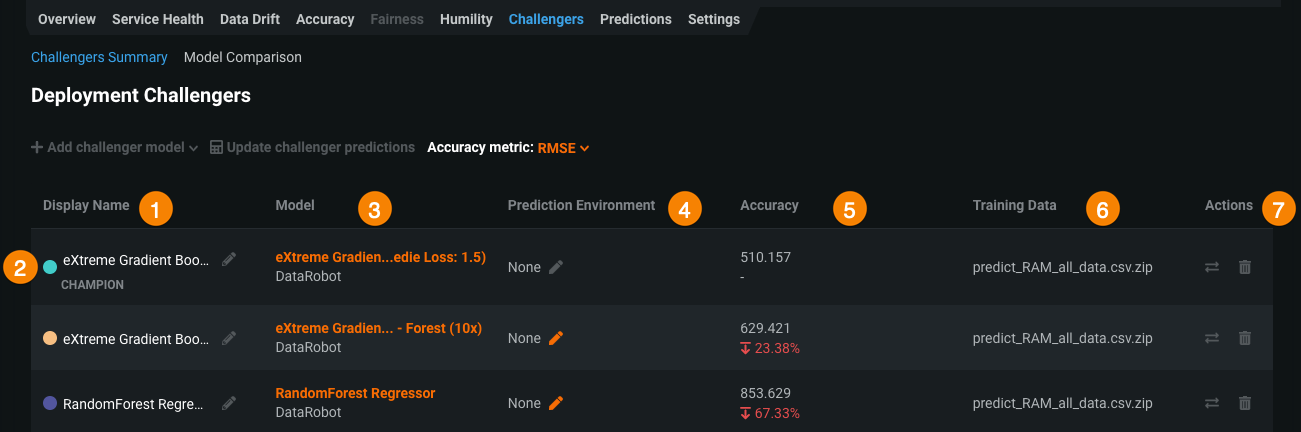

チャレンジャータブには、チャンピオンモデルと各チャレンジャーに関する情報が表示されます。

| 要素 | 説明 | |

|---|---|---|

| 1 | 表示名 | 各モデルの表示名。 鉛筆アイコンを使用して表示名を編集します。 このフィールドは、各チャレンジャーの目的または戦略を説明するのに役立ちます(「リファレンスモデル」、「以前のチャンピオン」、「削減済み特徴量」など)。 |

| 2 | チャレンジャーモデル | チャレンジャーモデルのリスト。 各モデルは色で関連付けられています。 これらの色で、視覚化ツールを使用してモデルを比較できます。 |

| 3 | モデルのデータ | 各モデルのメタデータ(プロジェクト名、モデル名、実行環境タイプなど)。 |

| 4 | 予測環境 | モデルがデプロイの予測に使用する環境。 詳細については、予測環境を参照してください。 |

| 5 | 精度 | 選択した日付範囲のモデルの精度指標計算、およびチャレンジャーの場合は、チャンピオンの精度指標計算との比較。 精度指標ドロップダウンメニューを使用すると、さまざまな指標を比較できます。 モデルの精度の詳細については、精度チャートを参照してください。 |

| 6 | トレーニングデータ | モデルのトレーニングに使用されるデータのファイル名。 |

| 7 | アクション | 各モデルで使用できるアクション:

|

チャレンジャーのパフォーマンス指標¶

チャレンジャーモデルで予測データが再実行されたら、各モデルに記録されたさまざまなパフォーマンス指標をとらえたチャートが以下に表示されるので、内容を確認します。

各モデルは、対応する色でリストされています。 チャートへのモデルのパフォーマンスデータの表示を停止するには、モデルのボックスをオフにします。

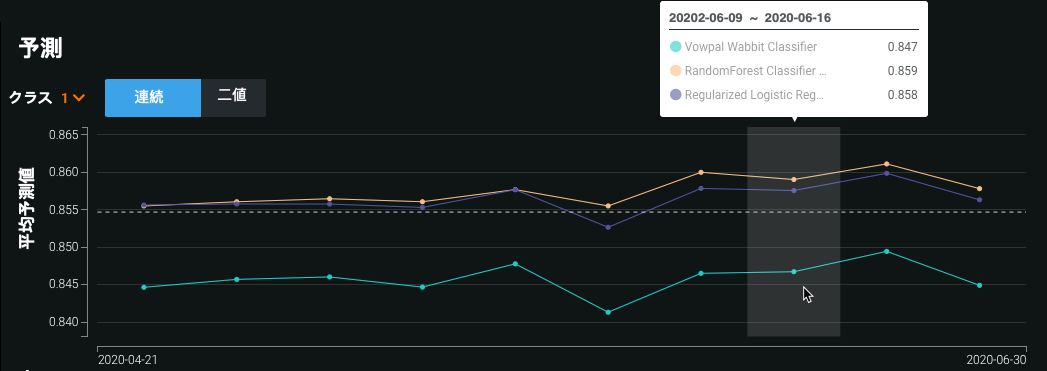

予測チャート¶

予測チャートは、時間の経過に伴う各モデルのターゲットの平均予測値を記録します。 ポイントにカーソルを合わせると、特定の時点での各モデルの平均値が比較されます。

二値分類プロジェクトの場合、クラスドロップダウンを使用して、平均予測値を分析するクラスを選択します。 チャートには、連続モードと二値モードを切り替えるためのトグルも含まれています。 連続モードでは、予測しきい値を考慮せずに、Positiveクラス予測を0と1の間の確率として示します。 予測しきい値は考慮に入れられません。二値モードでは、予測しきい値が考慮に入れられ、作成されたすべての予測では各クラスのパーセンテージが示されます。

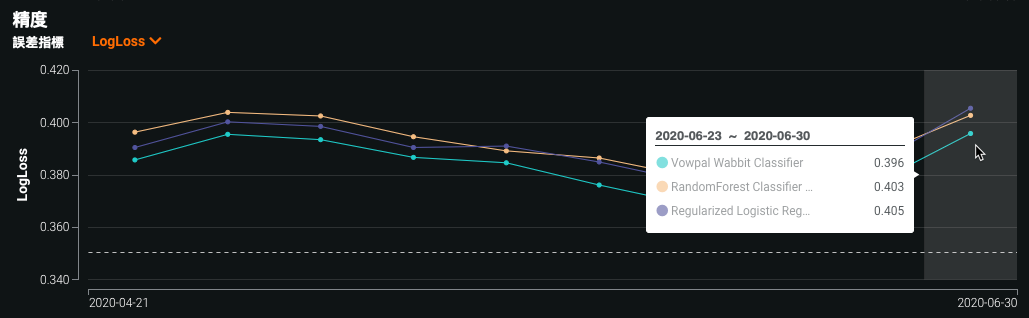

精度チャート¶

精度チャートには、選択した精度指標値(この例ではLogLoss)の時間経過に伴う変化が表示されます。 これらの指標は、デプロイ前にモデルの評価に使用される指標と同一です。 精度指標を変更するには、ドロップダウンを使用します。 デプロイのモデリングタイプでサポートされているいずれかの指標を選択できます。

重要

予測を精度追跡に含めるには、予測を行う前に関連付けIDを設定する必要があります。

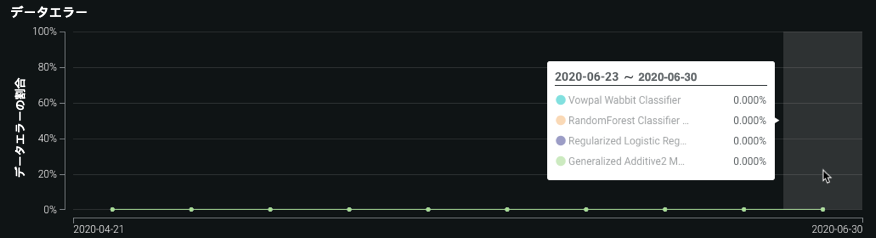

データエラーチャート¶

データエラーチャートは、時間の経過に伴う各モデルのデータエラー率を記録します。 データエラー率は 4xxエラーが発生したリクエストの割合(予測リクエスト送信の問題)を測定します。

チャレンジャーモデルの比較¶

MLOpsは、チャレンジャーモデルを相互に比較したり、現在デプロイされているモデル(「チャンピオン」)と比較したりして、デプロイがお客様のニーズに最適なモデルを使用するようにします。 DataRobotのモデル比較ビジュアライゼーションを評価した後、チャンピオンモデルをよりパフォーマンスの高いチャレンジャーに置き換えることができます。

DataRobotは、選択した専用の比較データセットに基づいてビジュアライゼーションをレンダリングし、同じデータセットとパーティションに基づいて予測を比較しながら、異なるデータセットでチャンピオンモデルとチャレンジャーモデルをトレーニングできるようにします。 たとえば、チャレンジャーモデルでは、チャンピオンに使用されるチャンピオンと同じデータソースの更新済みスナップショットを使用できます。

注意

比較データセットが、比較対象モデルのアウトオブサンプルであることを確認してください(つまり、比較に含まれるモデルのトレーニングデータが含まれていません)。

モデルの比較を生成する¶

チャレンジャーを有効化し、1つ以上のチャレンジャーをデプロイに追加した後、比較データとビジュアライゼーションを生成できます。

-

デプロイページで、比較するチャンピオンモデルとチャレンジャーモデルがあるデプロイを見つけて展開します。

-

チャレンジャータブをクリックします。

-

チャレンジャーサマリータブで、必要に応じて、チャレンジャーモデルを追加し、チャレンジャーの予測を再実行します。

-

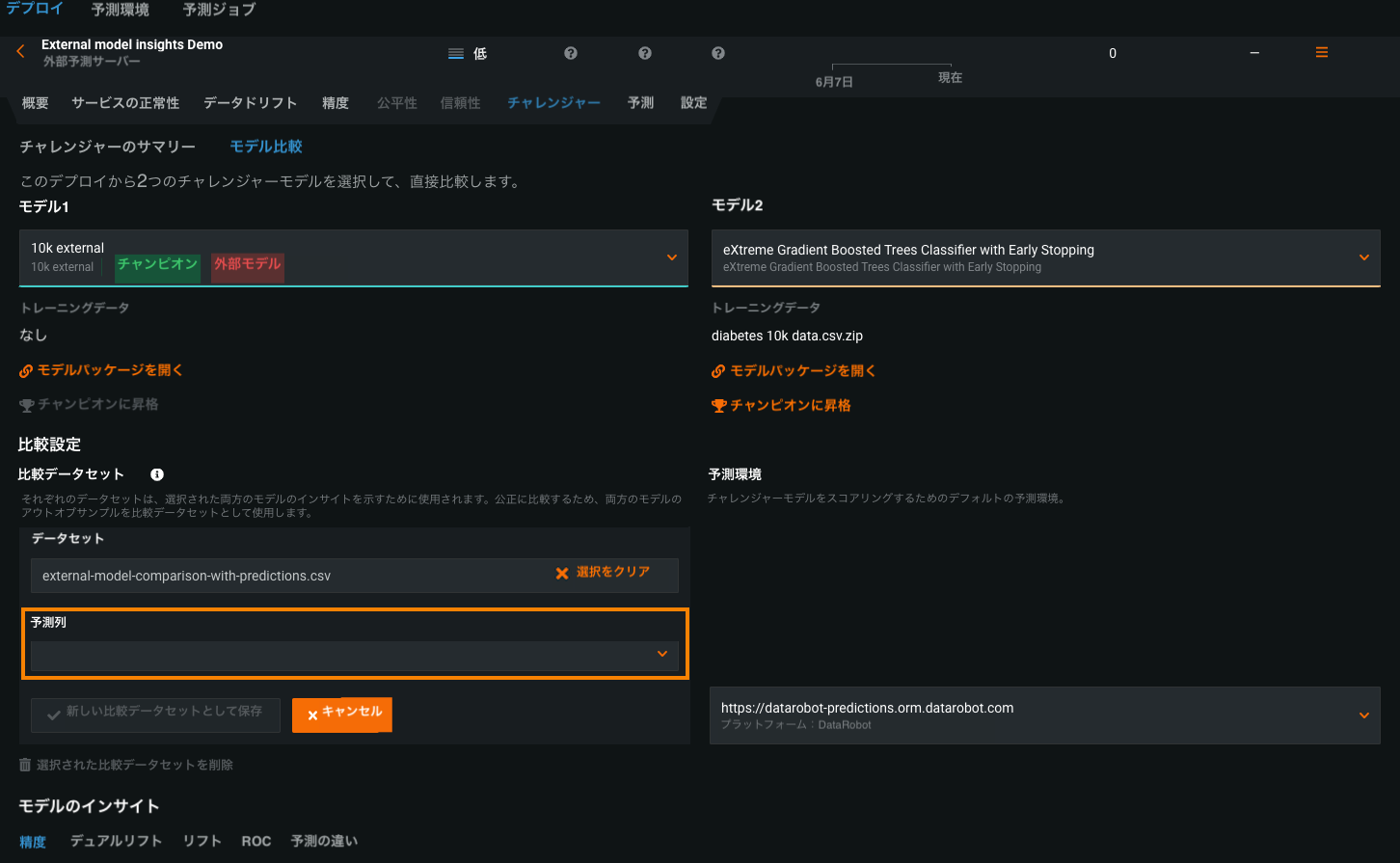

モデル比較タブをクリックします。

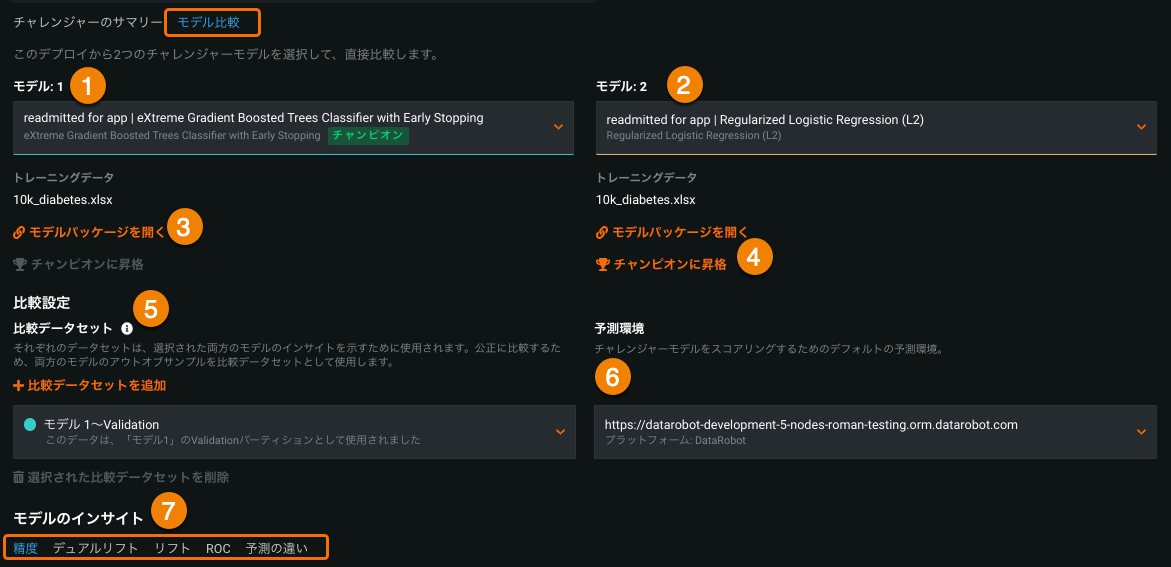

次の表はモデル比較タブの要素を示しています。

要素 説明 1 モデル1 デフォルトは、チャンピオンモデル(現在デプロイされているモデル)です。 クリックして比較する別のモデルを選択します。 2 モデル2 デフォルトは、リストの最初のチャレンジャーモデルです。 クリックして比較する別のモデルを選択します。 リストにモデル1と比較するモデルが含まれていない場合は、チャレンジャーサマリータブをクリックして新しいチャレンジャーを追加します。 3 モデルパッケージを開く クリックしてモデルの詳細を表示します。 詳細はモデルレジストリのモデルパッケージタブに表示されます。 4 チャンピオンに昇格 比較のチャレンジャーモデルが最適なモデルである場合は、チャンピオンに昇格をクリックし、デプロイされたモデル(「チャンピオン」)をこのモデルに置き換えます。 5 比較データセットを追加 両方のモデルのインサイトを生成するデータセットを選択します。 必ず、両方のモデルのアウトオブサンプルであるデータセットを選択してください(スタックされた予測を参照)。 モデル1とモデル2のホールドアウトおよび検証パーティションは、これらのパーティションが元のモデルに存在する場合、オプションとして使用できます。 デフォルトでは、モデル1のホールドアウトパーティションが選択されています。 別のデータセットを指定するには、+ 比較データセットを追加をクリックして、AIカタログからローカルファイルまたはスナップショットが取得されたデータセットを選択します。 6 予測環境 両方のモデルをスコアリングする予測環境を選択します。 7 モデルのインサイト モデル予測、指標などを比較します。 -

チャレンジャーページのモデルのインサイトセクションにスクロールし、インサイトを計算をクリックします。

+比較データセットを追加をクリックして、再度インサイトを計算を選択することで、別のデータセットを使用して新しいインサイトを生成できます。

モデル比較を表示¶

モデルのインサイトを計算すると、モデルインサイトページには、プロジェクトの種類に応じて次のタブが表示されます。

備考

多クラス分類プロジェクトは、精度比較のみをサポートします。

| 精度 | デュアルリフト | リフト | ROC | 予測の違い | |

|---|---|---|---|---|---|

| 連続値 | ✔ | ✔ | ✔ | ✔ | |

| 二値 | ✔ | ✔ | ✔ | ✔ | ✔ |

| 多クラス | ✔ | ||||

| 時系列 | ✔ | ✔ | ✔ | ✔ |

DataRobotがデプロイのモデルインサイトを計算した後、モデルの精度を比較できます。

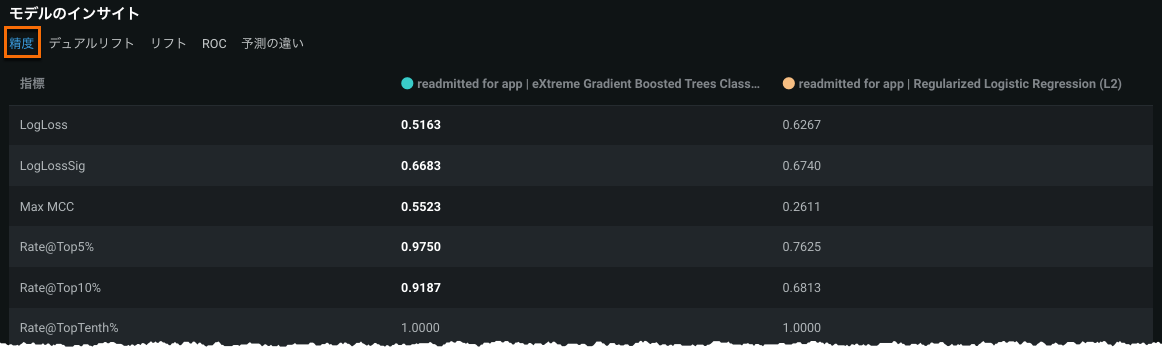

モデルのインサイトの下で、精度タブをクリックして精度指標を比較します。

2つの列は、各モデルの指標を示しています。 強調表示された数字は好ましい値を表しています。 この例では、チャンピオンのモデル1は表示されているほとんどの指標でモデル2よりも優れています。

時系列プロジェクトの場合、次のフィルターを適用して精度指標を評価できます。

-

すべてのx系列の場合:指標別の精度スコアを表示します。 このビューは、時系列範囲(x)全体にわたる両方のモデルで利用可能なすべての精度指標のスコアを報告します。

-

系列ごと:複数系列比較データセット内の系列ごとの精度スコアを表示します。 このビューは、両方のモデルのデータセット内の各系列ID(つまり、ストア番号)の単一の精度指標(指標ドロップダウンメニューで選択)のスコアを報告します。

多クラスプロジェクトの場合、次のフィルターを適用して精度指標を評価できます。

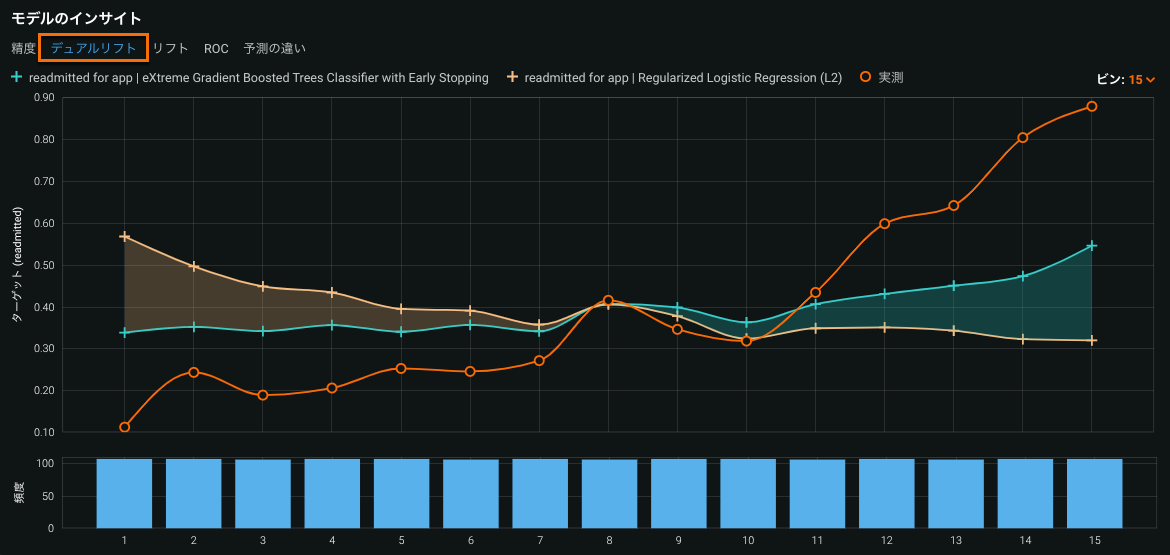

デュアルリフトチャート は、選択した2つのモデルを相互に比較するビジュアライゼーションです。 このビジュアライゼーションにより、モデルが予測の分布全体で実測値を過小予測または過大予測する方法を確認できます。 予測データは、昇順で同じサイズのビンに均等に分布されます。

モデルのインサイトの下で比較される2つのモデルのデュアルリフトチャートを表示するには、デュアルリフトタブをクリックします。

このチャートに示されている2つのモデルの曲線は、(チャンピオンまたはチャレンジャーとして)デプロイに追加されたときに割り当てられた色を維持します。 デュアルリフトチャートを操作するには、モデル曲線と実際の曲線を非表示にすることができます。

- チャートのプロット領域にある+アイコンは、モデルの予測値を表します。 ヘッダーのモデル名の横にある+アイコンをクリックすると、特定のモデルの曲線の表示/非表示が切り替わります。

- チャートのプロット領域にあるオレンジ色のoアイコンは、実測値を表します。 実測値の横にあるオレンジ色のoアイコンをクリックすると、実測値を表示する曲線の表示/非表示が切り替わります。

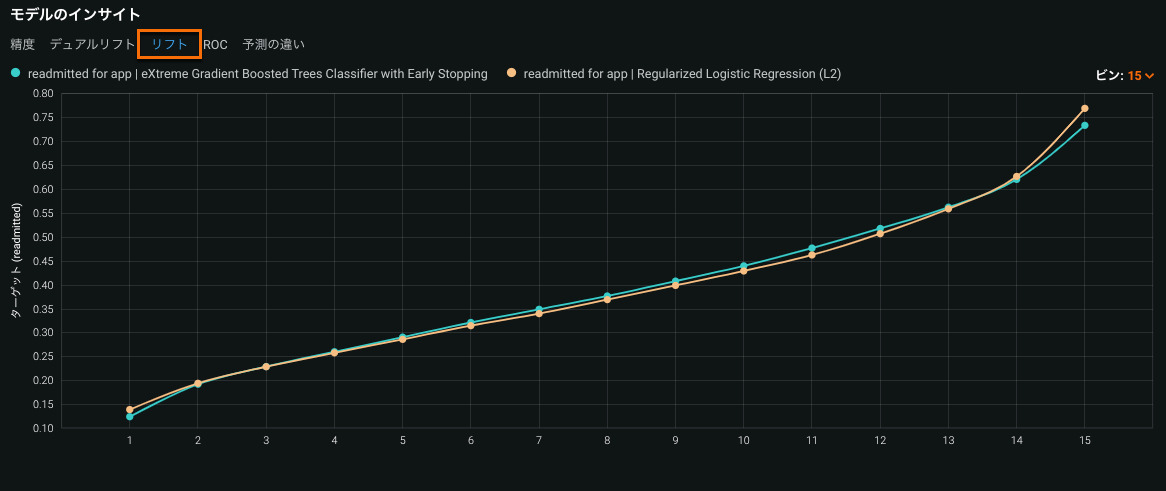

リフトチャートは、モデルがターゲットの母集団をどの程度うまく分割しているか、そしてターゲットを予測することができるかを示し、モデルの有効性を視覚化できます。

比較されるモデルのリフトチャートを表示するには、モデルのインサイトの下でリフトタブをクリックします。

このチャートに示されている2つのモデルの曲線は、(チャンピオンまたはチャレンジャーとして)デプロイに追加されたときに割り当てられた色を維持します。

備考

[ROC]タブは二値分類プロジェクトでのみ使用できます。

あるデータソースに基づき、True Positive RateをFalse Positive Rateに対比させる形でプロットしたものがROC曲線です。 ROC曲線を使用して、比較するモデルの分類、パフォーマンス、統計を調査します。

比較されるモデルのROC曲線を表示するには、モデルのインサイトの下でROCタブをクリックします。

このチャートに示されている2つのモデルの曲線は、(チャンピオンまたはチャレンジャーとして)デプロイに追加されたときに割り当てられた色を維持します。 鉛筆アイコンをクリックして、モデルの予測しきい値を更新できます。

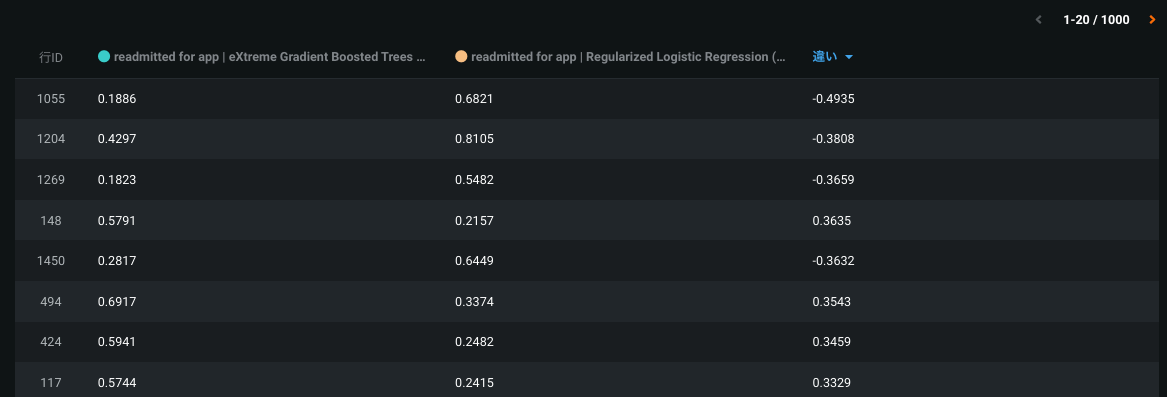

予測の違いタブをクリックして、2つのモデルの予測を1行ごとに比較します。 ヒストグラムには、予測一致しきい値フィールドで指定した一致しきい値内にある予測の割合が(対応する行数とともに)表示されます。

ヒストグラムのヘッダーには、予測のパーセンテージが表示されます。

- 一致しきい値の正の値と負の値の間(緑色で表示)

- 一致しきい値の上限(正)より大きい(赤で表示)

- 一致しきい値の下限(負)より小さい(赤で表示)

ビンサイズの計算方法

ヒストグラムの予測の違いビンのサイズは、設定した予測一致しきい値によって異なります。 予測一致しきい値ビンの値は、一致しきい値の上限(正)と一致しきい値の下限(負)の差に等しくなります。 デフォルトの予測一致しきい値は0.0025であるため、その値の場合、中央のビンは0.005(0.0025 + | -0.0025 | )。 中央のビンの両側のビンは、前のビンの10倍の大きさです。 両端の最後のビンは、予測の違いの範囲全体に合うように拡大されます。 たとえば、デフォルトの予測一致しきい値に基づくと、ビンのサイズは次のようになります(xは250と最大予測値の違いの差):

| ビン-5 | ビン-4 | ビン-3 | ビン-2 | ビン-1 | ビン0 | ビン1 | ビン2 | ビン3 | ビン4 | ビン5 | |

|---|---|---|---|---|---|---|---|---|---|---|---|

| 範囲 | (−250 + x)~−25 | −25~−2.5 | −2.5~−0.25 | −0.25~−0.025 | −0.025~−0.0025 | −0.0025~+0.0025 | +0.0025~+0.025 | +0.025~+0.25 | +0.25~+2.5 | +2.5~+25 | +25~(+250 + x) |

| 範囲 | 225 + x | 22.5 | 2.25 | 0.225 | 0.0225 | 0.005 | 0.0225 | 0.225 | 2.25 | 22.5 | 225 + x |

ヒストグラムを希釈する一致が多数ある場合は、y軸をスケールして完全一致を無視を切り替えて不一致にフォーカスできます。

予測の違いタブの下部セクションには、1000個の最も異なる予測(絶対値)が示されています。

違い列は予測がどの程度離れているかを示します。

チャンピオンをチャレンジャーに置き換える¶

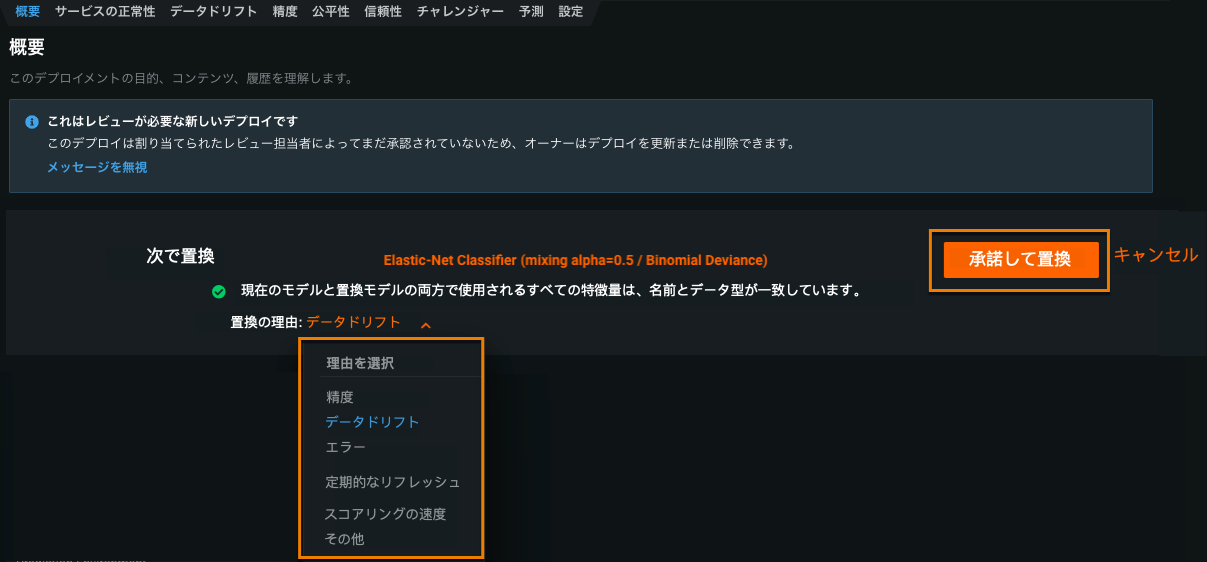

モデルを比較した後、デプロイされたモデルを上回るモデルを見つけたら、それを新しいチャンピオンとして設定できます。

-

比較モデルのインサイトを評価して、最高のパフォーマンスを実行するモデルを決定します。

-

チャレンジャーモデルがデプロイ済みモデルを上回る場合は、チャンピオンに昇格をクリックします。

-

置換の理由を選択して、承諾して置換をクリックします。

チャレンジャーモデルがチャンピオン(デプロイ済み)モデルになります。

外部デプロイ用のチャレンジャー¶

リモート予測環境を使用した外部デプロイでは、チャレンジャータブも使用できます。 リモートモデルはチャンピオンモデルとして機能し、DataRobotやチャレンジャーとして機能するカスタムモデルと比較できます。

チャレンジャーモデルを追加する際の ワークフローはほぼ同じですが、外部デプロイには以下のような独自の違いがあります。

外部デプロイへのチャレンジャーモデルの追加¶

チャレンジャーのサポートを有効にするには、外部デプロイ(外部モデルパッケージで作成されたデプロイ)にアクセスします。 設定タブのデータドリフトヘッダーで、チャレンジャーモデルと予測行ストレージを有効にします。

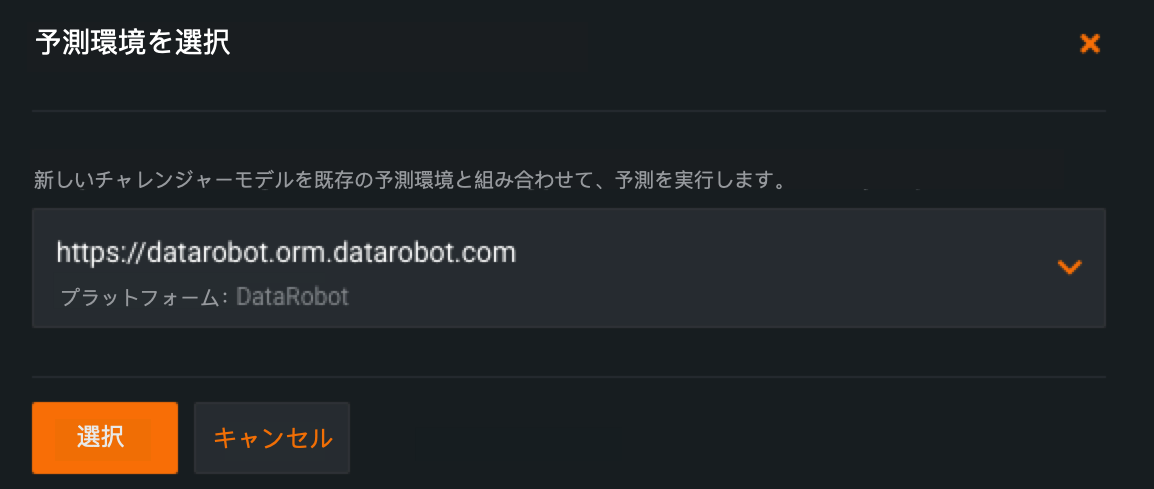

これでチャレンジャータブにアクセスできるようになります。 チャレンジャーモデルをデプロイに追加するには、チャレンジャータブを選択してチャレンジャーモデルを追加 > 既存のモデルを選択を選択します。

追加するチャレンジャーのモデルパッケージを選択します(カスタムモデルとDataRobotモデルのみ)。 また、モデルパッケージで使用される予測環境を指定する必要もあります。これは、モデルが予測を実行する場所の詳細です。 DataRobotまたはカスタムモデルは、チャレンジャーモデルにDataRobot予測環境のみ使用できます(チャンピオンモデルとは異なり、外部予測環境にデプロイされます)。 目的の予測環境を選択したら、選択をクリックします。

タブが更新され、追加するモデルパッケージが表示されます。モデルパッケージで使用する特徴量がデプロイされたモデルと一致することを確認します。 チャレンジャーを追加を選択します。

モデルパッケージは現在、リモートデプロイのチャレンジャーモデルとして機能するようになりました。

外部モデルとチャレンジャーの比較用データセットを追加¶

外部モデルとチャレンジャーを比較するには、実測値と予測結果の両方を含むデータセットを提供する必要があります。 比較用のデータセットをアップロードする際に、予測結果を含む列を指定することができます。

外部モデルチャレンジャー用に比較データセットを追加するには、モデル比較の生成プロセスに従い、モデル比較タブで、予測列識別子を持つ比較データセットをアップロードします。 指定する予測データセットに、予測列で識別された場所にある外部モデルによって生成された予測結果が含まれていることを確認します。

外部デプロイ用のチャレンジャーの管理¶

さまざまなアクションを使用して、リモートデプロイのチャレンジャーモデルを管理できます。

-

チャレンジャーが使用する予測環境を編集するには、鉛筆アイコンを選択し、ドロップダウンから新しい予測環境を選択します。

-

デプロイされたモデルをチャレンジャーで置き換えるには、チャレンジャーに互換性のある予測環境が必要です。 置換後、リモートモデルは不適格になるため、チャンピオンはチャレンジャーになりません。

チャレンジャーのチャンピオンへの昇格¶

デプロイのチャンピオンは、外部予測環境とDataRobot予測環境を切り替えることはできません。 チャレンジャーが外部予測環境で実行されているチャンピオンと置き換わる場合、そのチャレンジャーは前のチャンピオンの外部環境を引き継ぎます。 管理エージェントが外部予測環境で設定されていない場合、予測を続行するには、新しいチャンピオンを外部環境に手動でデプロイする必要があります。

チャンピオンのチャレンジャーへの降格¶

前のチャンピオンが外部モデルパッケージでない場合は、DataRobotホスティングと互換性があり、チャレンジャーになる可能性があります。 そのシナリオでは、前のチャンピオンはDataRobot予測環境に移動し、デプロイは前のチャンピオンに対してチャンピオンの予測を再実行できます。